参考书籍:

《Netty实战》 第1版 Norman Maurer Marvin Allen Wolfthal 著 何品 译

一. 异步和事件驱动

Netty 是一款异步的事件驱动的网络应用程序框架,支持快速地开发可维护的高性能的面向协议的服务器和客户端。

1. Java网络编程

早期网络编程中,C语言套接字库因需处理多系统兼容性问题而极其复杂;尽管Java(1995-2002)通过面向对象门面模式(Façade)简化了部分细节,但实现复杂客户端/服务器协议仍依赖大量底层研究和冗长样板代码。

/*

* 关键阻塞点说明:

*

* 1. serverSocket.accept()

* - 线程冻结直到新TCP连接完成三次握手

* - 操作系统内核维护未决连接队列(backlog)

*

* 2. in.readLine()

* - 底层依赖TCP数据流解析

* - 必须收到明确行终止符(\n或\r)才会返回

* - 网络延迟可能导致长时间阻塞

*

* 设计后果:

* 此代码模型无法同时服务多客户端

* 需改造为多线程或NIO模型支持并发

*/

//阻塞IO示例

public class BlockingSocketServer

{

// =============== 初始化设置 ===============

private static final int PORT = 8080;

public static void main(String[] args) throws IOException

{

/*

* 步骤1:创建 ServerSocket 监听端口

* - 在指定端口打开服务端监听通道

* - 此时尚未建立任何连接

*/

ServerSocket serverSocket = new ServerSocket(PORT);

System.out.println("服务器启动,监听端口: " + PORT);

// =============== 连接处理循环 ===============

while (true)

{

/*

* 步骤2:等待客户端连接

* - accept() 阻塞当前线程直到客户端连接建立

* - 建立后返回新Socket用于客户端通信

* - ServerSocket 继续监听新连接 (保持运行)

*/

System.out.println("等待连接...");

Socket clientSocket = serverSocket.accept();

System.out.println("客户端连接: " + clientSocket.getRemoteSocketAddress());

// =============== 流对象初始化 ===============

/*

* 步骤3:建立输入/输出流

* - 核心原理: BufferedReader/PrintWriter 派生于Socket流对象

* - in: 读取客户端发送的文本数据流 (自动字符转换)

* - out: 自动刷新缓存的消息发送器 (autoFlush=true)

*/

BufferedReader in = new BufferedReader(

new InputStreamReader(clientSocket.getInputStream())

);

PrintWriter out = new PrintWriter(

clientSocket.getOutputStream(),

true // 自动刷新输出缓存

);

// =============== 请求处理循环 ===============

String request, response;

while (true)

{

/*

* 步骤4:读取客户端请求

* - readLine() 阻塞线程,直到收到数据结束符:

* ↑ 必须收到换行符(\n)或回车符(\r)

*/

request = in.readLine();

if (request == null) break; // 连接断开

/*

* 步骤5:特殊退出指令判断

* - 客户端发送"Done"时主动终止会话

*/

if ("Done".equals(request))

{

out.println("会话终止");

break;

}

/*

* 步骤6:请求处理与响应

* - 业务请求被传递到处理函数

* - 结果通过Socket通道返回客户端

*/

response = processRequest(request);

out.println(response); // 发送处理结果

}

// =============== 连接清理 ===============

clientSocket.close();

System.out.println("客户端连接关闭");

}

}

// =============== 业务处理逻辑 ===============

private static String processRequest(String request)

{

/*

* 业务逻辑处理示例:

* - 此处应实现实际业务逻辑

* - 本示例仅返回反转字符串

*/

return new StringBuilder(request).reverse().toString();

}

}上述阻塞IO代码问题:

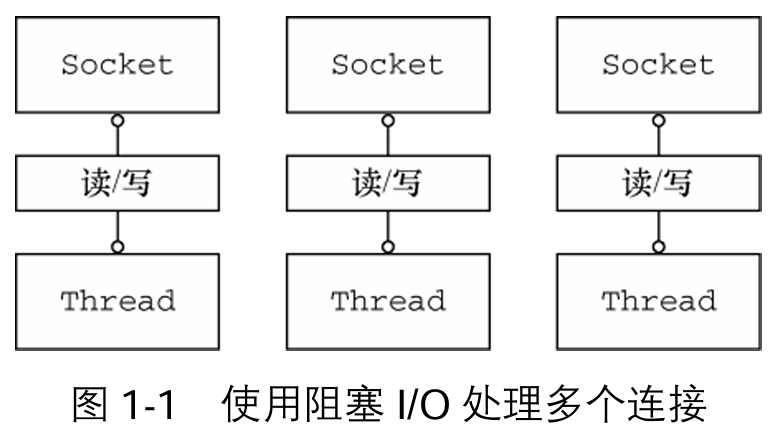

单连接瓶颈:原生阻塞式代码(如accept()+readLine())仅支持单客户端串行处理,必须引入多线程方能支持并发。

休眠等待:多数线程阻塞于I/O操作(如等待数据就绪),实际CPU利用率低。

内存开销:单个线程栈占用 64KB~1MB(万级连接消耗GB级内存)。

切换代价:线程数破千后,上下文切换开销成为主要性能瓶颈(>50% CPU时间)。

即使JVM能创建数万线程,实际有效连接上限约1万(受制于操作系统调度能力)。

①Java NIO

Java 对于非阻塞I/O的支持是在2002年引入的,位于JDK 1.4的java.nio包中。

本地非阻塞I/O的核心机制:

基础非阻塞控制:通过

setsockopt()配置套接字,使读写操作在无数据时立即返回(而非阻塞等待)。高效事件监听:利用操作系统事件通知API(如

select/poll/epoll)批量监控多个非阻塞套接字,精准感知数据就绪状态。

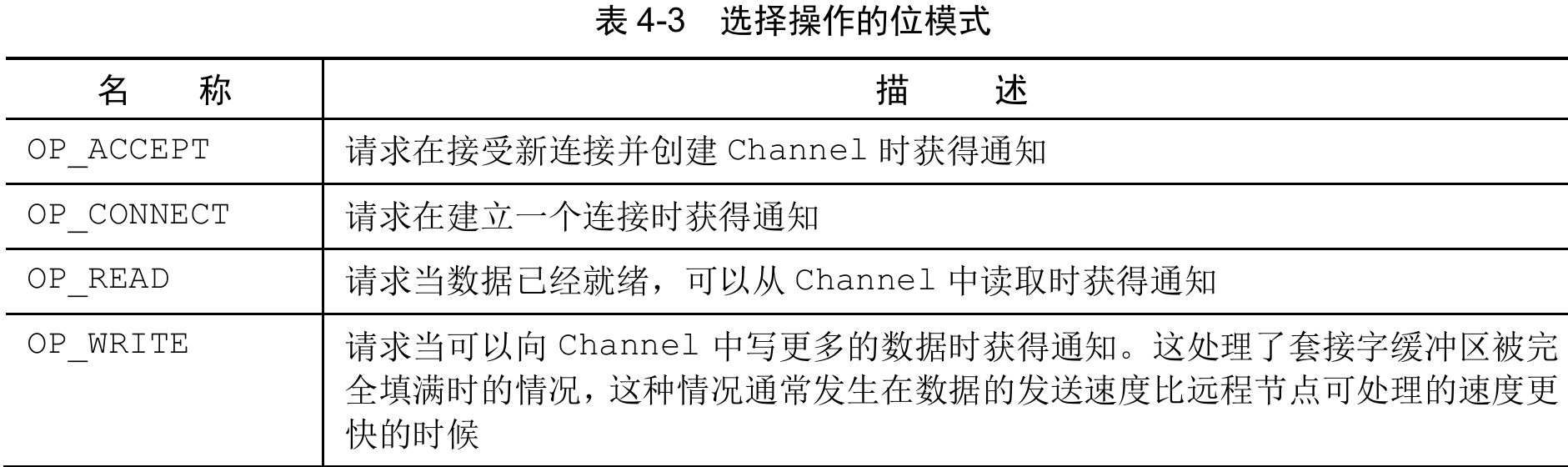

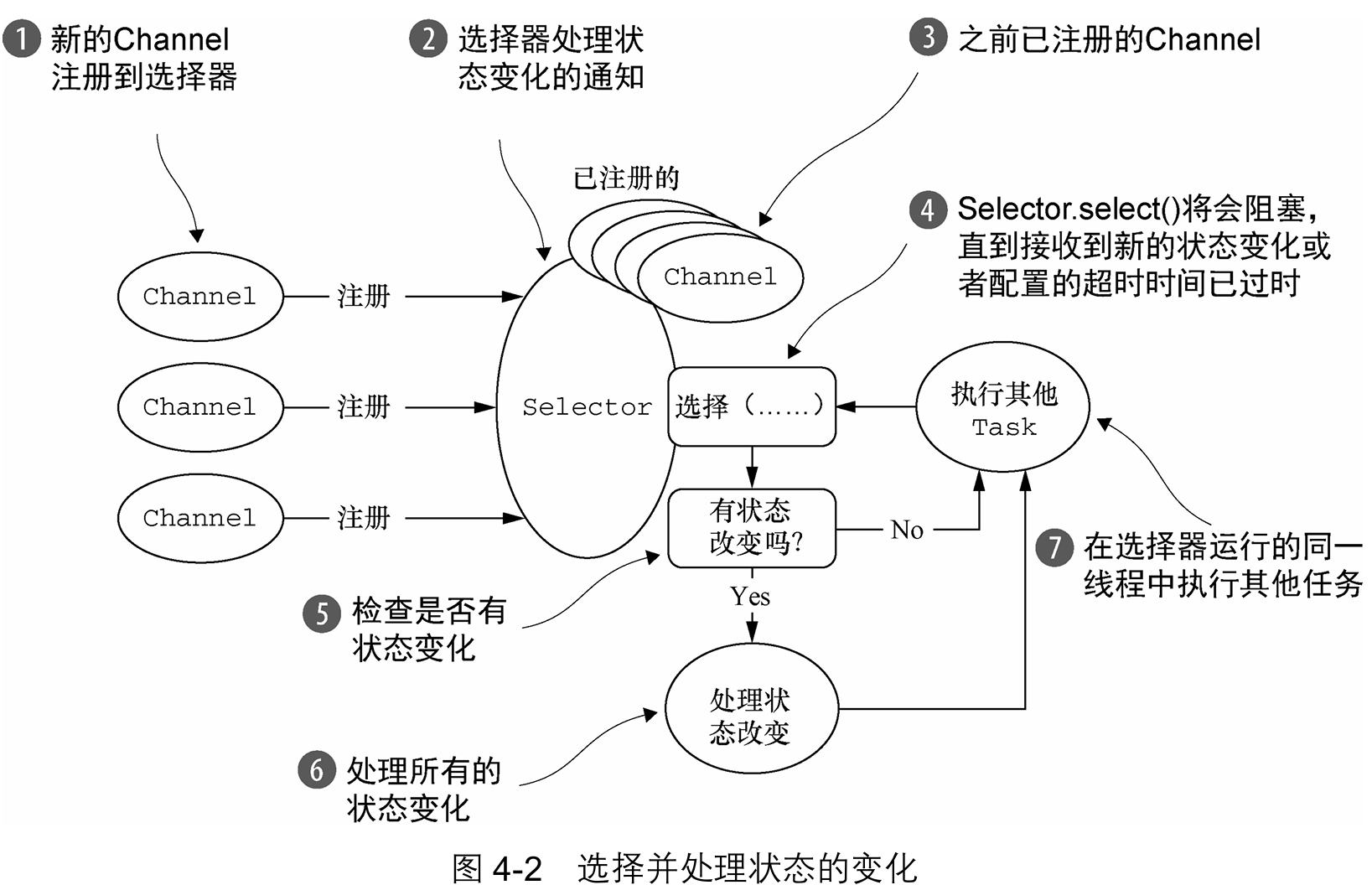

②选择器

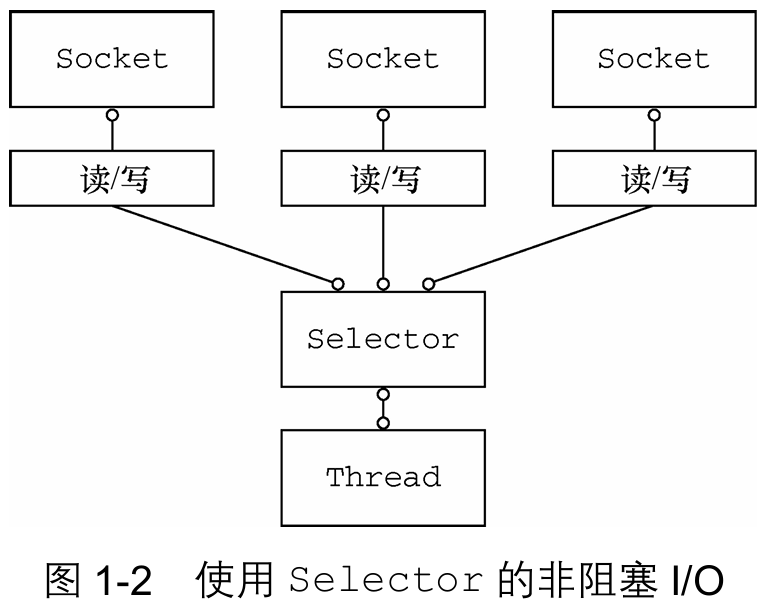

上图展示了一个非阻塞设计,消除阻塞IO中所描述的那些弊端。

class java.nio.channels.Selector是Java的非阻塞I/O实现的关键。它使用了事件通知API(如select/poll/epoll)以确定在一组非阻塞套接字中有哪些已经就绪能够进行I/O相关的操作。因为可以在任何的时间检查任意的读操作或者写操作的完成状态,所以如图1-2所示,一个单一的线程便可以处理多个并发的连接。与阻塞IO相比:使用较少的线程处理许多连接,减少了内存管理和上下文切换所带来开销;当没有I/O操作需要处理的时候,线程可以被用于其他任务。

Selector 是Java突破阻塞I/O资源限制的关键(2002年 JDK 1.4引入),但直接使用 NIO API 开发高并发服务成本高昂。Netty 作为工业级实现,解决了 NIO 的易用性与可靠性问题,成为现代分布式网络应用的基石。

2. Netty简介

技术发展永无止境——从「万级并发不可能」到「追求更高性能常态化」,核心突破在于通过抽象封装化解复杂度。Netty正是该理念的巅峰实践:它将分布式系统底层复杂性转化为简洁API,成为Java开发者应对高并发、分布式挑战的战略级武器,最终实现技术效能与业务价值的双赢。

①Netty的使用者

超大型企业:Apple(全球设备通信)、Google(云服务)、Facebook(Nifty Thrift服务)、Twitter(Finagle框架)的核心通信层均构建于Netty。

创新公司:Firebase(实时数据库长连接)、Urban Airship(亿级推送通知)依靠Netty支撑高并发场景。

分布式系统:Apache Cassandra(数据库)、Elasticsearch(搜索引擎)用Netty处理节点通信。

新兴框架:Vert.x(响应式应用)、HornetQ(消息中间件)直接集成Netty为网络引擎。

贡献闭环:Twitter/Facebook等公司因性能需求,主动贡献代码优化Netty核心。

协议扩展:通过实现FTP/SMTP/HTTP/WebSocket等协议,Netty已覆盖所有主流网络通信场景。

②异步和事件驱动

异步的生活化映射:电子邮件是最直观的异步模型:发送后未必得到回复,撰写时可能突收新消息。异步事件允许行为存在有序关系——你能在提问后执行其他任务,答案可能在任意时刻抵达。这种生活场景中的自然发生机制无需刻意设计。

计算机异步的独特挑战与价值:让程序实现同样异步行为会面临特殊问题。突破点在于构建事件驱动系统:它能以任意顺序响应任意时间点产生的事件,这种能力直接关联系统的可伸缩性。其定义为:可伸缩性 = 系统在负载增长时,通过扩展处理能力维持效能的适应力。

异步与可伸缩性的技术纽带(实现异步的核心技术包含):非阻塞网络调用:操作立刻返回,完成时通过回调通知(如收到邮件提示);选择器机制:单线程监控万千连接事件(如同邮箱管理多账户)。二者结合使异步I/O成为现实——方法瞬时响应,结果延迟传递。

3. Netty核心组件

①Channel

Channel 是 Java NIO 的核心组件,代表与实体(如硬件设备、文件、网络套接字或可执行 I/O 操作的组件)的开放连接。它支持读写等操作,是数据传输(入站/出站)的载体,可被开启/关闭或连接/断开。

②回调

回调是方法的引用机制,通过将一个方法的引用提供给另一个方法,使后者可在特定时机调用前者。回调广泛用于事件通知场景,是操作完成后的通用通知方式。Netty内部采用回调处理事件:当事件触发时,由ChannelHandler实现类处理对应逻辑。例如新连接建立时,系统将自动调用channelActive()回调方法执行预设操作(如打印提示信息)。

// 代码清单1-2 被回调触发的 ChannelHandler

public class ConnectHandler extends ChannelInboundHandlerAdapter

{

@Override

public void channelActive(ChannelHandlerContext ctx) throws Exception

{

// 当一个新的连接已经被建立时,channelActive(ChannelHandlerContext Context)将会被调用

System.out.println(

"Client " + ctx.channel().remoteAddress() + " connected");

}

}③Future

核心定义:Future 是异步操作结果的占位符,代表将在未来完成的操作。Netty 的

ChannelFuture是其异步实现,所有出站 I/O 操作均返回此对象,确保非阻塞特性。JDK 局限性对比:JDK 原生

java.util.concurrent.Future需手动检查操作状态或阻塞等待完成,存在使用效率瓶颈。Netty 解决方案:ChannelFuture 通过注册

ChannelFutureListener(一个或多个)实例实现回调机制:操作完成后自动触发监听器的operationComplete()方法,可精准判断操作成功/失败状态。若是后者,直接获取异常对象 (Throwable)彻底消除手动检查操作状态的必要性。每个Netty的出站I/O操作都将返回一个ChannelFuture;即:它们都不会阻塞。Netty完全是异步和事件驱动的,所有 I/O 操作均通过回调通知结果,线程资源零阻塞。

错误处理机制:错误应对策略完全由开发者自主决策,需结合目标场景及当前约束条件制定。例如连接失败时,可选择重连原节点或切换至其他远程节点,具体方案取决于故障类型与业务需求。

回调与Future的协同架构:

ChannelFutureListener本质是精细化回调实现:与基础回调机制互补共生,共同构成 Netty 异步通信的核心构件;回调提供事件触发入口,Future 封装异步操作状态;二者协作实现非阻塞通信范式,形成事件驱动编程的关键技术支点。

/**

* Netty 异步连接与回调操作完整示例(整合代码清单1-3 & 1-4)

* <p>

* 核心设计原理:

* 1. Channel.connect() 直接返回 ChannelFuture 而不阻塞当前线程

* 2. I/O 操作在后台异步执行,线程可同时处理其他任务提高资源利用率

* 3. 通过 ChannelFutureListener 实现回调机制,操作完成后自动触发 operationComplete()

* <p>

* 注意:若添加 ChannelFutureListener 时操作已完成,监听器会被立即通知

*/

public class AsyncConnectAndSendExample

{

public static void executeAsyncOperations(Channel channel)

{

// 异步连接到远程节点(IP:192.168.0.1, Port:25)

// connect()立即返回ChannelFuture,不会阻塞当前线程

ChannelFuture connectFuture = channel.connect(

new InetSocketAddress("192.168.0.1", 25)

);

// 添加监听器处理连接结果(回调机制核心实现)

connectFuture.addListener(new ChannelFutureListener()

{

@Override

public void operationComplete(ChannelFuture future)

{

if (future.isSuccess())

{

System.out.println("连接建立成功,开始发送数据...");

// 成功时创建数据缓冲区

ByteBuf buffer = Unpooled.copiedBuffer(

"Hello", Charset.defaultCharset());

// 将数据异步发送到远程节点

ChannelFuture writeFuture = future.channel().writeAndFlush(buffer);

// 可继续添加监听器处理发送结果(示例略)

} else

{

// 获取失败原因

Throwable cause = future.cause();

System.err.println("连接失败: " + cause.getMessage());

cause.printStackTrace();

}

}

});

// 线程可继续执行其他任务

System.out.println("异步连接请求已提交,主线程继续运行...");

/* 执行其他并行任务(例如:)

performParallelTasks(); */

}

}④事件和ChannelHandler

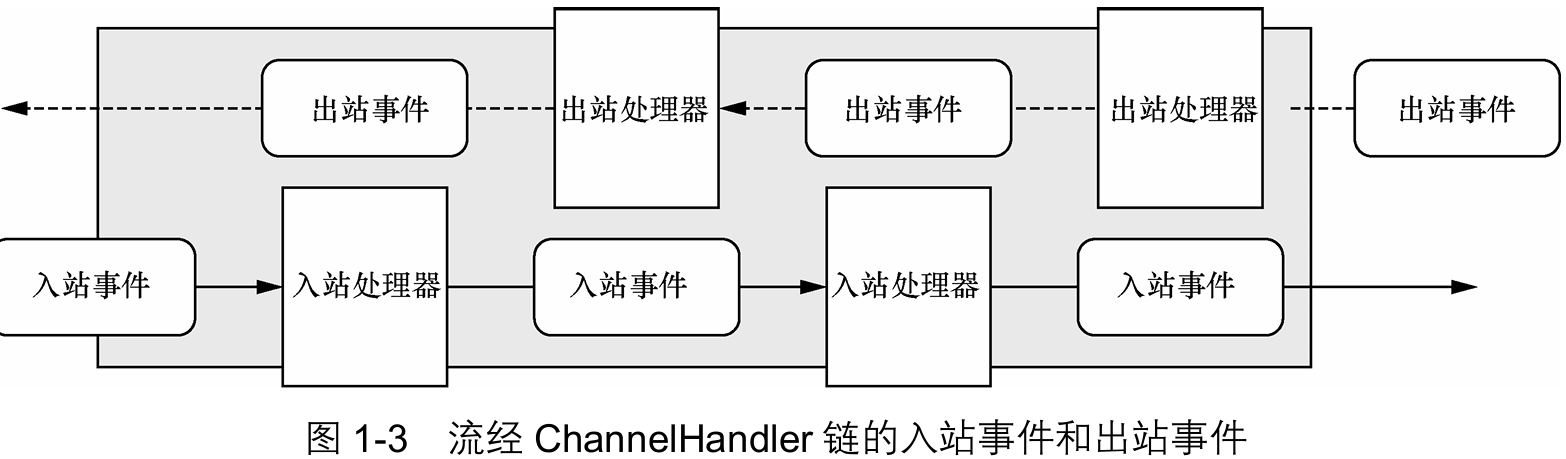

Netty 的事件模型是其架构基石:通过发布不同事件通知状态变更(如操作状态、数据流变化),开发者可基于事件类型触发相应动作,包括日志记录、数据转换、流控制及自定义应用逻辑。作为网络编程框架,事件严格按入站/出站数据流相关性分类,覆盖连接激活、连接失活等状态变更场景。

入站事件:由外部输入或状态变更驱动,典型如数据读取、用户事件、错误事件。

出站事件:代表未来将触发的动作结果,核心包括连接远程节点的开闭操作、数据写入/冲刷至套接字。

所有事件均由

ChannelHandler链式处理,事件驱动范式直接转化为应用程序构件块:每个事件被路由至用户实现的ChannelHandler方法,形成高效处理管道(见图1-3)。ChannelHandler 的关键角色:

ChannelHandler提供处理器抽象层,每个实例充当响应特定事件的回调单元。Netty 内置丰富开箱即用的实现,支持 HTTP、SSL/TLS 等协议。其设计契合异步原则:内部消费事件与Future对象,复用应用程序抽象模型,将事件响应、状态管理与业务逻辑解耦。

⑤协作

ChannelFuture 回调和ChannelHandler 回调对比:

Netty 的异步编程模型以 Future 机制 与 回调函数 为双基石:Future 承载异步操作结果状态;回调函数 实现事件驱动响应,通过 ChannelHandler 进行深层事件派发,形成逻辑处理管道。该设计使应用业务层与底层网络操作完全解耦,实现框架核心目标——业务演进独立于网络 I/O 约束。

高效数据流处理:通过回调或操作返回的 Future,无缝拦截并转换入站/出站数据流。

操作链接优化:简化的异步操作链(如:接收→解码→处理→编码→发送);消除线程阻塞点,资源利用率最大化。

复用性提升:通用处理逻辑(如心跳检测、SSL 握手)可抽象为独立 ChannelHandler;支持跨业务场景即插即用。

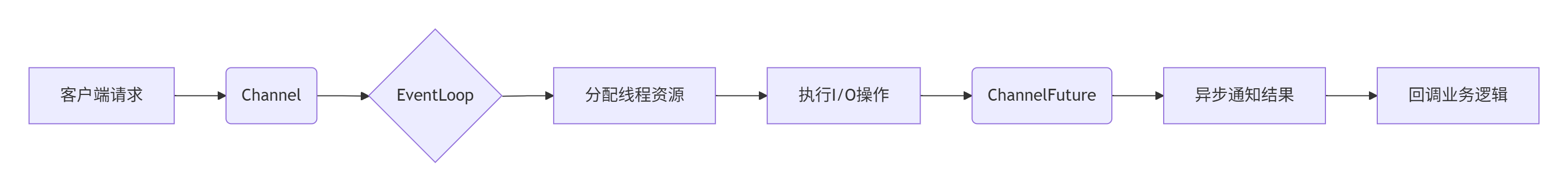

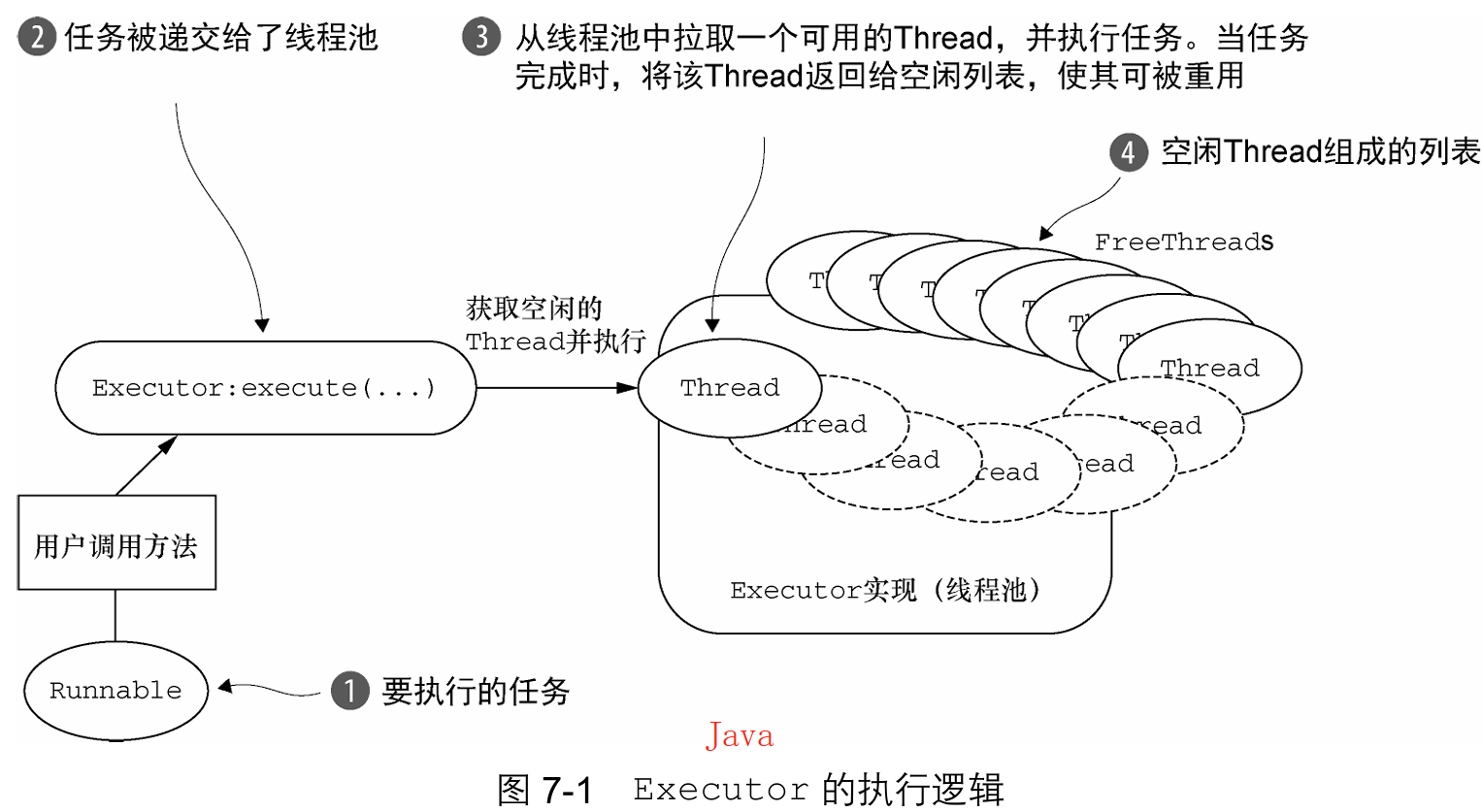

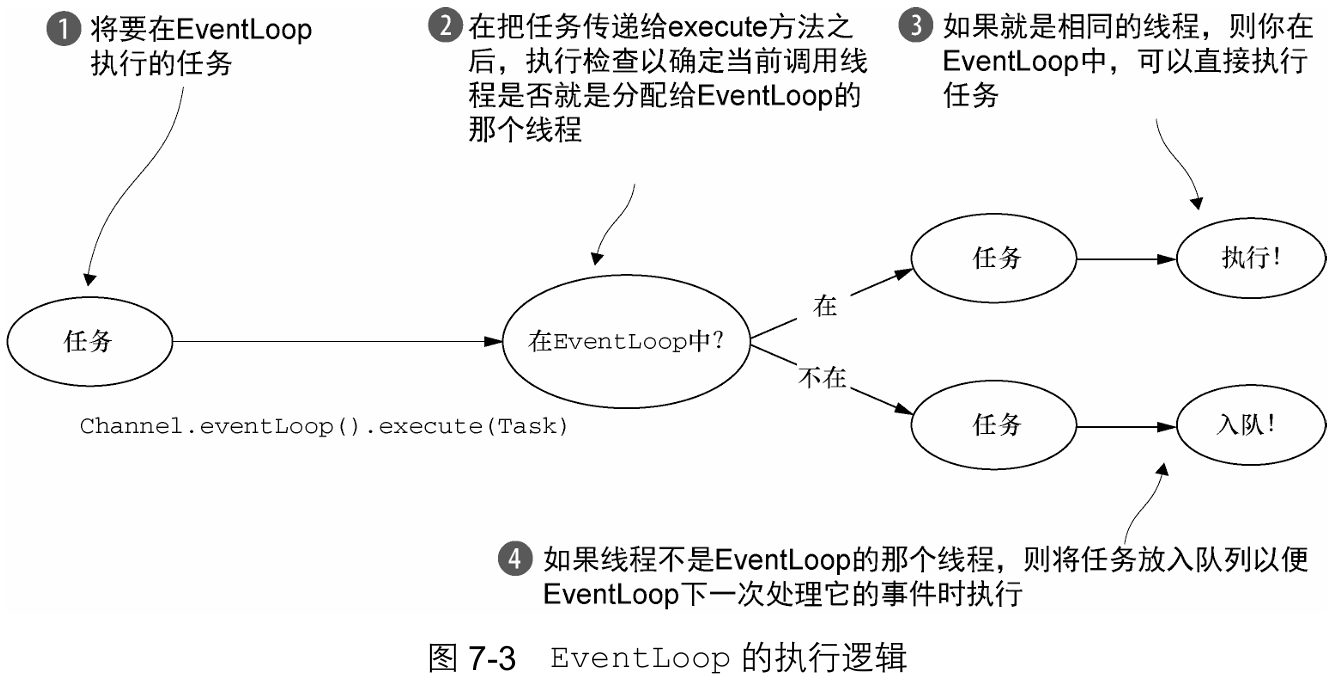

选择器、事件和EventLoop

事件抽象与线程模型:Netty 通过事件触发机制抽象底层

Selector实现,彻底消除手动派发代码。其核心设计为:每个Channel绑定专属EventLoop,全权处理事件注册、派发至ChannelHandler、后续动作调度;单线程驱动单个EventLoop,处理同一Channel整个生命周期的所有 I/O 事件。架构收益与设计优势:单

Channel事件始终由同一线程处理,天然规避多线程竞争条件,ChannelHandler实现无需额外同步;开发者专注业务逻辑(数据到达时的响应动作),事件派发、线程协调由框架自动管理;底层复杂度隐藏后,暴露接口紧凑易用。

二. Netty的组件和设计

Netty 基于 Java NIO 实现异步事件驱动架构,通过两大核心设计解决性能与工程矛盾:

技术层:异步非阻塞 I/O 模型,支撑百万级高并发场景下的负载均衡与线性扩展能力;

架构层:应用逻辑与网络层解耦,通过设计模式实现模块化、高可测性、代码复用。

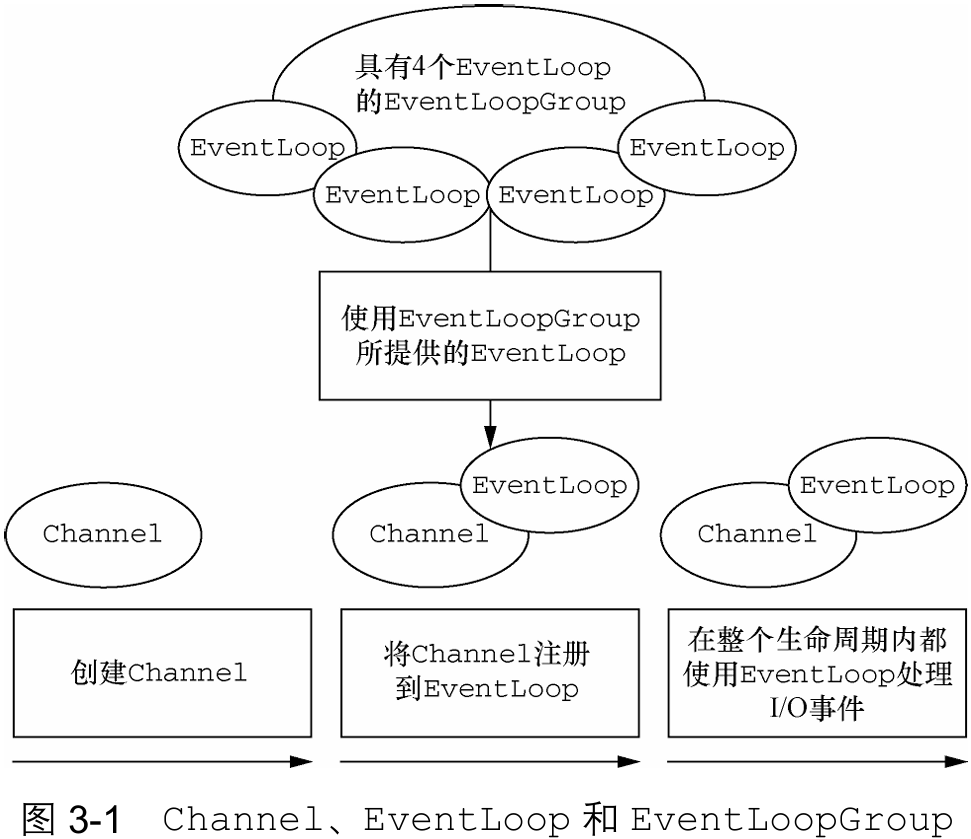

1. Channel、EventLoop 和 ChannelFuture

Netty通过三大基础组件构建了统一的网络编程抽象层:

Channel - Socket抽象层:作为NIO连接的实体载体,封装了Socket的完整生命周期操作(建立/读写/关闭),提供统一API屏蔽底层传输差异(如NIO/OIO)。

EventLoop - 控制引擎:集成多线程处理与并发控制,核心承担:事件循环调度(I/O事件监听);线程资源管理(单线程绑定单Channel);任务队列执行(异步操作派发)。

ChannelFuture - 异步通知机制:实现非阻塞操作的透明结果传递,通过监听器(

ChannelFutureListener)实现:操作完成即时回调;精准状态反馈(成功/失败);异常根源传递(Throwable获取)。

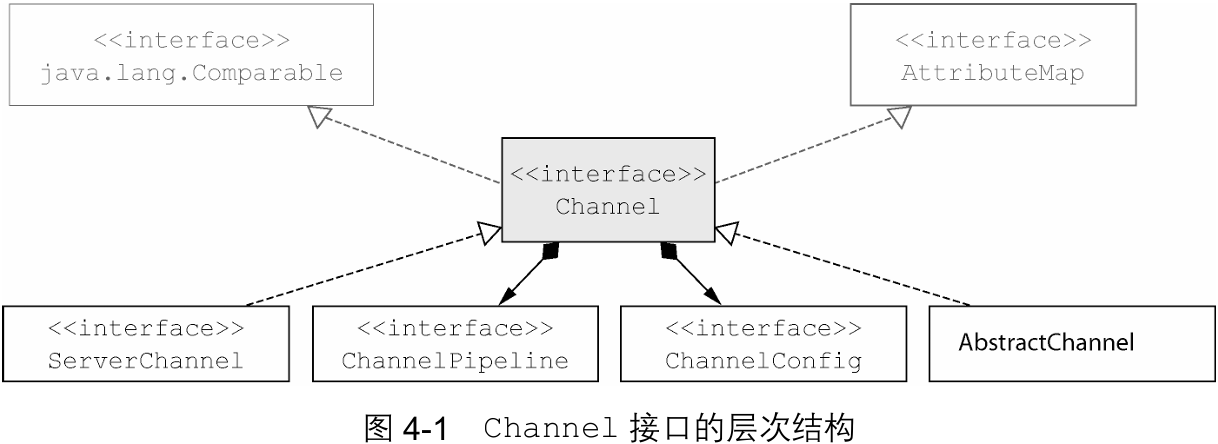

①Channel接口

Channel 是 Netty 对 Java Socket 的高阶抽象,通过统一 API 封装底层网络传输原语(bind()/connect()/read()/write()),显著降低原生 Socket 的复杂度。其设计突破传统单类限制,构建包含 预定义专业化实现 的类层次结构体系,为不同传输协议提供标准化操作接口。

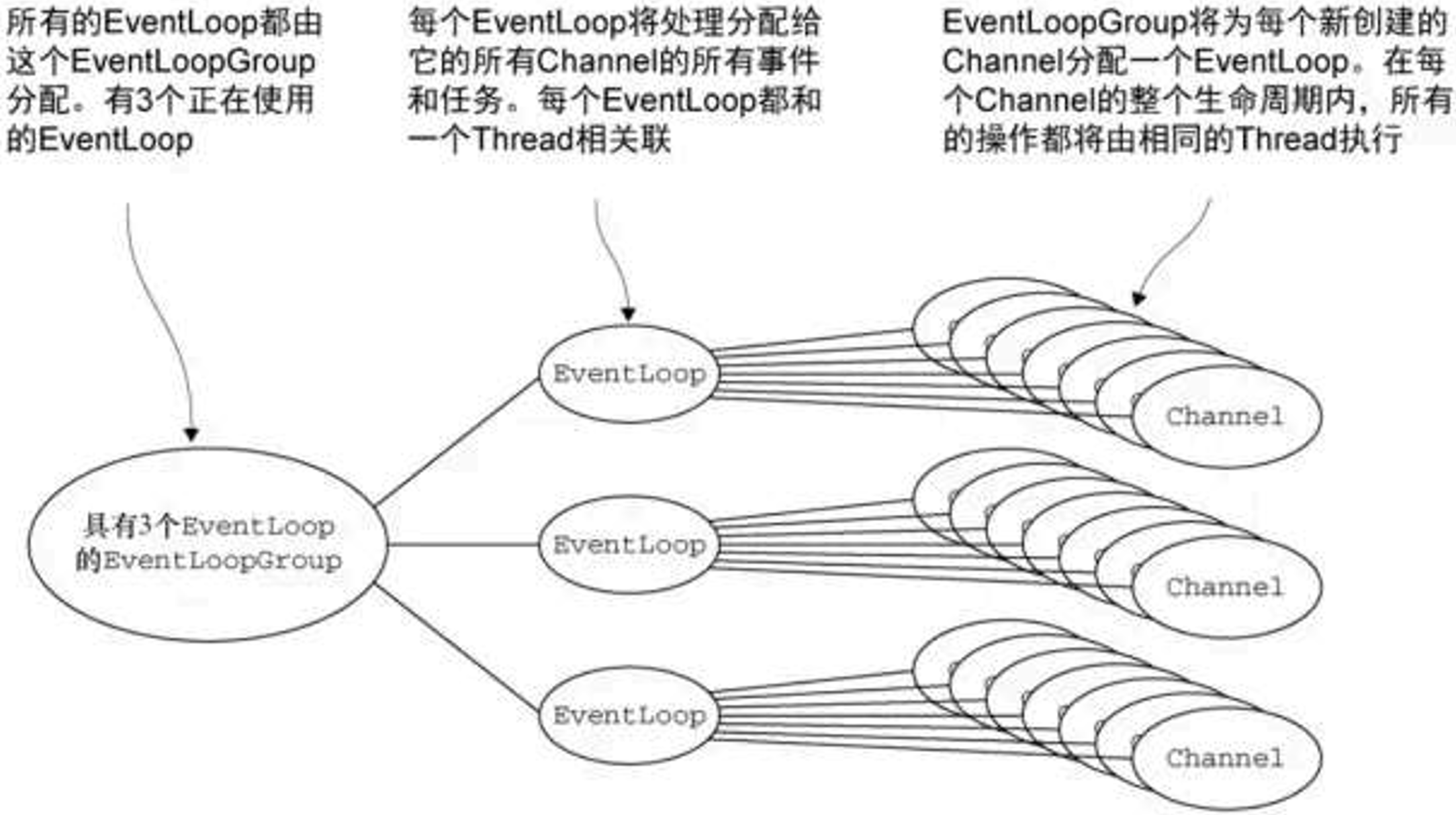

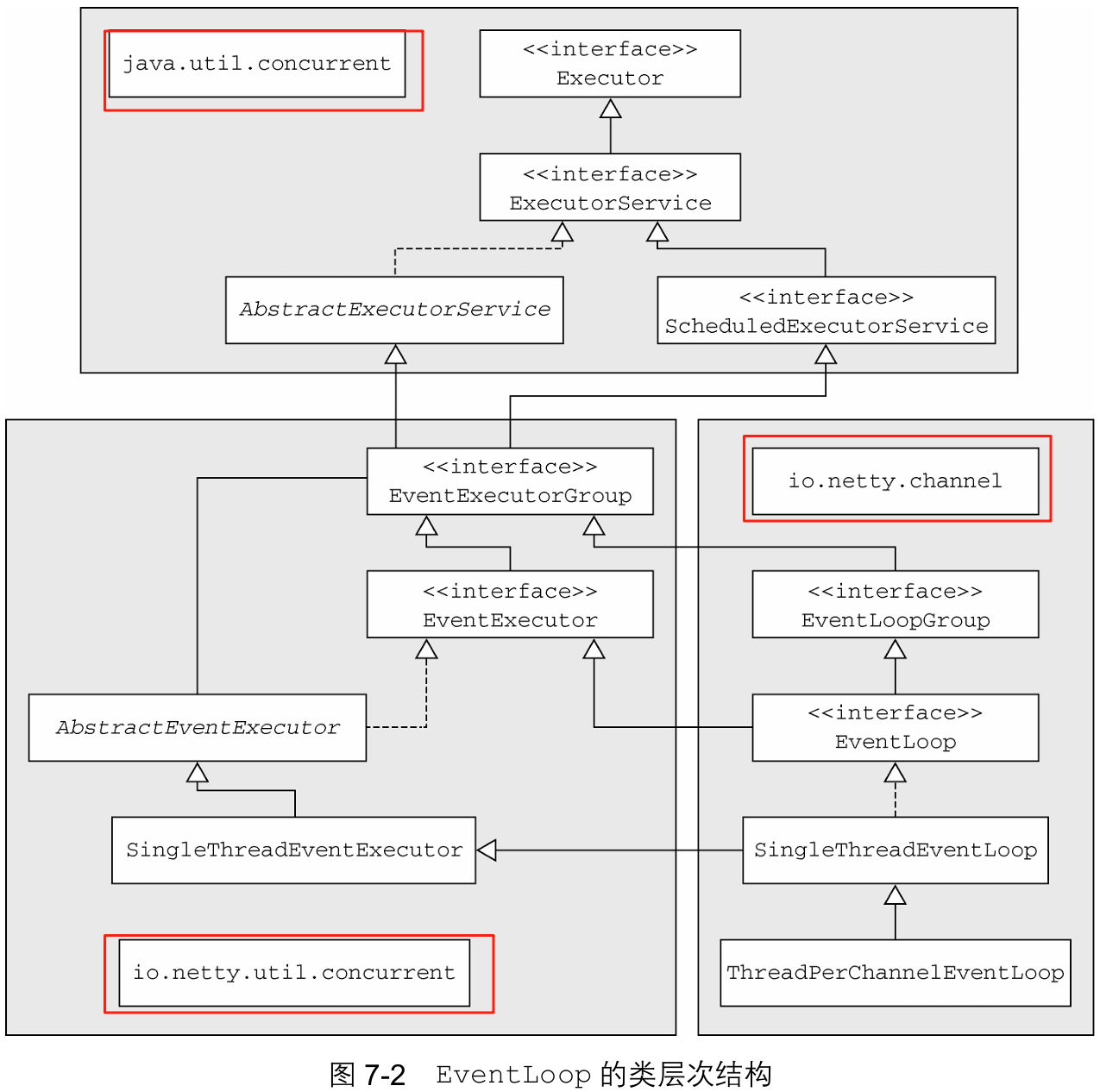

②EventLoop接口

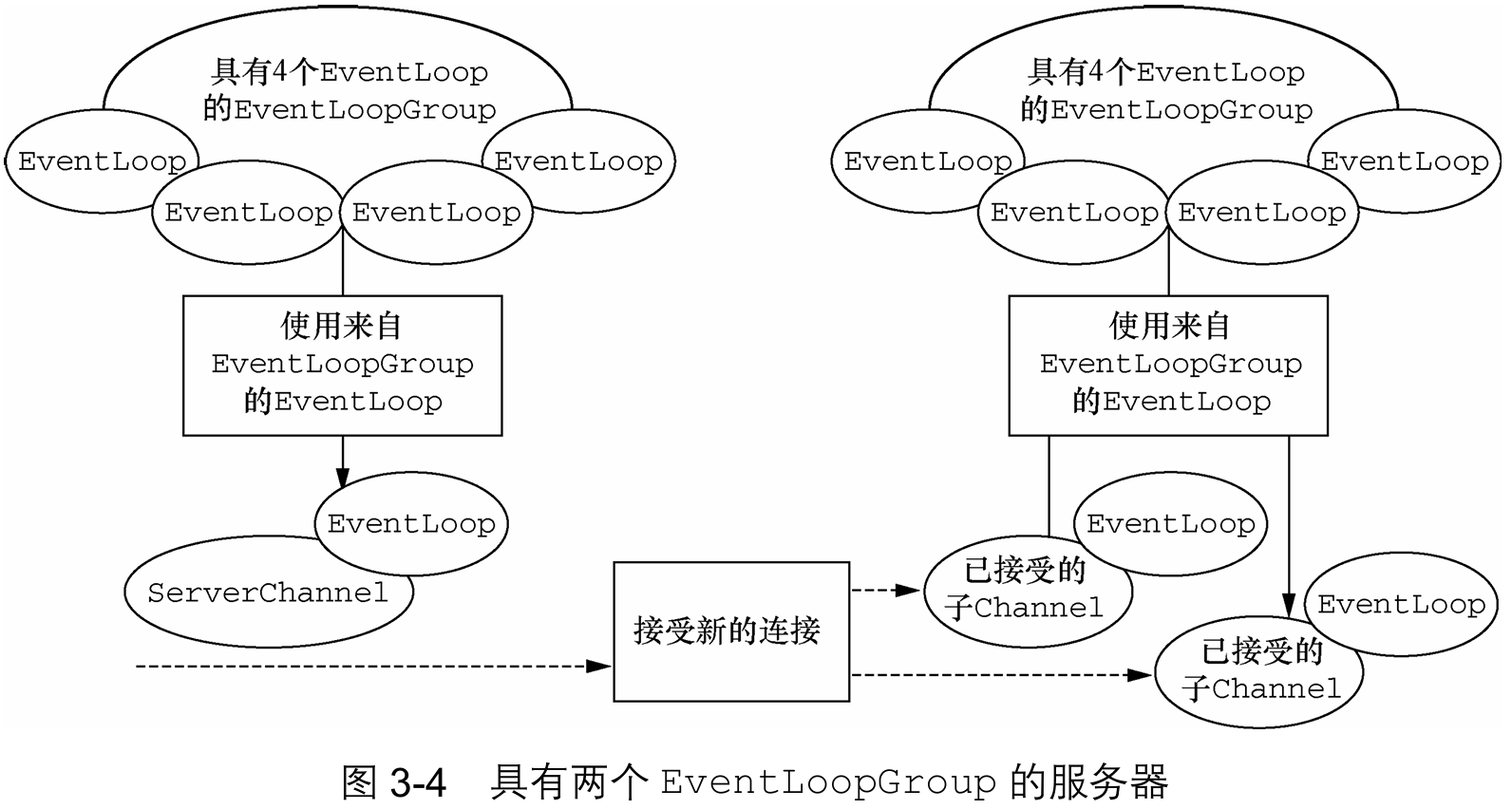

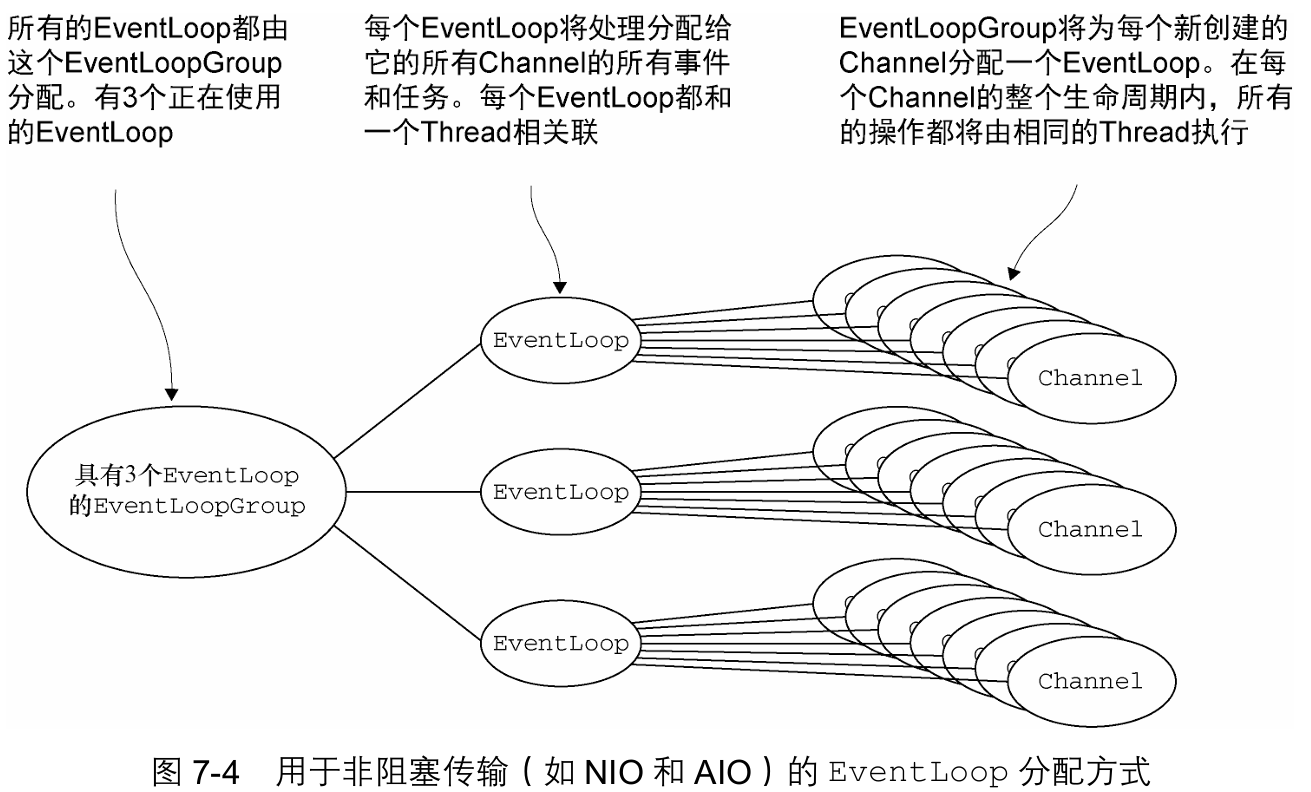

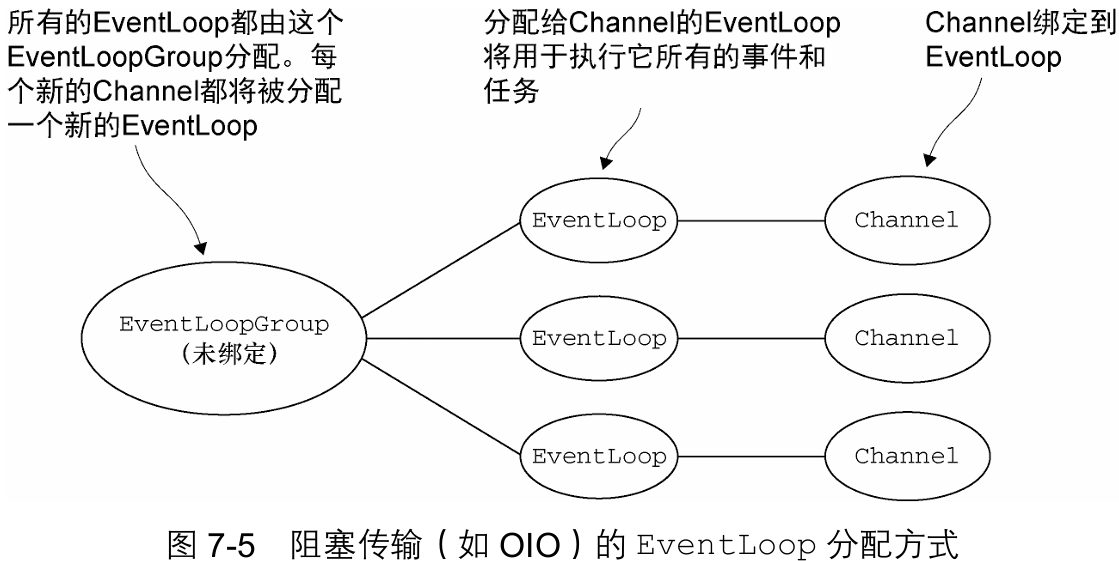

ventLoop 是 Netty 的核心事件处理抽象,负责管理连接生命周期中的所有事件(如 I/O 操作、状态变更)。它定义了事件驱动的处理范式,通过专属线程模型实现高性能异步处理。组件间的关系可抽象为:

EventLoopGroup:作为容器,管理一个或多个 EventLoop

EventLoop: 绑定单一线程,全权处理其 I/O 事件;1 EventLoop ↔ 1 Thread(生命周期绑定)

Channel: 注册到特定 EventLoop,作为事件来源;1 Channel → 仅注册到 1 EventLoop;1 EventLoop ↔ 可服务于 1→N 个 Channel。

每个 Channel 的 I/O 操作始终由同一线程执行;天然规避并发竞争条件,无需显式锁机制;事件处理顺序严格保障(先到先执行)。

③ChannelFuture接口

Netty 中所有 I/O 操作均为异步执行,不保证立即返回结果。为此提供双重机制:

ChannelFuture操作占位符:承载未来操作结果;执行时机由网络状态、线程调度等因素决定,但必然执行;同一 Channel 的操作严格遵循调用顺序(顺序性保障)。ChannelFutureListener回调枢纽:通过addListener()注册回调;操作完成(成功/失败)时自动触发通知。该模型通过 "占位符+回调" 机制实现:线程无需阻塞等待;顺序性由框架层面保障;监听器支持定制化响应逻辑。

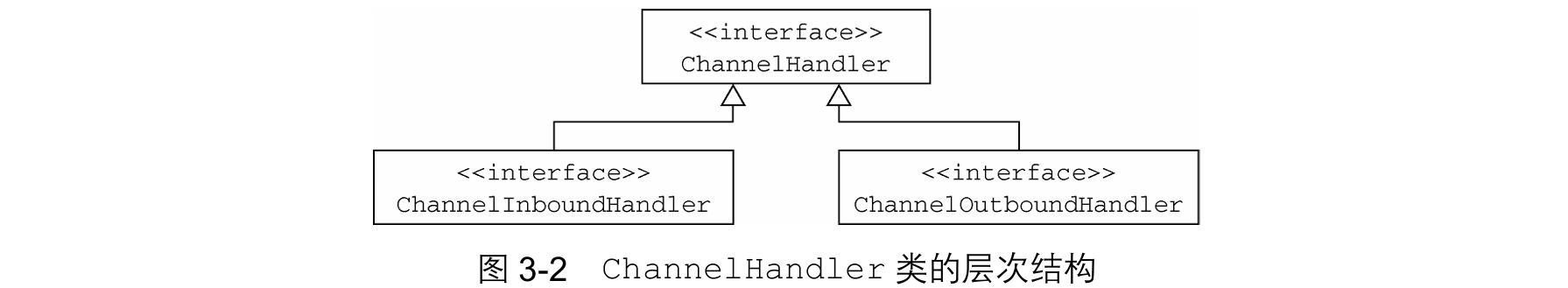

2. ChannelHandler 和 ChannelPipeline

①ChannelHandler接口

作为 Netty 应用开发的核心组件,

ChannelHandler是所有入站/出站数据处理逻辑的容器。其方法由网络事件(如连接建立、数据到达、异常发生等)触发,通过事件驱动机制实现高效响应。功能泛用性:可处理任意类型动作,包括:数据格式转换(如字节流 ↔ 对象);异常捕获与恢复处理;业务逻辑与网络协议的桥接。

业务逻辑载体:

ChannelInboundHandler是最常用的子接口,承担两大职责:入站处理:接收原始事件和数据,交由业务逻辑处理。出站响应:直接冲刷响应数据至客户端(应用程序业务逻辑通常驻留于一个或多个ChannelInboundHandler实现中)。

适配器类

Netty 提供预置适配器类(如

ChannelInboundHandlerAdapter),通过为接口方法提供完整默认实现,大幅降低自定义 Handler 开发成本。开发者只需重写目标事件方法(如channelRead()),无需实现无关接口方法。适配器类自动处理事件链传递逻辑,确保ChannelPipeline中事件自动转发至下一节点,避免因遗漏传递导致的处理链断裂。

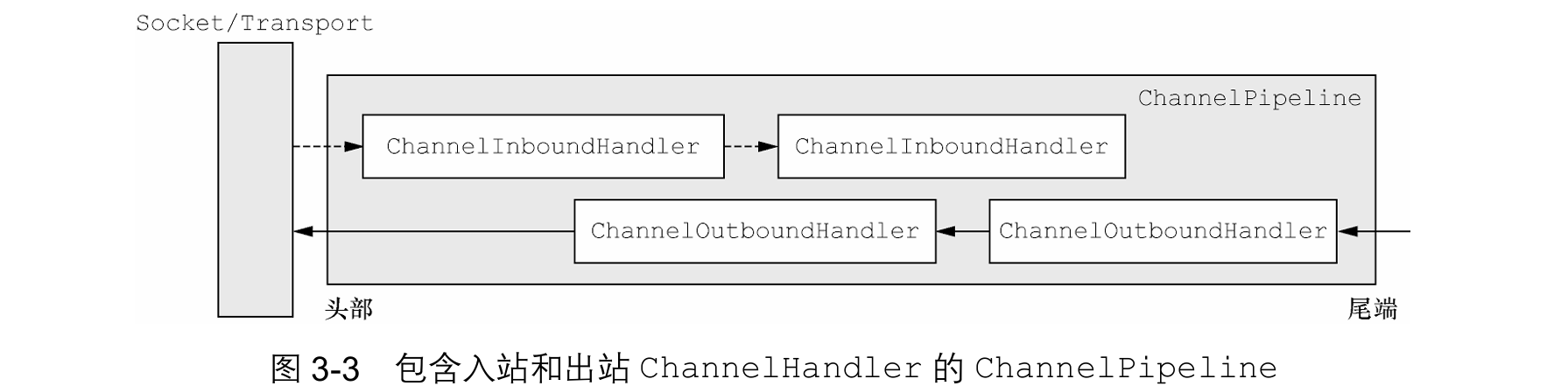

②ChannelPipeline接口

ChannelPipeline 核心机制

ChannelPipeline 是 Netty 的事件流调度中枢,每个 Channel 创建时自动绑定专属实例(专属的链)。其核心功能:

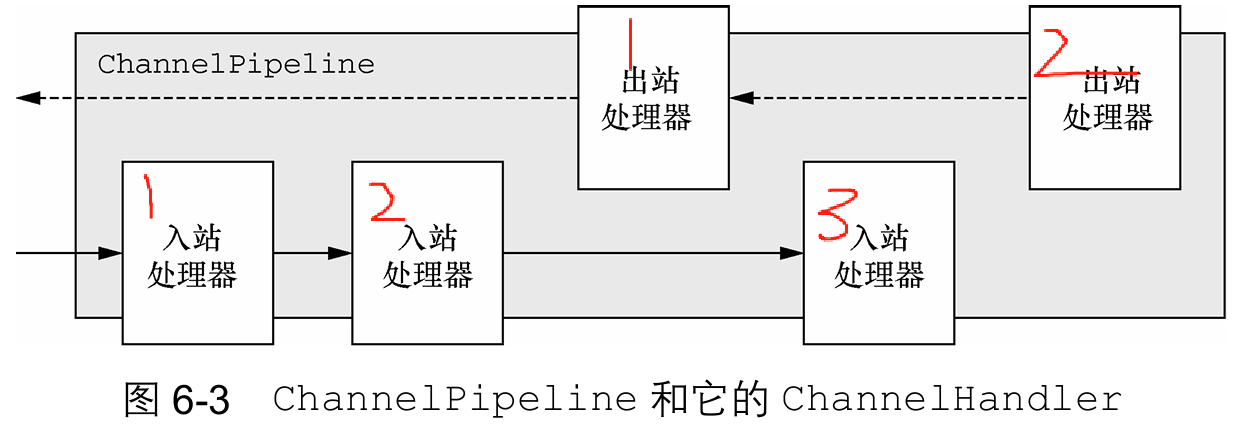

双向事件传播:定义入站(Inbound)与出站(Outbound)事件的流动规则

处理器链容器:按注册顺序组织 ChannelHandler 形成责任链

动态扩展:支持运行时增删 Handler

ChannelHandler 协作模型(ChannelHandler安装到Pipeline)

ChannelPipeline 双链机制

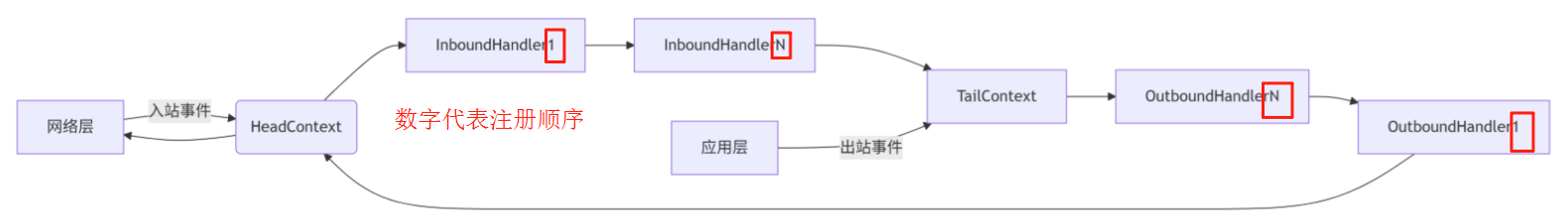

当入站(

ChannelInboundHandler)与出站(ChannelOutboundHandler)混合注册到同一ChannelPipeline时:类型隔离:Netty 通过内部定向类型标识区分二者,确保入站/出站数据仅在同类 Handler 间流:入站事件流:从 HeadContext → InboundHandler(按注册顺序) → TailContext;出站操作流:从 TailContext → OutboundHandler(按注册逆序) → HeadContext。

无干扰性:数据跨类型传递时自动跳过异类 Handler(如出站数据流不会触发入站处理器)

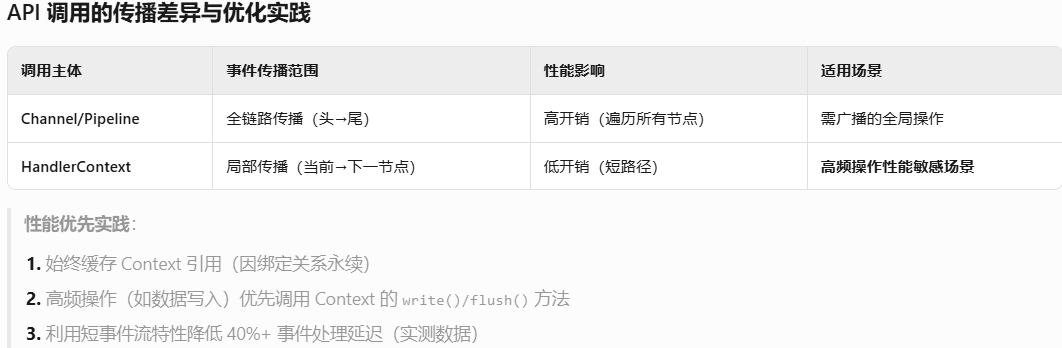

Netty两种发消息方式

当ChannelHandler被添加到ChannelPipeline时 ,它将会被分配一个

ChannelHandlerContext,其代表了ChannelHandler和ChannelPipeline之间的绑定。虽然这个对象可以被用于获取底层的Channel,但是它主要还是被用于写出站数据。直接写入Channel:使用channel.write()方法:从Pipeline 尾端启动;全链路:Tail → OutboundHandler N → ... → Head;适用需完整触发所有出站处理器。

使用ChannelHandlerContext写入:从当前Handler之后启动;截断路径:下一个 Handler → ... → Head;适用跳过前方出站处理器。

③编码器和解码器

数据转换的必要性

Netty 发送/接收消息时必然发生数据转换:

入站消息(网络 → 应用):字节流 → Java 对象(解码)

出站消息(应用 → 网络):Java 对象 → 字节流(编码)

核心原因:网络传输的本质是字节序列,需与业务层的对象格式互转。

编解码器的实现体系

Netty 提供两类抽象基类:

通用编解码器:命名模式:

ByteToMessageDecoder(字节→对象)、MessageToByteEncoder(对象→字节);适用场景:自定义协议或中间格式转换。特定协议实现:示例:

ProtobufEncoder/ProtobufDecoder(专为 Google Protocol Buffers 优化);优势:内置主流协议支持,减少重复开发。

Pipeline 中的工作逻辑

编解码器本质是特殊的

ChannelHandler:解码流程(入站):

channelRead事件触发 → 调用decode()解析字节 → 转发对象至下一 Handler。编码流程(出站):接收业务对象 → 调用

encode()转换为字节 → 转发字节至下一 Handler。

④抽象类SimpleChannelInboundHandler

当应用程序需要通过 Netty 处理网络消息时,通常会创建一个自定义的

ChannelHandler:核心作用:接收已被解码的完整业务对象(如 POJO);执行针对该数据的业务逻辑处理。

实现方式:扩展基类

SimpleChannelInboundHandler<T>(泛型T为要处理的消息类型);必须重写关键方法channelRead0(ChannelHandlerContext ctx, T msg)。(SimpleChannelInboundHandler是ChannelInboundHandlerAdapter的子类,专门用于简化入站消息处理。开发者通过重写 channelRead0 实现业务逻辑,Netty 会自动管理资源释放。)关键约束:所有方法自动获得

ChannelHandlerContext引用(作为参数传入);严禁在channelRead0中阻塞 I/O 线程(需异步处理耗时操作)。

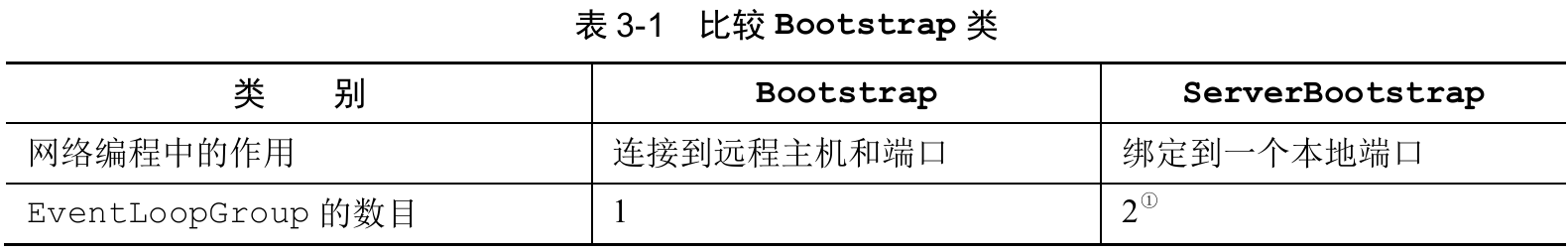

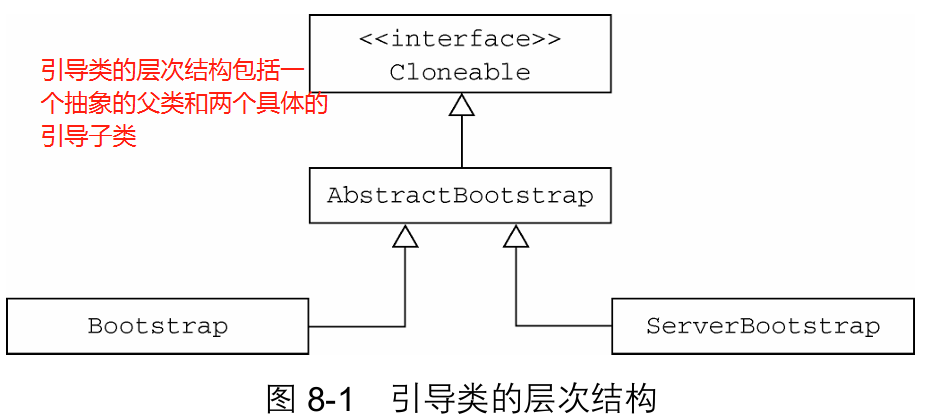

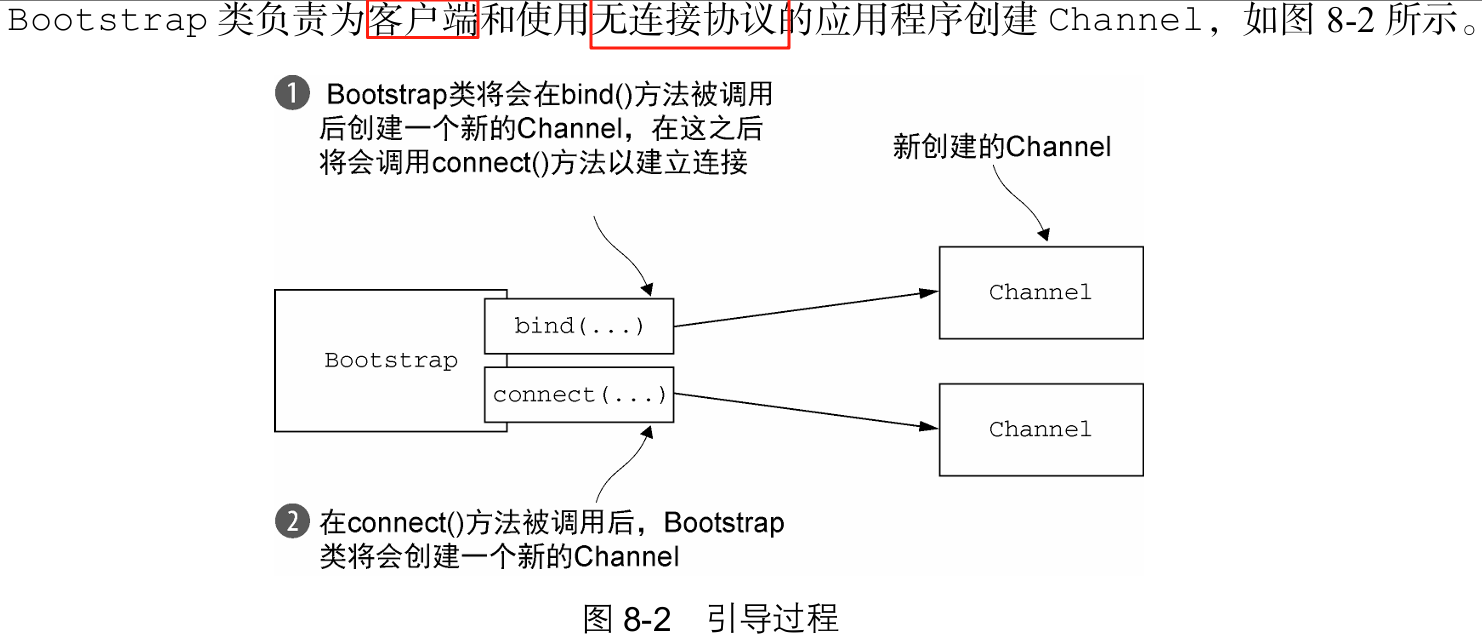

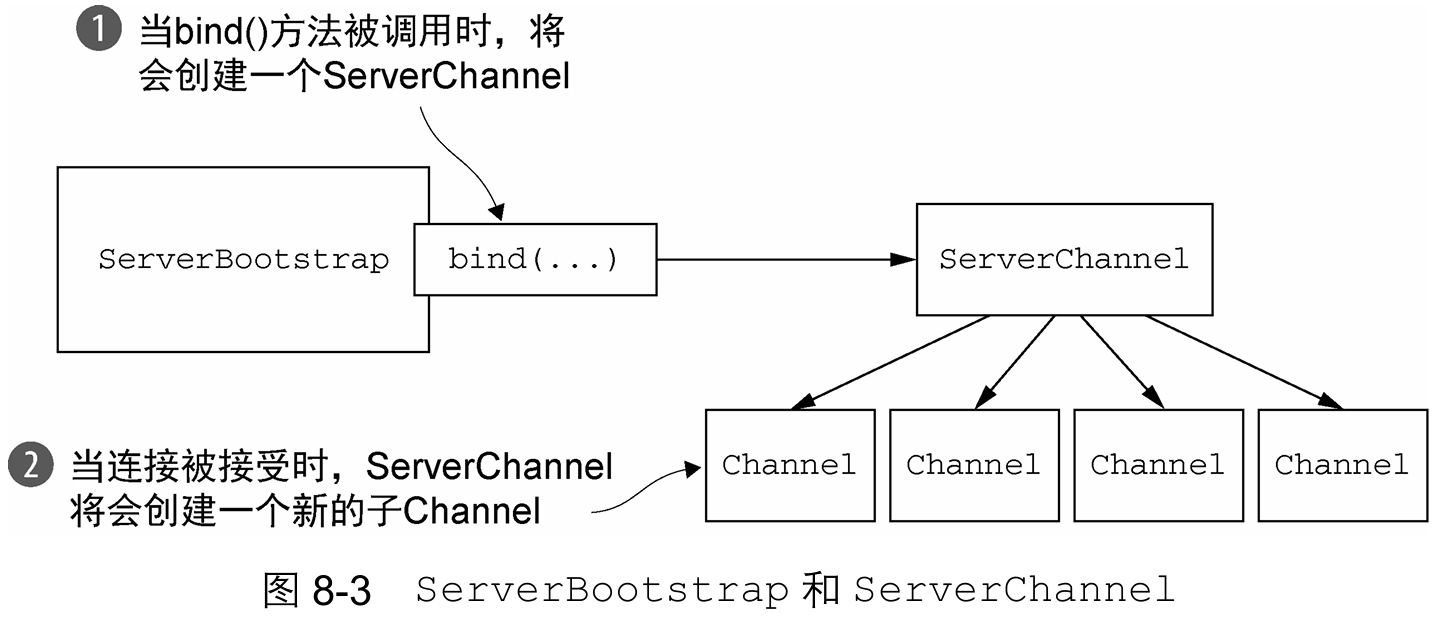

3. 引导

Netty 引导类(Bootstrap)是配置应用程序网络层的容器,主要负责两类操作(客户端使用 Bootstrap,服务端使用 ServerBootstrap,选择依据完全取决于应用角色(发起连接还是接收连接)):

服务端:将进程绑定到指定端口(监听连接)

客户端:将进程连接到目标主机的指定端口(主动建立连接)

双 Channel 组设计必要性

Netty 服务端需要两组独立的 Channel 实现高效连接管理:

监听 Channel 组(单例):唯一

ServerChannel绑定本地端口,专职监听新连接请求传输 Channel 组(动态):每个建立的客户端连接对应一个传输

Channel;负责处理已接受连接的所有数据读写。

双 EventLoopGroup 协作机制

接收连接组(Boss Group):分配

EventLoop给ServerChannel→ 专责创建新连接对应的Channel处理连接组(Worker Group):为每个新建立的传输

Channel分配独立EventLoop→ 执行具体业务读写

三. 传输

网络传输的本质:所有网络数据最终均以字节流形式传输。所谓"网络传输"实为底层数据传输机制的抽象封装,开发者只需确保字节被可靠收发,无需关注具体实现细节。

传统Java网络编程的痛点:当需要从阻塞式传输切换到非阻塞式传输时,JDK原生API存在显著问题:两种模式API差异巨大,转换成本高;需大规模重构代码,污染业务逻辑。

Netty的核心解决方案:通过统一传输层API实现三大突破:屏蔽底层实现差异(NIO/OIO等);切换传输模式仅需修改少量配置代码;业务逻辑保持纯净,避免全量重构。

1. 案例研究:传输迁移

①不通过Netty使用OIO和NIO

/**

* 代码清单 4-1 未使用 Netty 的阻塞网络编程

* <p>

* 此代码展示传统的阻塞式 Java IO 服务器实现,可以处理中等数量并发客户端。

* 但在高并发场景下伸缩性不佳,需改用异步网络编程时需完全重写应用。

*/

public class PlainOioServer

{

public void serve(int port) throws IOException

{

// 1. 创建服务器套接字并绑定到指定端口

final ServerSocket socket = new ServerSocket(port);

try

{

// 2. 循环接收客户端连接

for (; ; )

{

// 2.1 阻塞等待客户端连接

final Socket clientSocket = socket.accept();

System.out.println("Accepted connection from " + clientSocket);

// 3. 为每个连接创建新线程处理

new Thread(new Runnable()

{

@Override

public void run()

{

OutputStream out;

try

{

// 4. 获取输出流并发送响应

out = clientSocket.getOutputStream();

out.write("Hi!\r\n".getBytes(Charset.forName("UTF-8")));

// 5. 立即关闭客户端连接

clientSocket.close();

} catch (IOException e)

{

e.printStackTrace();

} finally

{

// 6. 确保连接关闭的安全处理

try

{

clientSocket.close();

} catch (IOException ex)

{

// 忽略关闭时的异常

}

}

}

}).start();

}

} catch (IOException e)

{

e.printStackTrace();

}

}

}/**

* 代码清单 4-2 未使用 Netty 的异步网络编程(NIO 实现)

* <p>

* 此代码展示纯 Java NIO 实现的非阻塞服务器,虽然功能与阻塞版本相同,但实现方式截然不同。

* 演示了传统 Java 非阻塞 I/O 编程的复杂性,重写简单应用都需要完全重构,移植复杂应用更需大量精力。

*/

public class PlainNioServer

{

public void serve(int port) throws IOException

{

// 1. 打开服务器套接字通道并将其配置为非阻塞模式

ServerSocketChannel serverChannel = ServerSocketChannel.open();

serverChannel.configureBlocking(false);

// 2. 将服务器绑定到指定的端口

ServerSocket ssocket = serverChannel.socket();

InetSocketAddress address = new InetSocketAddress(port);

ssocket.bind(address);

// 3. 创建选择器并注册服务器通道以接受连接

Selector selector = Selector.open();

serverChannel.register(selector, SelectionKey.OP_ACCEPT);

// 4. 准备待发送的消息缓冲

final ByteBuffer msg = ByteBuffer.wrap("Hi!\r\n".getBytes());

try

{

while (true)

{

try

{

// 5. 等待需要处理的新事件;阻塞将一直持续到下一个传入事件

selector.select();

} catch (IOException ex)

{

ex.printStackTrace();

break;

}

// 6. 获取所有接收事件的 SelectionKey 实例

Set<SelectionKey> readyKeys = selector.selectedKeys();

Iterator<SelectionKey> iterator = readyKeys.iterator();

// 7. 遍历所有就绪的事件

while (iterator.hasNext())

{

SelectionKey key = iterator.next();

iterator.remove(); // 从集合中移除已处理的键

try

{

// 8. 检查事件是否是一个可被接受的连接

if (key.isAcceptable())

{

ServerSocketChannel server = (ServerSocketChannel) key.channel();

// 8.1 接收客户端连接

SocketChannel client = server.accept();

client.configureBlocking(false);

// 8.2 将客户端注册到选择器,监听写和读事件

client.register(selector, SelectionKey.OP_WRITE | SelectionKey.OP_READ, msg.duplicate());

System.out.println("Accepted connection from " + client);

}

// 9. 检查事件是否可写(客户端就绪发送数据)

if (key.isWritable())

{

SocketChannel client = (SocketChannel) key.channel();

ByteBuffer buffer = (ByteBuffer) key.attachment();

// 9.1 写入数据到客户端通道

while (buffer.hasRemaining())

{

if (client.write(buffer) == 0)

{

break; // 如果无法写入更多数据则退出

}

}

// 9.2 写入完成后关闭连接

client.close();

}

} catch (IOException ex)

{

// 10. 发生I/O异常时取消键并关闭通道

key.cancel();

try

{

key.channel().close();

} catch (IOException cex)

{

// ignore on close (关闭时忽略该异常)

}

}

}

}

} finally

{

// 11. 确保最终关闭服务器通道

serverChannel.close();

}

}

}②通过Netty使用OIO和NIO

/**

* 代码清单 4-3 使用 Netty 的阻塞网络处理

* <p>

* 演示 Netty 实现阻塞式(OIO)网络服务器的完整流程

*/

public class NettyOioServer

{

public void server(int port) throws Exception

{

// 创建不可释放的ByteBuf并写入内容 "Hi!\r\n"(UTF-8编码)

final ByteBuf buf = Unpooled.unreleasableBuffer(

Unpooled.copiedBuffer("Hi!\r\n", Charset.forName("UTF-8")));

// 1. 创建OIO事件循环组(处理阻塞I/O操作)

EventLoopGroup group = new OioEventLoopGroup();

try

{

// 2. 创建服务器启动引导类

ServerBootstrap b = new ServerBootstrap();

b.group(group)

.channel(OioServerSocketChannel.class) // 指定使用OIO传输

.localAddress(new InetSocketAddress(port)) // 绑定本地端口

// 3. 设置ChannelInitializer

.childHandler(new ChannelInitializer<SocketChannel>()

{

@Override

public void initChannel(SocketChannel ch) throws Exception

{

// 4. 添加通道入站处理器适配器

ch.pipeline().addLast(new ChannelInboundHandlerAdapter()

{

@Override

public void channelActive(ChannelHandlerContext ctx)

{

// 5. 将消息写入客户端通道

ctx.writeAndFlush(buf.duplicate())

// 6. 添加写完成监听器,在消息写完时立即关闭连接

.addListener(ChannelFutureListener.CLOSE);

}

});

}

});

// 7. 绑定服务器以接受连接

ChannelFuture f = b.bind().sync();

// 8. 阻塞直到服务器通道关闭(同步等待)

f.channel().closeFuture().sync();

} finally

{

// 9. 释放所有的资源(优雅关闭事件循环组)

group.shutdownGracefully().sync();

}

}

}/**

* 代码清单 4-4 使用 Netty 的异步网络处理

* <p>

* 演示 Netty 统一传输 API 的优势:无论选择哪种传输实现,代码结构保持几乎不变。

* 传输实现仅依赖于核心接口(Channel/ChannelPipeline/ChannelHandler),业务代码无需改变。

*/

public class NettyNioServer

{

public void server(int port) throws Exception

{

// 创建待发送的消息缓冲(UTF-8编码的"Hi!\r\n")

final ByteBuf buf = Unpooled.copiedBuffer("Hi!\r\n", Charset.forName("UTF-8"));

// 1. 创建NIO事件循环组(处理I/O操作)

EventLoopGroup group = new NioEventLoopGroup();

try

{

// 2. 创建服务器启动引导类

ServerBootstrap b = new ServerBootstrap();

b.group(group)

.channel(NioServerSocketChannel.class) // 指定使用NIO传输

.localAddress(port) // 绑定本地端口

// 3. 设置ChannelInitializer

.childHandler(new ChannelInitializer<SocketChannel>()

{

@Override

protected void initChannel(SocketChannel ch) throws Exception

{

// 3.1 添加通道入站处理器适配器

ch.pipeline().addLast(new ChannelInboundHandlerAdapter()

{

@Override

public void channelActive(ChannelHandlerContext ctx)

{

// 4.1 将消息写入客户端通道

ctx.writeAndFlush(buf.duplicate())

// 4.2 添加写完成监听器:立即关闭连接

.addListener(ChannelFutureListener.CLOSE);

}

});

}

});

// 5. 异步绑定服务器端口

ChannelFuture f = b.bind().sync();

// 6. 阻塞直到服务器通道关闭(同步等待)

f.channel().closeFuture().sync();

} finally

{

// 7. 优雅关闭事件循环组,释放所有资源

group.shutdownGracefully().sync();

}

}

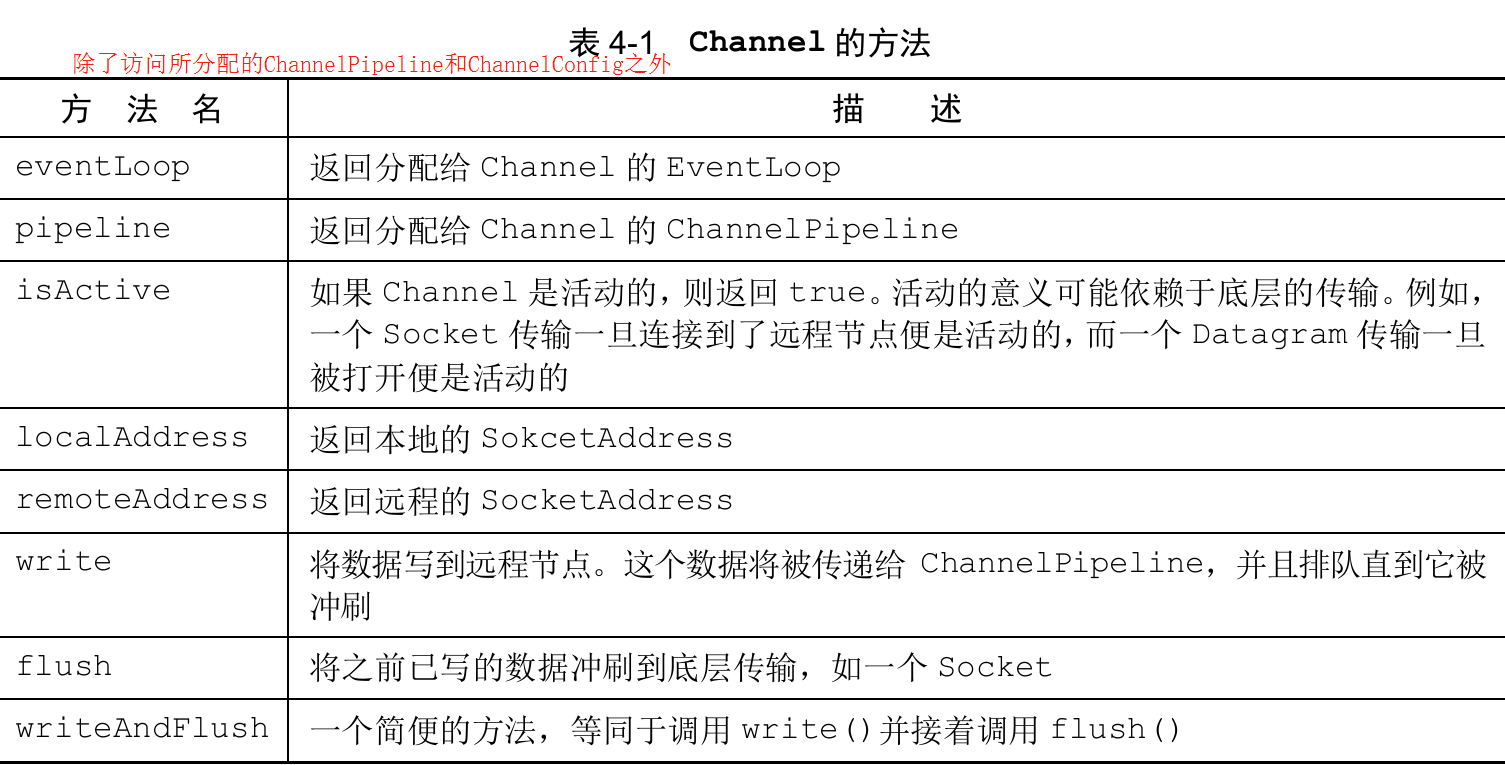

}2. 传输API

Channel 的核心地位与核心组件

Netty 传输 API 的核心是

Channel接口(所有 I/O 操作的统一抽象),其设计包含三个关键组件:通道配置:

ChannelConfig集中管理所有配置设置,支持运行时热更新,不同传输协议可扩展专属配置。通道管道:

ChannelPipeline采用拦截过滤器模式(类比 UNIX 管道):持有处理入站/出站数据的ChannelHandler链;支持动态增删处理器(如按需添加SslHandler支持 STARTTLS 协议)。唯一性保障:每个

Channel实例具有全局唯一标识,实现Comparable接口确保严格顺序,哈希冲突会触发错误。

灵活架构的价值实现

ChannelHandler作为业务逻辑载体,通过标准化接口实现四大能力:数据转换(如协议编解码)、状态通知(连接活跃/注册事件/自定义事件)、异常传播、流程拦截。

关键优势:Netty 基于 少量核心接口(Channel/Pipeline/Handler)实现功能扩展:应用程序逻辑可重大修改而无需重构;传输协议切换不影响业务代码;复杂功能(如加密)通过动态加载处理器实现。

/**

* 代码清单 4-5 写出到 Channel

* <p>

* 演示使用 Channel.writeAndFlush() 将数据写入并冲刷到远程节点的常规任务操作

*/

public class ChannelWriteExample

{

public void writeData()

{

// 1. 获取要写入数据的通道对象

Channel channel = ...; // 实际应用中需初始化的 Channel 实例

// 2. 创建持有待写入数据的 ByteBuf 对象(包含 UTF-8 编码的"your data")

ByteBuf buf = Unpooled.copiedBuffer("your data", CharsetUtil.UTF_8);

// 3. 将数据写入通道并立即冲刷

// 返回 ChannelFuture 用于监控写入操作状态

ChannelFuture cf = channel.writeAndFlush(buf);

// 4. 添加 ChannelFutureListener 监听器

// 在写操作完成后接收通知

cf.addListener(new ChannelFutureListener()

{

@Override

public void operationComplete(ChannelFuture future)

{

// 5. 检查写操作执行结果状态

if (future.isSuccess())

{

// 5.1 当写操作成功完成且无错误时

System.out.println("Write successful");

} else

{

// 5.2 当写操作失败时的错误处理逻辑

// 记录错误信息到标准错误流

System.err.println("Write error");

// 打印异常堆栈跟踪(诊断错误原因)

future.cause().printStackTrace();

}

}

});

}

}/**

* 代码清单 4-6 从多个线程使用同一个 Channel

* <p>

* Netty 的 Channel 实现是线程安全的,可以存储 Channel 引用并在多线程环境下安全使用。

* 即使多个线程同时写入,消息也能保证按顺序发送。

*/

public class MultiThreadChannelWriteExample

{

public static void main(String[] args)

{

// 创建 Channel 引用(实际应用中需初始化)

final Channel channel = ...; // 此处应替换为实际的 Channel 实例

// 1. 创建持有要写数据的 ByteBuf("your data"使用UTF-8编码)

// 使用 retain() 增加引用计数(多线程共享时避免过早释放)

final ByteBuf buf = Unpooled.copiedBuffer("your data", CharsetUtil.UTF_8).retain();

// 2. 创建将数据写到 Channel 的 Runnable

Runnable writer = new Runnable()

{

@Override

public void run()

{

// 使用 duplicate() 创建共享缓冲区的独立视图(避免竞争)

channel.writeAndFlush(buf.duplicate());

}

};

// 3. 获取到线程池 Executor 的引用

Executor executor = Executors.newCachedThreadPool();

// 4. 递交写任务给线程池,在第一个线程中执行

executor.execute(writer);

// 5. 递交另一个写任务,在第二个线程中执行

executor.execute(writer);

}

}3. 内置的传输

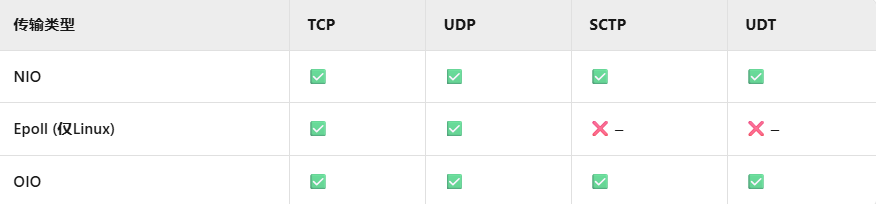

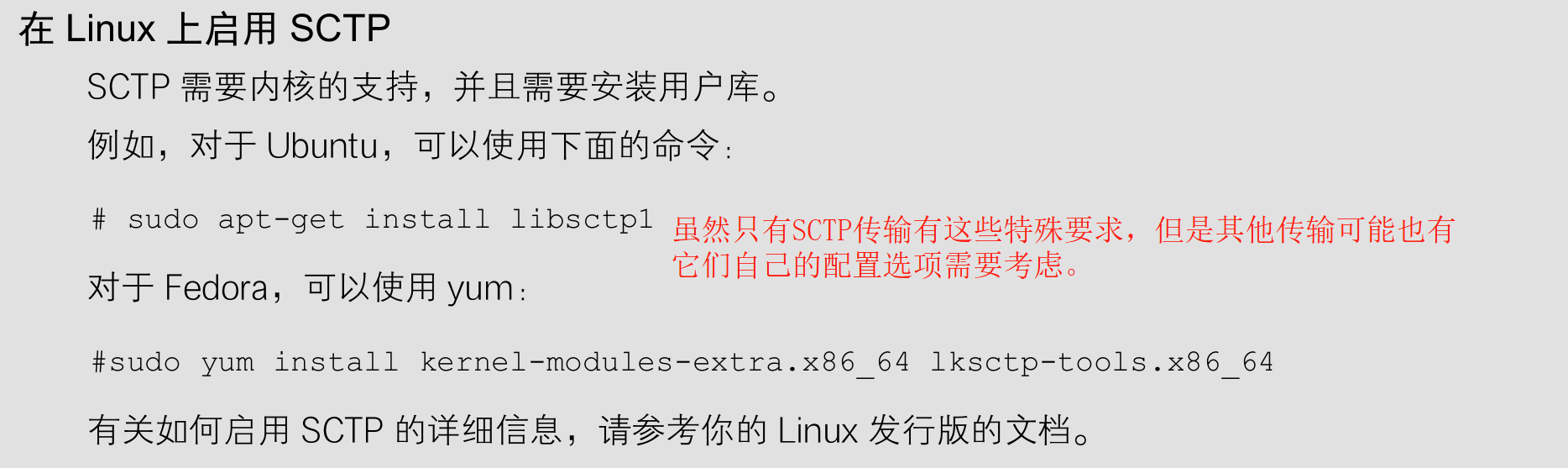

Netty 内置开箱即用的传输实现,由于不同传输对协议的支持范围存在差异(并非所有传输支持每种协议),开发者必须根据应用程序使用的具体协议选择兼容的传输方案。

①NIO——非阻塞I/O

Java NIO 的核心机制

NIO 通过选择器(Selector) 实现全异步 I/O 操作:

状态监听注册:选择器作为通道状态变更的注册中心,监听四类核心事件:新通道接受就绪、连接完成、数据可读、通道可写。

事件驱动循环:专用线程持续轮询选择器→响应状态变更→重置选择器→开启下一轮检测。

位模式控制:通过组合

SelectionKey位模式常量,精确定义需监听的状态变更集合。

Netty 的抽象价值

针对 NIO 的复杂实现细节:统一传输接口 屏蔽底层差异;用户级 API 完全封装选择器、通道注册、位模式等 NIO 内部机制;开发者聚焦业务逻辑,无需关注异步 I/O 的底层实现。

核心突破:Netty 在 NIO 的异步架构之上建立更高层抽象,使网络编程从技术复杂性转向业务表达。

零拷贝

零拷贝(zero-copy)是 NIO/Epoll 传输专属的特性,通过跳过内核空间→用户空间的冗余复制,实现文件数据直达网络接口的高效传输,显著提升 FTP/HTTP 等协议性能;但其受限于操作系统兼容性(非全平台支持),且不适用于加密/压缩的文件系统(仅能传输原始内容),而传输已加密文件则不受此限制。

②Epoll—用于Linux的本地非阻塞传输

Netty 的 NIO 传输机制基于 Java 的异步非阻塞网络抽象,虽具备跨平台兼容性,但因 JDK 需适配多系统而在性能上存在妥协。针对 Linux 在高性能网络领域的核心地位,Netty 提供专有的 epoll 传输实现(自内核 2.5.44 支持):该方案以更符合 Netty 架构的轻量化中断机制(JDK的实现是水平触发,而Netty的(默认的)是边沿触发)深度整合 Linux epoll 系统调用,取代了传统的 POSIX select/poll,在高并发负载下性能显著优于 JDK 原生 NIO(即使NIO也使用epoll)。

迁移至 epoll 传输无需修改业务逻辑,仅需替换两个关键组件:

NioEventLoopGroup→EpollEventLoopGroup;NioServerSocketChannel.class→EpollServerSocketChannel.class。Epoll的传输语义同NIO里的图4-2(三3①)。

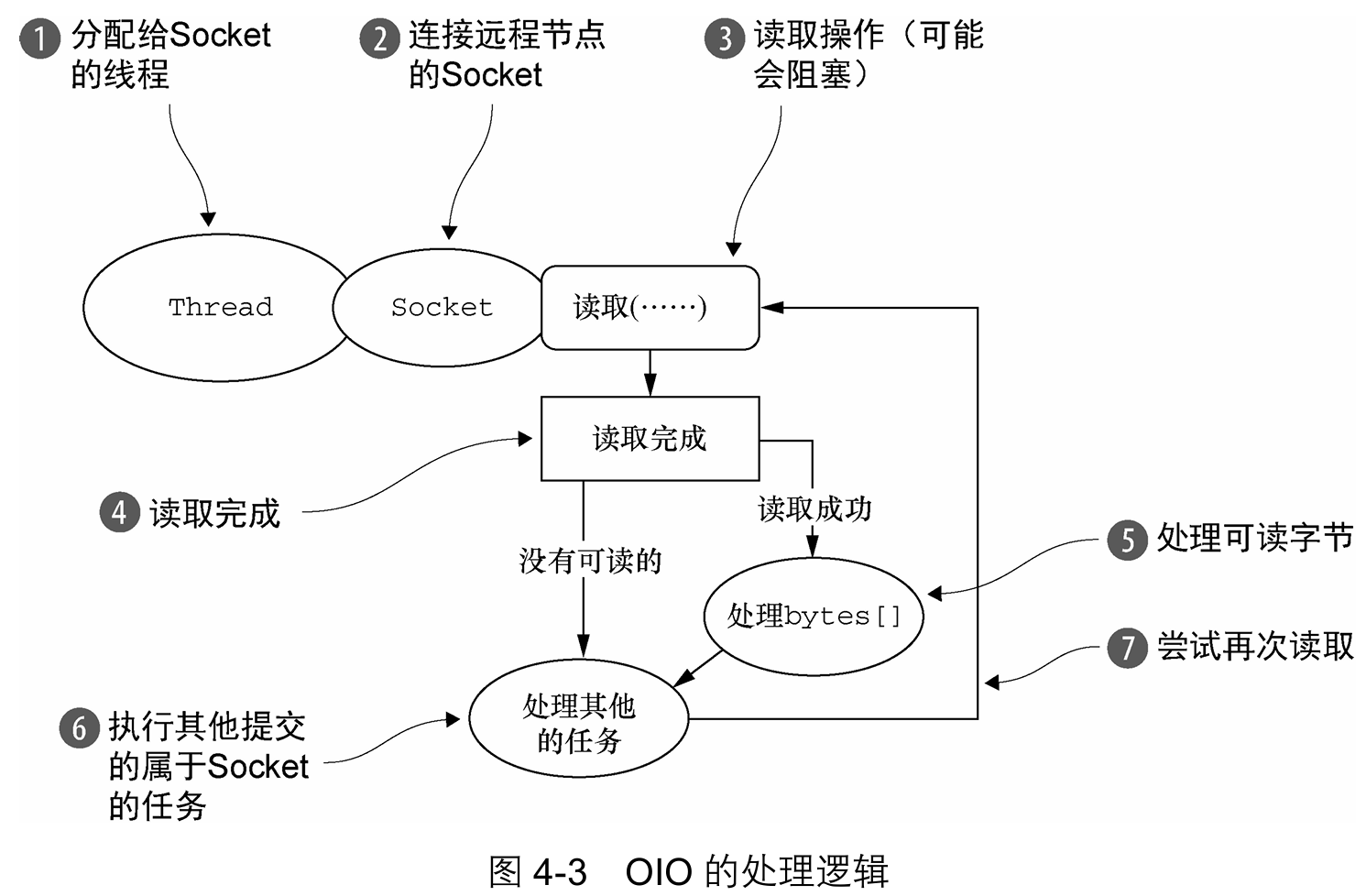

③OIO—旧的阻塞I/O

定位与价值

Netty 的 OIO 传输是阻塞 I/O 的实用化封装,虽底层基于

java.net同步阻塞 API,但实现了与统一传输接口的兼容。其核心价值在于:解决遗留系统迁移痛点:适配依赖阻塞调用的库(如 JDBC),为迁移至异步架构提供缓冲过渡期。

无侵入式整合:业务逻辑无需改写,仅通过配置切换传输实现。

实现机制与限制

通过

SO_TIMEOUT标志(它指定了等待一个I/O操作完成的最大毫秒数,超时则抛出异常)破解阻塞模型:超时中断控制:设置 I/O 操作最大等待阈值,超时抛出

SocketTimeoutException事件循环重试:Netty 捕获异常后释放线程,由

EventLoop在下一轮调度中自动重试操作资源代价:仍依赖"每连接一线程"模型 → 高并发下线程开销显著

本质矛盾:OIO 的阻塞特性与异步框架存在根本冲突,超时中断是唯一可行的折中方案。

④用于JVM内部通信的Local传输

核心定位与功能

Netty 的 Local 传输提供 JVM 内部进程间异步通信能力,其实现完整支持 Netty 统一传输 API,具备三大特性:

通信隔离性:不绑定物理网络地址,而是通过内部注册表管理

SocketAddress(运行时注册,通道关闭时注销)空间封闭性:仅限同一 JVM 内的客户端与服务端通信,完全不接收真实网络流量

无外部互操作性:无法与其他传输实现互通(如 NIO/OIO),强制同 JVM 内通信双方必须均采用 Local 传输

技术价值与使用一致性

在业务开发中:

与常规传输无差别:除通信范围限制外,编程接口、线程模型、资源管理与标准传输实现完全一致

特殊场景价值:为单元测试、模块解耦、内存计算等避免网络开销的进程间通信场景提供轻量化解决方案

⑤Embedded 传输

功能定位

Embedded 传输提供独特的 Handler 嵌入机制,允许将一组

ChannelHandler作为可插拔模块嵌入到现有 Handler 内部。通过封装扩展逻辑避免修改被嵌入对象,实现 "零侵入"的功能增强,尤其适用于协议扩展、功能组合等场景。

核心实现与价值

核心组件

EmbeddedChannel是特殊的Channel实现:轻量隔离:在虚拟环境中运行 Handler 链,完全脱离真实网络栈

测试革命:作为单元测试工具链关键组件,支持验证包括入站/出站数据流、事件传播、异常捕获等完整处理逻辑,显著提升 Handler 开发与验证效率。

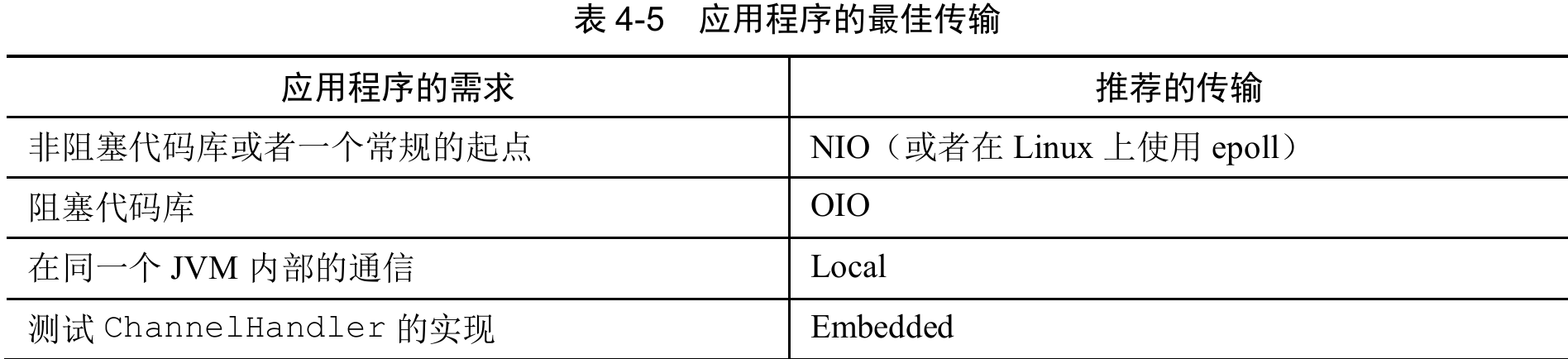

4. 传输用例

Netty 各传输实现对核心协议的支持范围存在差异(见表4-4),这将直接影响开发者在特定业务场景中的选型决策。协议兼容性作为传输选型的关键约束条件,必须在架构设计阶段优先验证,而参考表格完整列举了出版时各传输方案的协议支持矩阵以辅助评估。

非阻塞代码库:推荐优先使用 Linux 上的 NIO/epoll 传输,该方案高效处理从少量到海量并发连接,得益于其线程共享机制。避免不必要的阻塞调用或限制其范围以最大化性能。

阻塞代码库:若系统严重依赖阻塞 I/O(如传统 JDBC 调用),不宜直接强制迁移至 NIO。应采用 分阶段策略:先用 OIO 传输实现初步兼容;代码重构后过渡到 NIO 或 epoll(Linux 专用)。

JVM 内部通信:使用 Local 传输消除网络开销,简化部署。需要后续网络暴露时,无缝切换至 NIO/OIO。

ChannelHandler 测试:选用 Embedded 传输作为单元测试工具,无需模拟对象即可验证业务逻辑,确保其在真实网络环境中的可靠性。

四. ByteBuf

原生 JDK 容器的局限

Java NIO 提供的

ByteBuffer作为字节容器存在显著缺陷:操作繁琐:API 设计复杂冗余(如需手动

flip()切换读写模式),增加开发心智负担功能薄弱:缺失高级特性(如动态扩展、复合缓冲区),难以满足高效网络编程需求

Netty 的革新方案

ByteBuf是针对ByteBuffer的全面进化:架构优势:彻底解决 JDK API 的固有局限性;提供更符合网络编程直觉的开发者接口。

技术价值:卓越的内存管理灵活性(支持池化/非池化分配);零拷贝优化等性能增强特性。

知识衔接:深入理解其设计是掌握 Netty 数据处理模型的基础,直接关联

ChannelPipeline与ChannelHandler机制

1. ByteBuf 的 API

Netty 通过双组件抽象统一数据处理 API:

ByteBuf:字节容器的核心抽象类;ByteBufHolder:承载字节数据的接口。相比 JDK

ByteBuffer,ByteBuf实现突破性优化:扩展灵活性:支持自定义缓冲区类型

零拷贝透明化:内置复合缓冲区规避内存复制

动态容量:按需自动扩容(类似

StringBuilder)读写分离:无需显式

flip()切换模式;读写操作使用独立索引。链式编程:支持方法级联调用。

资源管理:引用计数精准控制内存生命周期。

性能优化:池化技术大幅降低内存分配开销。

扩展框架:专用管理类支持定制化分配策略与数据操作。

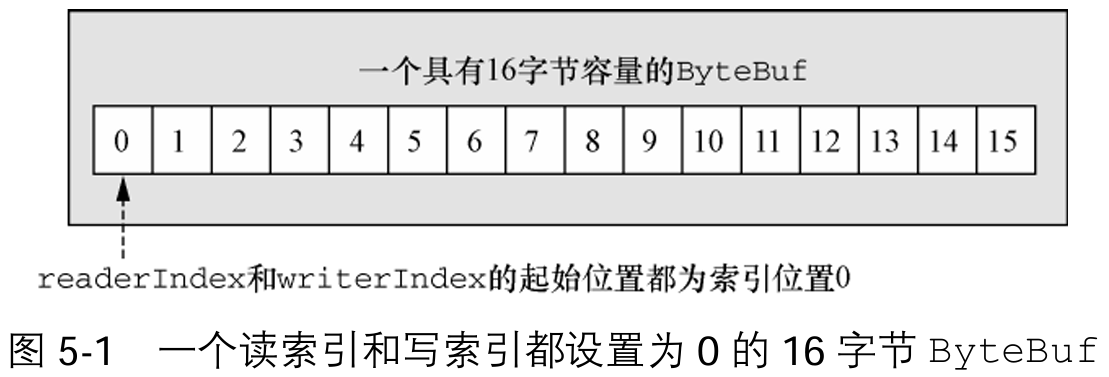

2. ByteBuf 类——Netty 的数据容器

①如何工作

索引机制与读写行为

ByteBuf采用双指针分离控制机制:读指针(

readerIndex):读取操作后自动递增(递增量为读取字节数),标识当前可读数据起始位置。写指针(

writerIndex):写入操作后自动递增(递增量为写入字节数),标识当前可写数据起始位置。关键约束:当

readerIndex == writerIndex时,表示已达数据末尾,继续读取将触发IndexOutOfBoundsException。

方法语义与边界保护

方法命名规范决定索引行为:

readXxx()/writeXxx()前缀方法 → 自动推进对应指针;getXxx()/setXxx()前缀方法 → 在传入的相对对索引操作,不改变指针位置。容量硬限制:默认最大容量为

Integer.MAX_VALUE;写指针超过该值(或预设的容量上限)→ 立即抛出异常。

②ByteBuf的使用模式

堆缓冲区

ByteBuf 最常用的实现模式将数据存储在 JVM 堆内存中(称为「支撑数组」),这种设计无需池化技术即可实现高速分配与释放,尤其适配需要处理遗留数据的场景。

/**

* 代码清单 5-1 支撑数组的使用示例

* <p>

* 演示如何安全访问 ByteBuf 的支撑数组(当存在时),

* 包括计算正确偏移量和处理无支撑数组的场景

*/

public class BackingArrayExample

{

public void processBuffer(ByteBuf heapBuf)

{

// 检查此 ByteBuf 实例是否由支撑数组提供支持

if (heapBuf.hasArray())

{

// 获取支撑数组的引用(即底层字节数组)

byte[] array = heapBuf.array();

/**

* 计算首个可读字节在数组中的偏移量:

* - arrayOffset() 返回缓冲区在数组中的起始位置

* - readerIndex() 返回当前读指针位置

* - 两者相加即数据起始位置在数组中的绝对偏移

*/

int offset = heapBuf.arrayOffset() + heapBuf.readerIndex();

// 获取可读字节数(writerIndex - readerIndex)

int length = heapBuf.readableBytes();

// 使用数组、偏移量和长度作为参数调用业务处理方法

handleArray(array, offset, length);

} else

{

/**

* 当 hasArray() 返回 false 时表示无支撑数组(直接缓冲区)。

* 此时尝试访问 array() 将抛出 UnsupportedOperationException。

*

* 处理策略:应改用直接内存访问方式(如 ByteBuffer.nioBuffer())

*/

handleDirectBuffer(heapBuf);

}

}

// 业务方法:处理支撑数组数据

private void handleArray(byte[] array, int offset, int length)

{

// 实现业务逻辑(此处仅为示意)

}

// 业务方法:处理直接缓冲区

private void handleDirectBuffer(ByteBuf directBuf)

{

// 实现直接缓冲区的处理逻辑(此处仅为示意)

}

}直接缓冲区

核心机制与价值

直接缓冲区通过本地调用在 JVM 堆外分配内存,其核心优势在于:

消除 I/O 复制开销:网络传输前 JVM 会将堆缓冲区内容复制到直接缓冲区,而直接缓冲区本身省去该步骤,显著减少数据移动成本。

网络传输优化:因数据始终驻留于非堆内存(不受垃圾回收影响),天然契合高频网络数据交换场景。

-

缺陷与适用准则

资源成本高:分配/释放开销显著高于堆缓冲区(涉及本地内存管理)

遗留系统适配复杂:非堆数据需额外复制到堆才能兼容传统数组访问逻辑

决策平衡点:优先选用场景:高频网络 I/O 操作(如网关、代理服务);避免选用场景:数据需频繁通过数组访问(如遗留数据处理系统)。

/**

* 代码清单 5-2 访问直接缓冲区的数据

* <p>

* 演示如何安全访问直接缓冲区的数据(当 ByteBuf 不由数组支撑时)

*/

public class DirectBufferAccessExample

{

public void processDirectBuffer(ByteBuf directBuf)

{

// 检查 ByteBuf 是否由数组支撑(通过内置方法)

// 如果不是,则表示这是一个直接缓冲区(堆外内存分配)

if (!directBuf.hasArray())

{

// 获取可读字节数(writerIndex - readerIndex)

int length = directBuf.readableBytes();

// 分配一个新的数组来保存缓冲区中的数据

// 创建与传统数组访问兼容的存储容器

byte[] array = new byte[length];

/**

* 将直接缓冲区的数据复制到新分配的数组中:

* - 从当前读指针位置开始(directBuf.readerIndex())

* - 复制整个可读数据段(length 字节)

* - 数据将被存入预分配的目标数组

*/

directBuf.getBytes(directBuf.readerIndex(), array);

/**

* 使用数组、偏移量和长度作为参数调用业务处理方法:

* - 数据内容:array(复制的字节数组)

* - 起始位置:0(数组起始索引)

* - 处理长度:array.length(完整数组长度)

*/

handleArray(array, 0, array.length);

}

// 注意:当 hasArray() 返回 true 时表示由数组支撑

// 应采用堆缓冲区的访问方式(见代码清单 5-1)

}

// 业务方法:处理数组形式的数据

private void handleArray(byte[] array, int offset, int length)

{

// 实现具体的业务逻辑(此处仅为示意)

System.out.println("Processing " + length + " bytes of data");

}

}复合缓冲区

复合缓冲区(

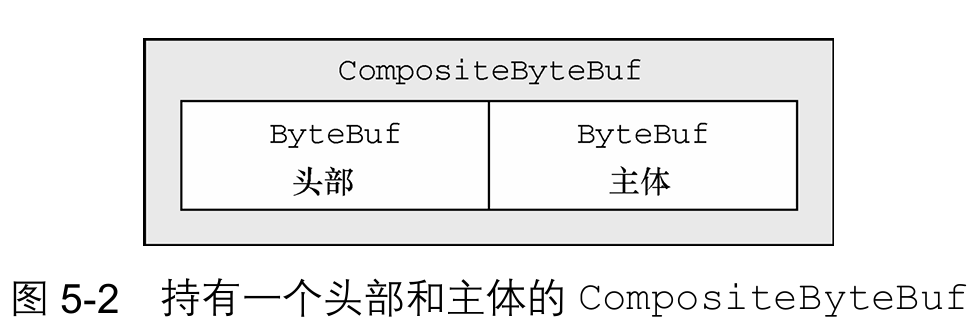

CompositeByteBuf)通过虚拟聚合视图统一管理多个独立ByteBuf(直接/堆内存混合),提供远超 JDKByteBuffer的灵活性:动态组合能力:支持运行时按需添加/删除ByteBuf实例,实现逻辑缓冲区动态伸缩。零拷贝优化:无需数据复制即可创建虚拟合并视图,规避分段数据的物理拼接开销。hasArray()的判定规则存在特例:仅含 1 个组件 → 继承该组件的hasArray()返回值(透传底层特性);包含 2+ 个组件 → 固定返回false(无论组件内存类型)。由于组件内存类型可能混合(堆/直接共存),业务层需避免依赖 array() 方法(多组件时必抛异常)。-

在 HTTP 消息传输中,若消息由应用程序不同模块生成的独立头部和主体组成(主体可被多个消息复用),每次发送消息需新建头部并组装复用主体时,传统方案需反复分配新缓冲区并进行数据复制,产生不必要的内存开销与性能损耗。

CompositeByteBuf 的破局价值:该方案通过虚拟聚合机制将头部与主体逻辑组合成单一消息视图:规避数据物理复制开销,仅维护组件引用关系;重用主体数据时,仅需新建头部并加入复合视图;对外暴露标准

ByteBuf API,兼容现有处理逻辑。Netty 通过

CompositeByteBuf深度优化套接字 I/O 操作,关键实现基于 JDK 分散/收集 I/O 技术(Scatter/Gather I/O):单次系统调用即可完成多缓冲区的聚合读写(从单个数据流写入/读取一组缓冲区),消除传统多次调用的性能损耗;彻底解决 JDK 缓冲区实现的内存使用效率瓶颈,显著降低高并发场景的资源开销(此优化作为 Netty 框架层的内核级实现,对开发者完全透明但持续生效)。

/**

* 代码清单 5-3 使用 ByteBuffer 的复合缓冲区模式

* <p>

* 传统 JDK ByteBuffer 实现复合缓冲区的方案需要创建数据副本:

* 1. 使用数组保存原始的消息组件(头部和主体)

* 2. 创建新的 ByteBuffer 合并所有数据

* 3. 通过复制操作将头部和主体数据物理拼接在一起

* <p>

* 这种方案通过数据复制实现复合效果,会带来额外内存开销和性能损耗,

* 不如 Netty 的 CompositeByteBuf(支持零拷贝复合视图)高效。

*/

public class CompositeBufferWithByteBuffer

{

public ByteBuffer createCompositeBuffer(ByteBuffer header, ByteBuffer body)

{

// 1. 创建数组保存消息部分(头部和主体)

// 使用 ByteBuffer 数组分别存储消息的各个组件

ByteBuffer[] message = new ByteBuffer[]{header, body};

/**

* 2. 创建新的 ByteBuffer 容器并通过复制合并头部和主体

* 计算所需总容量:header.remaining() + body.remaining()

* (注意:原图中为 remining(),实际应为 remaining())

*/

ByteBuffer message2 = ByteBuffer.allocate(header.remaining() + body.remaining());

// 3. 将头部数据复制到新缓冲区

// 保持源数据的 readerIndex 不变(使用相对位置操作)

message2.put(header);

// 4. 将主体数据复制到新缓冲区

// 在头部之后追加主体内容

message2.put(body);

// 5. 重置缓冲区状态:将 position 置为0,limit 设置为当前 position

// 准备后续的读取操作

message2.flip();

// 返回合并后的新缓冲区(包含头部和主体的完整副本)

return message2;

}

}/**

* 代码清单 5-4 使用 CompositeByteBuf 的复合缓冲区模式

* <p>

* 此方案通过虚拟聚合机制替代传统的内存复制,解决如下问题:

* 1. 消除分配新缓冲区的开销

* 2. 避免数据的物理复制操作

* 3. 简化组件管理逻辑

* 相比 JDK ByteBuffer 实现(见代码清单 5-3),显著提升效率且降低资源消耗

*/

public class CompositeBufferNettyExample

{

public void compositeBufferDemo()

{

// 1. 创建空的复合缓冲区(初始容量为0,按需自动扩展)

CompositeByteBuf messageBuf = Unpooled.compositeBuffer();

// 2. 创建模拟的消息组件(实际应用中可能由不同模块生成)

// - 头部缓冲区:堆缓冲区(包含UTF-8编码的"Header")

ByteBuf headerBuf = Unpooled.copiedBuffer("Header", CharsetUtil.UTF_8);

// - 主体缓冲区:直接缓冲区(包含二进制数据0x01, 0x02)

ByteBuf bodyBuf = Unpooled.directBuffer();

bodyBuf.writeByte(0x01);

bodyBuf.writeByte(0x02);

/**

* 3. 将头部和主体作为独立组件添加到复合缓冲区

* - 仅添加组件引用(零拷贝)

* - 组件类型可以是堆缓冲区/直接缓冲区的任意组合

* - 对外暴露单一ByteBuf接口

*/

messageBuf.addComponents(headerBuf, bodyBuf);

/**

* 4. 删除索引0位置的组件(即头部)

* - 实际移除的是组件引用,原缓冲区不受影响

* - 复合缓冲区自动更新视图

* - 资源管理:被移除的缓冲区需单独处理引用计数

*/

messageBuf.removeComponent(0); // 移除头部组件

// 5. 遍历复合缓冲区中的所有组件

// 展示如何访问每个独立ByteBuf实例

for (ByteBuf buf : messageBuf)

{

/**

* 处理逻辑说明:

* - 直接操作组件原始缓冲区(不复制数据)

* - 可独立处理每个组件的特性和状态

*/

System.out.println("Component buffer: " + buf.toString());

}

/**

* 6. 资源管理要求:

* 由于CompositeByteBuf不持有数据所有权,需确保:

* - 添加的组件最后必须手动释放(release())

* - 复合缓冲区本身也需要释放

*/

headerBuf.release(); // 释放头部

bodyBuf.release(); // 释放主体

messageBuf.release(); // 释放复合视图

}

}/**

* 代码清单 5-5 访问 CompositeByteBuf 中的数据

* <p>

* CompositeByteBuf 可能不支持访问其支撑数组(取决于底层组件结构),

* 因此访问其数据的模式需类似直接缓冲区的处理方式:

* 1. 先获取可读字节数

* 2. 在堆中创建新的字节数组

* 3. 将数据复制到该数组

* 4. 通过数组处理数据

* <p>

* 此方案确保与底层组件的存储形式(堆/直接)无关的兼容访问。

*/

public class CompositeBufferAccessExample

{

public void processCompositeBuffer(CompositeByteBuf compBuf)

{

// 1. 获取可读字节数(writerIndex - readerIndex)

// 表示CompositeByteBuf中可读取的数据长度

int length = compBuf.readableBytes();

// 2. 分配一个具有可读字节数长度的新数组(堆内存)

// 创建与传统数组访问兼容的存储容器

byte[] array = new byte[length];

/**

* 3. 将字节从CompositeByteBuf读到数组中:

* - compBuf.getBytes(起始位置, 目标数组)

* - compBuf.readerIndex():获取当前读指针位置

* - array:作为目标字节数组接收数据

* 注意:无论底层组件是堆缓冲区还是直接缓冲区,

* 此方法都会进行必要的格式转换和数据复制

*/

compBuf.getBytes(compBuf.readerIndex(), array);

/**

* 4. 使用数组、偏移量和长度作为参数调用业务处理方法:

* - 数组内容:array(完整数据)

* - 起始位置:0(数组起始索引)

* - 处理长度:array.length(完整数组长度)

* 这种方式使业务逻辑保持统一的数据访问接口

*/

handleArray(array, 0, array.length);

}

// 业务方法:处理数组形式的数据

private void handleArray(byte[] array, int offset, int length)

{

// 实现具体的业务逻辑(此处仅为示意)

System.out.println("Processing composite data: " + length + " bytes");

}

// 测试用例

public static void main(String[] args)

{

CompositeBufferAccessExample example = new CompositeBufferAccessExample();

// 创建复合缓冲区(包含多个不同类型的组件)

CompositeByteBuf compBuf = Unpooled.compositeBuffer();

// 添加堆缓冲区组件

ByteBuf heapBuf = Unpooled.copiedBuffer("Header", CharsetUtil.UTF_8);

compBuf.addComponent(heapBuf);

// 添加直接缓冲区组件

ByteBuf directBuf = Unpooled.directBuffer();

directBuf.writeBytes(new byte[]{0x01, 0x02, 0x03});

compBuf.addComponent(directBuf);

// 更新写索引(使可读字节计算生效)

compBuf.writerIndex(heapBuf.readableBytes() + directBuf.readableBytes());

// 处理复合缓冲区数据

example.processCompositeBuffer(compBuf);

// 资源释放(实际应用中必须执行)

compBuf.release();

}

}3. 字节级操作

①随机访问索引

/**

* 代码清单 5-6 访问数据

* <p>

* 此示例演示如何安全遍历 ByteBuf 的内容,同时保持 readerIndex 和 writerIndex 不变。

* 实现基于 ByteBuf 的核心索引规则:索引从 0 开始,最后一个字节索引为 capacity() - 1。

*/

public class ByteBufAccessExample

{

public void accessDataSafely(ByteBuf buffer)

{

/**

* ByteBuf 索引规则:

* 1. 索引从零开始(类同普通 Java 字节数组)

* 2. 第一个字节索引 = 0

* 3. 最后一个字节索引 = capacity() - 1

*

* 注意:使用带索引参数的方法访问数据不会改变 readerIndex/writerIndex,

* 封装存储机制使遍历操作保持简洁。

*/

// 遍历缓冲区所有字节(从索引0到capacity()-1)

for (int i = 0; i < buffer.capacity(); i++)

{

/**

* 使用带索引参数的 getByte() 方法访问数据:

* - 读取指定索引位置的字节(不改变读指针位置)

* - 保持 readerIndex 和 writerIndex 不变

* - 可安全用于检测性访问操作

*/

byte b = buffer.getByte(i);

// 将字节转为字符输出(演示用途)

System.out.println((char) b);

}

/**

* 指针手动控制说明:

* 如有需要,可通过以下方法显式移动指针位置:

* buffer.readerIndex(index) - 设置读指针位置

* buffer.writerIndex(index) - 设置写指针位置

*

* 使用场景:

* 1. 重置缓冲区状态

* 2. 跳过特定数据段

* 3. 精确控制读写位置

*/

}

// 测试方法

public static void main(String[] args)

{

// 示例缓冲区初始化(实际使用需传入具体 ByteBuf 实例)

ByteBuf buffer = Unpooled.copiedBuffer("Netty ByteBuf Example", CharsetUtil.UTF_8);

// 创建访问实例

ByteBufAccessExample accessor = new ByteBufAccessExample();

// 执行数据访问(保持指针不变)

accessor.accessDataSafely(buffer);

// 验证指针未改变

System.out.println("ReaderIndex remains: " + buffer.readerIndex());

System.out.println("WriterIndex remains: " + buffer.writerIndex());

// 资源释放(重要!)

buffer.release();

}

}②顺序访问索引

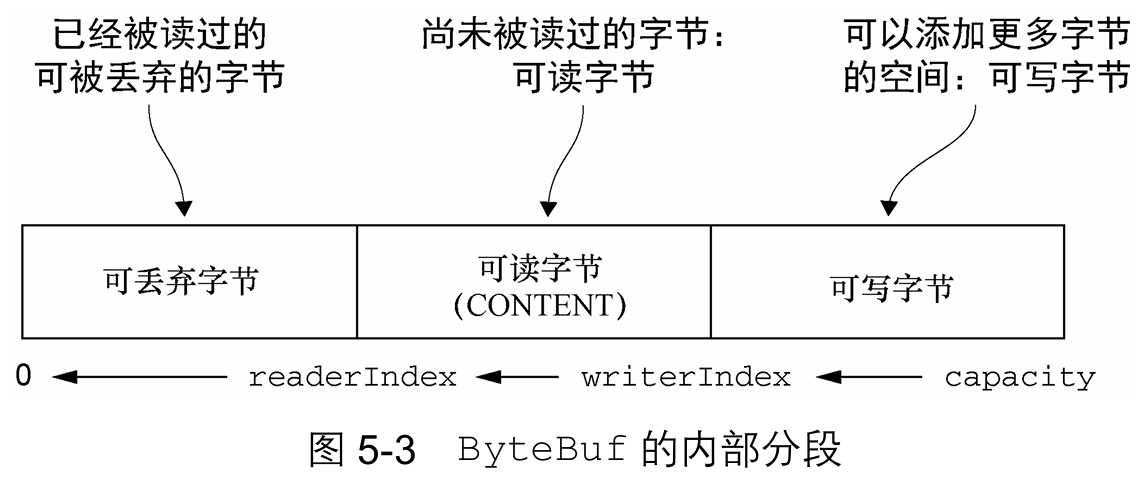

ByteBuf 通过独立维护读、写双索引,将缓冲区划分为三个逻辑区域(已读丢弃区/可读数据区/可写空间区),彻底消除 JDK ByteBuffer 因单索引限制强制进行读写模式切换(flip())的设计缺陷,从根本上规避状态管理错误与边界计算风险。

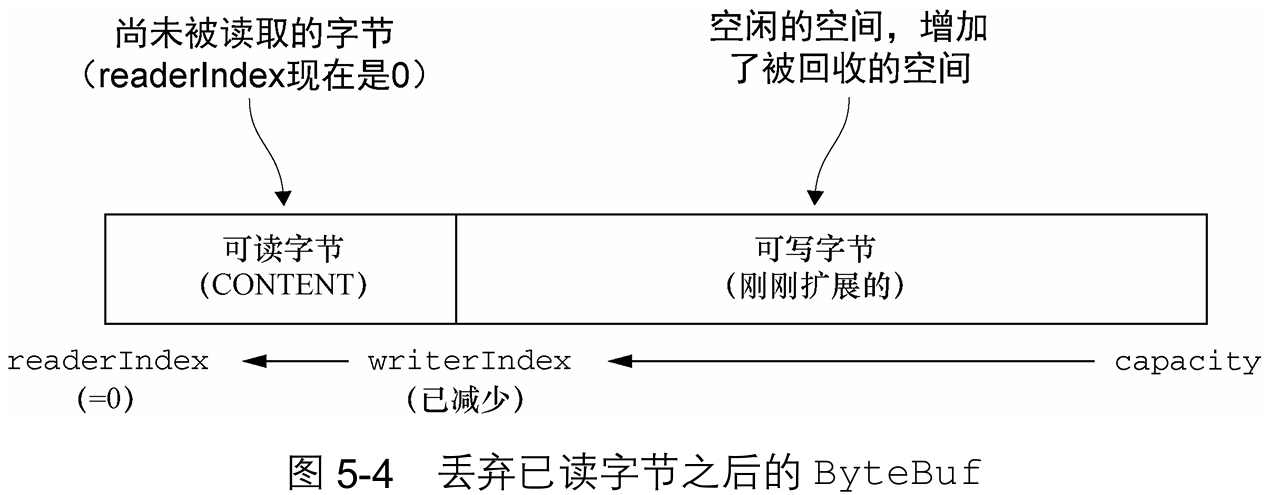

③可丢弃字节

空间回收机制

discardReadBytes()方法专为回收已读字节分段(readerIndex 之前的区域)设计:空间动态管理:随着

read操作执行,已读分段自动扩展(get操作不移动 readerIndex,保持分段稳定)回收核心作用:将已读空间并入可写区域,扩展有效可用容量

内容可靠性约束:新释放的可写区域内容状态未定义(可能残留旧数据)

性能调优建议

尽管空间最大化具有吸引力,但需警惕关键性能陷阱:

内存复制开销:移动可读数据(CONTENT 段)至缓冲区起始位置需完整复制

高频调用风险:频繁触发将导致写性能指数级下降

使用准则:仅在内存资源极度紧缺时启用(如嵌入式设备),常规场景应避免使用。

④可读字节

初始状态:所有新分配、包装或复制的

ByteBuf的readerIndex默认为 0,可读分区即有效数据存储区。读写操作影响:所有

read/skip前缀方法:从当前readerIndex检索/跳过数据,操作后自动递增readerIndex(增量=操作字节数)。readBytes(ByteBuf dest)等写入操作(被调用的方法需要一个ByteBuf参数作为写入的目标):未指定目标索引时,同步递增目标缓冲区的writerIndex。耗尽检测:当

readerIndex == writerIndex(无可读字节)时继续读取 → 立即抛出IndexOutOfBoundsException。

/**

* 代码清单 5-7 读取所有数据

* <p>

* 安全高效的数据读取方案:

* 1. 基于缓冲区可读状态驱动轮询机制

* 2. 自动处理字节消耗与指针更新

* 3. 确保数据完整性和边界安全

*/

public class ByteBufDataReader

{

public void readEntireBuffer()

{

// 示例缓冲区初始化(实际应用中可来自任意ByteBuf实现)

// 提示:此处省略具体赋值细节(对应原始图片的"..."表示法)

ByteBuf buffer = Unpooled.copiedBuffer("Netty", CharsetUtil.UTF_8);

/**

* 核心读取机制:

* while (buffer.isReadable())

* - 自动检测可读数据状态(readerIndex < writerIndex)

* - 无数据时自动终止,避免边界溢出异常

*/

while (buffer.isReadable())

{

/**

* 关键读取操作:

* System.out.println(buffer.readByte());

* - readByte():读取单字节(自动递增readerIndex)

* - 字节转int输出:默认打印0-255数值

* - 配套指针管理:完成读操作后自动更新索引

*/

System.out.println(buffer.readByte());

} // while循环结束范围(对应原始图片的右花括号)

/**

* 循环终止特征:

* 此时readerIndex == writerIndex

* 缓冲区进入无数据可读状态(后续read操作将抛异常)

*/

}

}⑤可写字节

可写字节分段指缓冲区中待写入的未初始化内存区域。新分配缓冲区时,writerIndex 默认值为 0。所有以 "write" 开头的操作(如 writeBytes)均遵循以下机制:

从当前 writerIndex 开始写入数据;

写入后自动递增 writerIndex(增加值为写入字节数);

若写入目标为 ByteBuf 且未指定源索引,源缓冲区的 readerIndex 会同步增加相同大小→ 典型示例:

writeBytes(ByteBuf dest)重要约束:尝试写入超出目标容量的数据时,会触发

IndexOutOfBoundsException异常。在往ByteBuf中写入数据时,其将首先确保目标ByteBuf具有足够的可写入空间来容纳当前要写入 的数据,如果没有,则将检查当前的写索引以及最大容量是否可以在扩展后容纳该数据,可以则会分配 并调整容量,否则就会抛出该异常。

/**

* 代码清单 5-8:缓冲区写入操作

* <p>

* 功能说明:使用随机整数值填充缓冲区的可写空间

* <p>

* 核心机制:

* 1. 通过writableBytes()检测剩余可用空间

* 2. 当剩余空间≥4字节(int类型大小)时执行写入

* 3. 每次写入后自动更新writerIndex指针

*/

public class BufferWriterExample

{

// 随机数生成器,用于创建测试数据

private static final Random random = new Random();

public static void main(String[] args)

{

// 创建容量为16字节的缓冲区(演示用,实际大小根据需要调整)

ByteBuf buffer = Unpooled.buffer(16);

/**

* 数据填充循环:

* while (buffer.writableBytes() >= 4)

* - 持续检测可用空间,要求≥4字节(整型数据大小)

* - 当空间不足时自动终止写入操作

*/

System.out.println("开始填充缓冲区...");

while (buffer.writableBytes() >= 4)

{

// 生成随机整数(范围:Integer.MIN_VALUE ~ Integer.MAX_VALUE)

int randomValue = random.nextInt();

/**

* 关键写入操作:

* buffer.writeInt(randomValue)

* - 写入4字节整型数据到当前writerIndex位置

* - 自动递增writerIndex指针(增加4字节)

*/

buffer.writeInt(randomValue);

System.out.println("写入值: " + randomValue);

}

// 输出最终状态

System.out.println("\n缓冲区填充完成");

System.out.println("已用空间: " + buffer.readableBytes() + "字节");

System.out.println("剩余空间: " + buffer.writableBytes() + "字节");

System.out.println("总容量: " + buffer.capacity() + "字节");

}

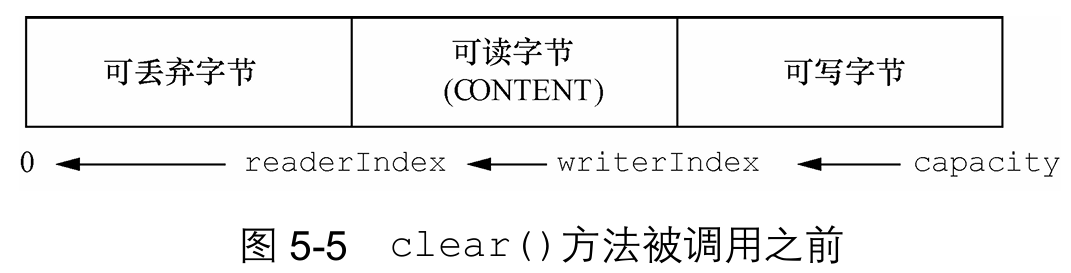

}⑥索引管理

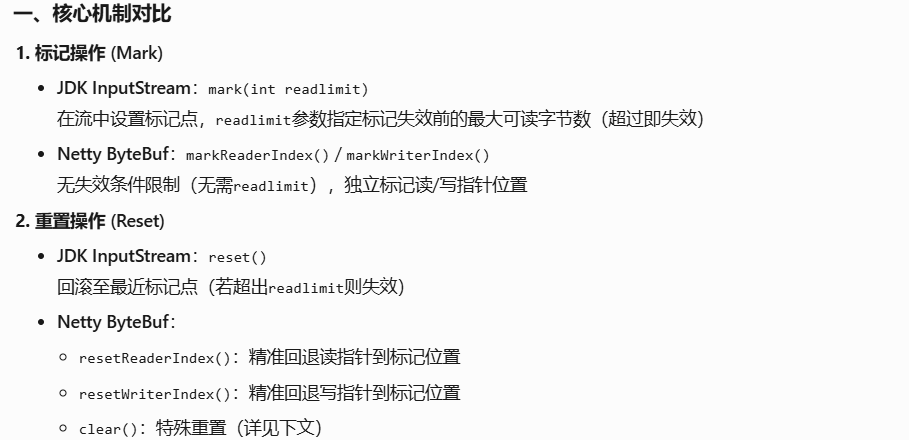

索引操作机制对比

JDK 的

InputStream提供mark(int readlimit)和reset()方法进行流位置标记与重置。Netty 的ByteBuf提供更灵活的索引控制:标记(mark):记录当前读索引或写索引的位置。

重置(reset):将读索引或写索引恢复到之前标记的位置。

标记和重置是一对操作:先标记,然后可能在移动索引后重置回到标记点。

标记/重置方法:

markReaderIndex()/resetReaderIndex():读写指针独立标记与重置;markWriterIndex()/resetWriterIndex():无需readlimit参数,无失效条件限制。精准定位:支持

readerIndex(int)和writerIndex(int)直接将索引移动到指定位置,非法位置会触发IndexOutOfBoundsException。内存保留特性:调用

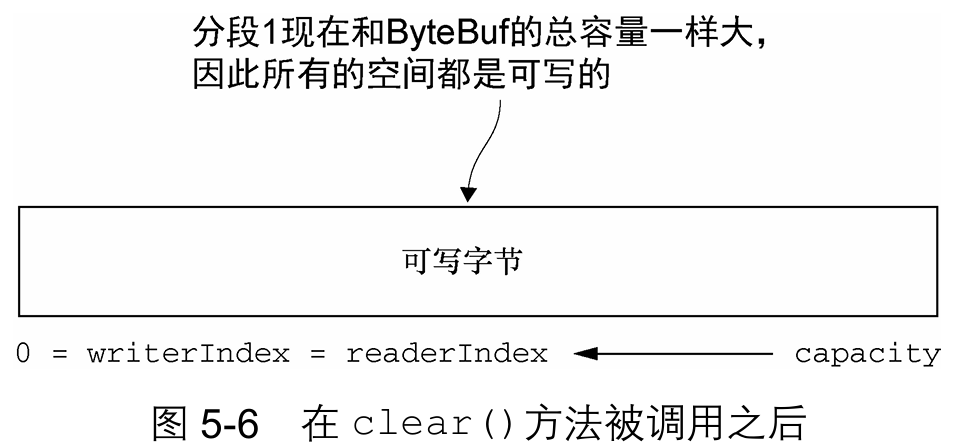

clear()时仅重置读写索引(readerIndex=0,writerIndex=0),不清除内存数据,原始内容仍保留但可被覆盖。

clear() 的核心优势

clear()操作相比discardReadBytes()具有显著性能优势:零内存复制:仅重置双指针(O(1)时间复杂度),不触发内存块移动

高效复用:保留完整内存块,实现缓冲区瞬时重置,尤其适合高频重用的网络缓冲区场景

规避碎片化:避免内存复制产生的计算开销和潜在的内存碎片问题

⑦查找操作

在 ByteBuf 中查找指定值有两种核心方法:

indexOf()方法提供直接值索引定位能力;通过ByteBufProcessor实现复杂查询:boolean process(byte value) // 检测输入值是否为查找目标提供常见值的预定义方法(如FIND_NUL处理 NULL 终止符),针对 Flash 套接字等 NULL 结尾数据场景优化,显著减少边界检查操作。版本演进说明:历史方案:ByteBufProcessor(Netty 4.0.x);当前方案:ByteProcessor(Netty 4.1.x+)。已在 4.1.x 版本废弃前者,迁移至 io.netty.util.ByteProcessor。

技术演进本质:该优化标志着从专用处理器(ByteBufProcessor)向通用字节处理器(ByteProcessor)的架构升级。新方案通过接口统一化和处理逻辑标准化,在保持 NULL 值处理等核心优势(低边界检查开销)的同时,大幅增强扩展性和跨场景适用性,为协议解析提供更强大的基础设施支持。

import io.netty.buffer.ByteBufProcessor; // 注意: Netty 4.0.x 方案

//import io.netty.util.ByteProcessor; // Netty 4.1.x+ 替代方案

/**

* 代码清单 5-9 使用 ByteBufProcessor 查找回车符(CR)

* <p>

* 核心功能:

* 在 ByteBuf 缓冲区中定位回车符(CR,'\r')的索引位置

* <p>

* 实现要点:

* 1. 使用字节处理器简化边界检查和状态管理

* 2. 内置针对特定字符优化的查找算法

* 3. 返回第一个匹配项的缓冲区索引(未找到返回-1)

*/

public class CRFinderExample

{

public static void main(String[] args)

{

// 伪代码:实际应用中应初始化有效ByteBuf实例

// 示例:ByteBuf buffer = Unpooled.copiedBuffer("Data\rEnd", CharsetUtil.US_ASCII);

ByteBuf buffer = ...; // 实际使用时应替换为有效的ByteBuf初始化

/**

* 关键查找操作:

* buffer.forEachByte(ByteBufProcessor.FIND_CR)

* - 参数:使用预定义的CR定位处理器(处理ASCII 13)

* - 过程:从readerIndex到writerIndex顺序扫描

* - 返回值:首个CR的字节索引(未找到时返回-1)

*

* 版本注意:

* Netty 4.1.x+ 已迁移至 ByteProcessor 接口

* 等价写法:buffer.forEachByte(ByteProcessor.FIND_CR)

*/

int crIndex = buffer.forEachByte(ByteBufProcessor.FIND_CR);

// 结果输出演示

if (crIndex != -1)

{

System.out.println("发现回车符(CR)位置: " + crIndex);

} else

{

System.out.println("未找到回车符(CR)");

}

}

}⑧派生缓冲区

派生缓冲区提供对原始 ByteBuf 的低成本只读视图,包含两类基础创建方式:

duplicate():创建与源缓冲区完全共享数据的视图;slice():截取源缓冲区局部内容创建视图。(所有派生缓冲区共享底层存储,修改视图内容会直接影响源数据)。增强型视图方法(扩展基础功能)(均继承基础特性:独立索引但共享存储):

slice(int,int):指定位置截取Unpooled.unmodifiableBuffer(...):创建不可修改视图order(ByteOrder):指定字节序视图readSlice(int):动态读取时截取真·副本机制(规避共享风险):

copy()/copy(int,int)创建完全独立缓冲区数据修改互不影响,适用于需要隔离操作的场景

public class ByteBufReplicationDemo

{

public static void main(String[] args)

{

// =======================================================================

// 1. 独立副本演示 - 数据隔离操作

// =======================================================================

// 创建UTF-8字符集

Charset utf8 = Charset.forName("UTF-8");

// 创建原始ByteBuf存储字符串

ByteBuf originBuf = Unpooled.copiedBuffer("Netty in Action rocks!", utf8);

// 创建索引0-15的独立副本(完整内存复制)

ByteBuf fullCopy = originBuf.copy(0, 15);

System.out.println("副本初始内容: " + fullCopy.toString(utf8));

// 修改原始缓冲区首字节

originBuf.setByte(0, (byte) 'J');

// 验证数据隔离性(副本不受原始缓冲区修改影响)

assert originBuf.getByte(0) != fullCopy.getByte(0);

System.out.println("副本隔离验证通过: " + fullCopy.toString(utf8));

// =======================================================================

// 2. 切片演示 - 共享数据操作

// =======================================================================

ByteBuf sliceBuf = originBuf.slice(0, 15);

System.out.println("切片初始内容: " + sliceBuf.toString(utf8));

// 修改原始缓冲区索引1位置

originBuf.setByte(1, (byte) 'E');

// 验证数据共享性(切片数据随原始缓冲区自动更新)

assert sliceBuf.getByte(1) == originBuf.getByte(1);

System.out.println("切片共享验证通过: " + sliceBuf.toString(utf8));

System.out.println("\n>> 关键结论:优先使用slice()避免内存复制开销");

}

}⑨读/写操作

get()/set()索引固定操作:这类方法从指定索引位置读写数据,操作完成后索引位置保持不变。适用于随机访问特定内存区域场景。read()/write()索引动态操作:这类方法从当前索引开始读写数据,操作后索引会自动向后移动已访问的字节数。适用于顺序流式处理场景。

代码清单5-12 get()和set()方法的用法

public class ByteBufGetSetExample

{

public static void main(String[] args)

{

// =======================================================================

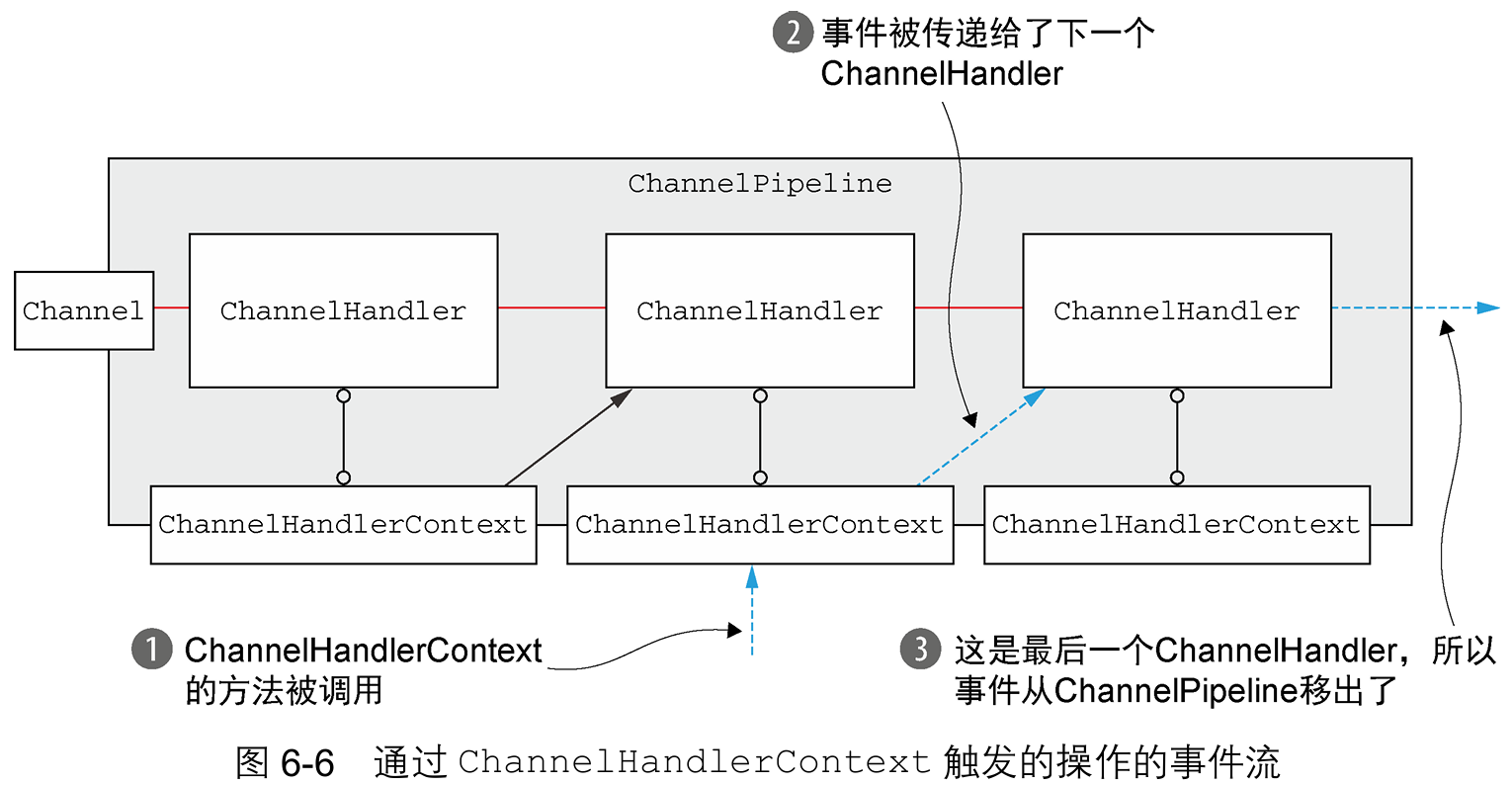

// 创建一个新的ByteBuf以保存给定字符串的字节

// =======================================================================

Charset utf8 = Charset.forName("UTF-8");

ByteBuf buf = Unpooled.copiedBuffer("Netty in Action rocks!", utf8);

// 打印第一个字符(初始状态为'N')

System.out.println((char) buf.getByte(0));

// =======================================================================

// 存储当前的readerIndex和writerIndex

// =======================================================================

int readerIndex = buf.readerIndex();

int writerIndex = buf.writerIndex();

// =======================================================================

// 将索引0处的字节更新为字符'B'

// =======================================================================

buf.setByte(0, (byte) 'B');

// 打印修改后的第一个字符(现在变为'B')

System.out.println((char) buf.getByte(0));

// =======================================================================

// 验证索引未被修改(断言将会成功)

// =======================================================================

assert readerIndex == buf.readerIndex();

assert writerIndex == buf.writerIndex();

}

}read()操作,其作用于当前的readerIndex或writerIndex。这些方法将用于从ByteBuf中读取数据,如同它是一个流。

几乎每个read()方法都有对应的write()方法,用于将数据追加到ByteBuf中。注意,表写操作中所列出的这些方法的参数是需要写入的值,而不是索引值。

public class ByteBufReadWriteDemo

{

public static void main(String[] args)

{

// =======================================================================

// 创建一个新的ByteBuf以保存给定字符串的字节

// =======================================================================

// 获取UTF-8字符集

Charset utf8 = Charset.forName("UTF-8");

// 将字符串转换为ByteBuf

ByteBuf buf = Unpooled.copiedBuffer("Netty in Action rocks!", utf8);

// 读取并打印第一个字符(应为'N')

System.out.println((char) buf.readByte());

// =======================================================================

// 存储当前的readerIndex和writerIndex

// =======================================================================

// 记录读取索引位置(此时readerIndex应为1,表示已读取1个字节)

int readerIndex = buf.readerIndex();

// 记录写入索引位置(此时writerIndex应为整个字符串的长度)

int writerIndex = buf.writerIndex();

// =======================================================================

// 将字符'?'追加到缓冲区(此操作会移动写索引)

// =======================================================================

// 向缓冲区写入一个新字节,表示字符'?'

buf.writeByte((byte) '?');

// =======================================================================

// 断言验证索引变化

// =======================================================================

// 断言1:读取索引未改变(应为true)

assert readerIndex == buf.readerIndex();

System.out.println("断言1通过:readerIndex未改变");

// 断言2:写入索引已改变(应为true)

assert writerIndex != buf.writerIndex();

System.out.println("断言2通过:writerIndex已改变");

// 打印验证结果

System.out.println("\n操作验证完成:read操作改变readerIndex,write操作改变writerIndex");

}

}⑩其他操作

4. ByteBufHolder接口

作为 Netty 的高级数据容器,ByteBufHolder 解决协议元数据与负载的集成管理问题:

功能本质:提供统一容器封装数据负载(实际字节内容)与协议元数据(如状态码、Cookie 等属性)。

扩展价值:为 Netty 缓冲区池化等高级特性提供基础设施,支持:从对象池借用 ByteBuf 实例;通过引用计数实现资源自动释放。

5. ByteBuf分配

①按需分配:ByteBufAllocator接口

Netty 通过

ByteBufAllocator接口实现 ByteBuf 的池化机制,核心解决内存分配与释放的开销问题:功能本质:统一分配任意类型的 ByteBuf(包括堆/直接/复合缓冲区)

性能优化:通过对象复用降低内存分配频率

注:池化是 Netty 高效内存管理的基石技术

两种核心方式获取

ByteBufAllocator实例:通道级分配器:

channel.alloc() // 每个 Channel 可独立配置不同分配器处理器上下文分配器:

ctx.alloc() // 通过 ChannelHandlerContext 获取

Netty提供了两种ByteBufAllocator的实现:PooledByteBufAllocator和Unpooled-ByteBufAllocator。

默认行为:Netty 默认启用

PooledByteBufAllocator自定义配置:通过

ChannelConfigAPI 运行时修改;应用程序引导阶段显式设置分配器。实例化特性:每次调用

alloc()返回新的 ByteBuf 实例。

②Unpooled 缓冲区

针对无法获取

ByteBufAllocator引用的场景(如脱离 Netty 容器的独立模块),Netty 提供 Unpooled 统一入口类,通过静态方法创建非池化ByteBuf实例。其核心价值包括:提供类似buffer()、directBuffer()等辅助方法,无需依赖分配器即可快速初始化缓冲区;跳过池化内存管理流程,直接响应"立即创建缓冲区"的轻量需求。Unpooled 类使 ByteBuf 的能力突破网络编程边界:

非网络项目集成:允许文件处理、本地计算等场景直接调用高性能缓冲区 API,无需引入 Netty 网络组件。

技术红利共享:零拷贝、双索引管理等优化特性可复用于算法开发、数据转换等通用计算任务,显著降低高性能缓冲区的技术复用门槛,推动 Netty 生态向更广泛技术领域渗透。

③ByteBufUtil 类

ByteBufUtil是 Netty 提供的静态辅助工具集,其核心设计原则为:功能解耦:独立于池化机制外实现通用缓冲区操作(如十六进制转换、内容比对),避免与

ByteBufAllocator功能重叠。零依赖:静态方法无需实例化即可调用,适用于脱离容器的独立模块。

6. 引用计数

引用计数通过跟踪对象资源的活动引用数实现内存优化:对象创建时引用计数为 1(如 Netty 的

ByteBuf/ByteBufHolder);引用计数 > 0 时对象保持活跃状态;计数归 0 时自动释放资源(具体释放逻辑由实现类定义)此机制是池化技术(如 PooledByteBufAllocator)的基石,显著降低内存分配开销。通过

ReferenceCounted接口统一管理引用计数;子类可自定义释放逻辑(如强制归零释放);访问已释放对象将抛出IllegalReferenceCountException释放引用计数对象:最后访问对象的一方负责调用

release();释放动作需结合ChannelHandler和ChannelPipeline生命周期;避免重复释放,防止访问已释放对象。

public class CombinedReferenceCountDemo

{

public static void main(String[] args)

{

// 创建模拟通道环境(实际应用中从真实网络连接获取)

Channel channel = new EmbeddedChannel();

// =================================================================

// 代码清单5-15:引用计数获取与验证

// =================================================================

// 1. 从通道获取ByteBuf分配器

ByteBufAllocator allocator = channel.alloc();

System.out.println("获取ByteBufAllocator实例:" + allocator.getClass().getSimpleName());

// 2. 分配新的ByteBuf缓冲区

ByteBuf buffer = allocator.buffer();

System.out.println("创建新的ByteBuf实例:" + buffer.getClass().getSimpleName());

// 3. 检查初始引用计数(应为1)

int initialRefCnt = buffer.refCnt();

System.out.println("初始引用计数: " + initialRefCnt);

assert initialRefCnt == 1 : "引用计数初始值应为1";

// =================================================================

// 代码清单5-16:引用计数释放与验证

// =================================================================

// 4. 减少引用计数(释放操作)

boolean released = buffer.release();

System.out.println("释放操作结果: " + released);

// 5. 检查释放后引用计数

int afterReleaseRefCnt = buffer.refCnt();

System.out.println("释放后引用计数: " + afterReleaseRefCnt);

assert afterReleaseRefCnt == 0 : "释放后引用计数应为0";

assert released : "释放操作应返回true";

// 6. 验证资源状态

try

{

buffer.writeByte(0x01); // 尝试访问已释放对象

System.err.println("错误:应抛出IllegalReferenceCountException异常");

} catch (Exception e)

{

System.out.println("预期异常: " + e.getClass().getSimpleName() + " - 对象已成功释放");

}

}

}五. ChannelHandler和ChannelPipeline

1. ChannelHandler家族

①Channel的生命周期

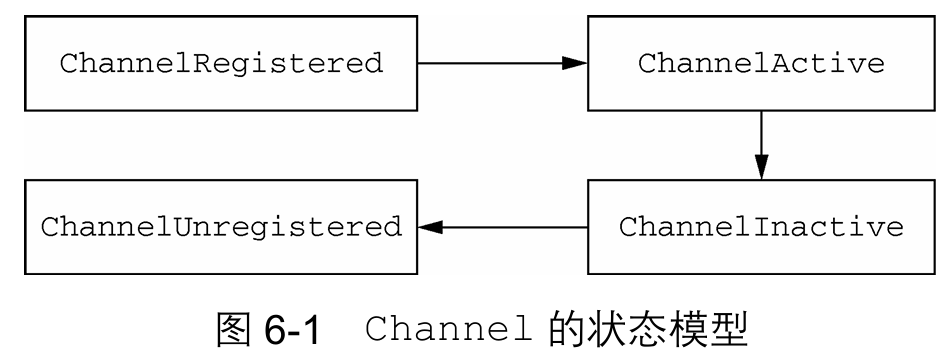

Interface Channel定义了一组和ChannelInboundHandlerAPI密切相关的简单但功能强大的状态模型,表 Channel的生命周期状态 列出了Channel的这4个状态。Channel 的正常生命周期如图6-1所示。当这些状态发生改变时,将会生成对应的事件。 这些事件将会被转发给ChannelPipeline中的ChannelHandler,其可以随后对它们做出响应。

②ChannelHandler的生命周期

表 ChannelHandler的生命周期方法 中列出了interface ChannelHandler定义的生命周期操作,在ChannelHandler 被添加到ChannelPipeline中或者被从ChannelPipeline中移除时会调用这些操作。这些方法中的每一个都接受一个ChannelHandlerContext参数。

Netty 定义了下面两个重要的ChannelHandler子接口:

ChannelInboundHandler处理入站数据以及各种状态变化;ChannelOutboundHandler处理出站数据并且允许拦截所有的操作。

③ChannelInboundHandler接口

ChannelInboundHandler 的生命周期方法(详见表 ChannelInboundHandler的方法 )通过事件驱动机制响应两类核心操作:网络数据接收事件与关联 Channel 的状态变更事件,其触发逻辑与 Channel 的生命周期深度绑定。

/**

* 代码清单 6-1 释放消息资源

* <p>

* 本处理器用于丢弃已接收的消息,并负责释放与池化ByteBuf实例相关的内存。

* <p>

* 关键说明:

* 1. 当ChannelInboundHandler重写channelRead()方法时,需显式释放池化的ByteBuf内存

* 2. Netty提供ReferenceCountUtil.release()作为标准释放方法

* 3. 本处理器被标注为@Sharable,表示可安全地在多个Channel间共享实例

*/

@ChannelHandler.Sharable

public class DiscardHandler extends ChannelInboundHandlerAdapter

{

/**

* 重写channelRead方法处理入站数据

*

* @param ctx ChannelHandler上下文对象,提供操作接口

* @param msg 接收到的消息对象(可能是池化ByteBuf)

*/

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg)

{

/**

* 核心释放操作:

* 调用ReferenceCountUtil.release(msg)释放消息资源

* - 减少引用计数

* - 当引用计数归零时自动释放池化内存

* - 适用于任何实现了ReferenceCounted接口的对象

*/

ReferenceCountUtil.release(msg);

// 注意:此处未调用父类方法,因仅需丢弃消息无需传递

}

}/**

* 代码清单 6-2 使用 SimpleChannelInboundHandler

* <p>

* 本处理器是代码清单 6-1 的优化变体,利用 Netty 的 {@link SimpleChannelInboundHandler}

* 简化资源管理流程,避免手动释放资源带来的繁琐操作。

* <p>

* 关键改进:

* 1. 继承 {@link SimpleChannelInboundHandler} 而非基本处理器

* 2. 自动释放入站消息资源(无需显式调用 release())

* 3. 通过泛型指定可处理的消息类型(此处为 {@code Object})

* <p>

* 警告说明:

* Netty 默认使用 WARN 级别日志记录未释放资源,可帮助发现违规实例。但手动资源管理较繁琐,

* {@link SimpleChannelInboundHandler} 提供更加简单安全的资源管理机制。

*/

@ChannelHandler.Sharable // 可安全地在多个 Channel 间共享

public class SimpleDiscardHandler extends SimpleChannelInboundHandler<Object>

{

/**

* 处理入站消息的核心方法(自动资源释放)

*

* @param ctx ChannelHandler 上下文对象,提供操作接口

* @param msg 接收到的消息对象(自动释放的资源)

* <p>

* 方法说明:

* 1. 此方法为 channelRead() 的精简版,专注消息处理

* 2. 消息处理完成后会自动释放关联资源

* 3. 无需执行任何特殊操作即可获得资源管理优势

*/

@Override

protected void channelRead0(ChannelHandlerContext ctx, Object msg)

{

// 无需任何操作(演示空实现)

// 所有消息资源会在方法返回时由框架自动释放

// 重要:不要存储消息引用!

// 由于消息将被自动释放,存储引用会导致后续访问无效/异常

}

/**

* 资源管理机制说明:

*

* 1. 自动释放原理:

* {@link SimpleChannelInboundHandler} 在 channelRead0()

* 执行后自动调用 {@code ReferenceCountUtil.release(msg)}

*

* 2. 引用失效警告:

* 由于消息资源会被自动释放,禁止将消息对象(msg)存储到:

* - 类成员变量

* - 静态集合

* - 异步回调上下文

* 否则后续访问将引发 IllegalReferenceCountException

*

* 3. 使用场景限制:

* 此模式适用于无需保留消息引用的快速消费场景

* 若需延迟处理,应使用 {@link ReferenceCounted#retain()} 增加引用计数

*/

}④ChannelOutboundHandler接口

ChannelOutboundHandler是 Netty 处理出站操作的唯一接口,其核心特性包括:方法由Channel、ChannelPipeline和ChannelHandlerContext三方触发;支持通过操作推迟机制优化复杂场景(如远程写入暂停时暂存冲刷操作)。作为

ChannelFuture(不可变)的可变子类,ChannelPromise在出站处理中承担异步状态枢纽:所有ChannelOutboundHandler方法必须接收ChannelPromise参数;独有setSuccess()/setFailure()方法主动标记操作结果;结果标记后立即锁定状态(任何二次修改触发异常)。该设计实现操作生命周期闭环:执行→通知→状态固化,为高可靠网络编程提供原子性保障。

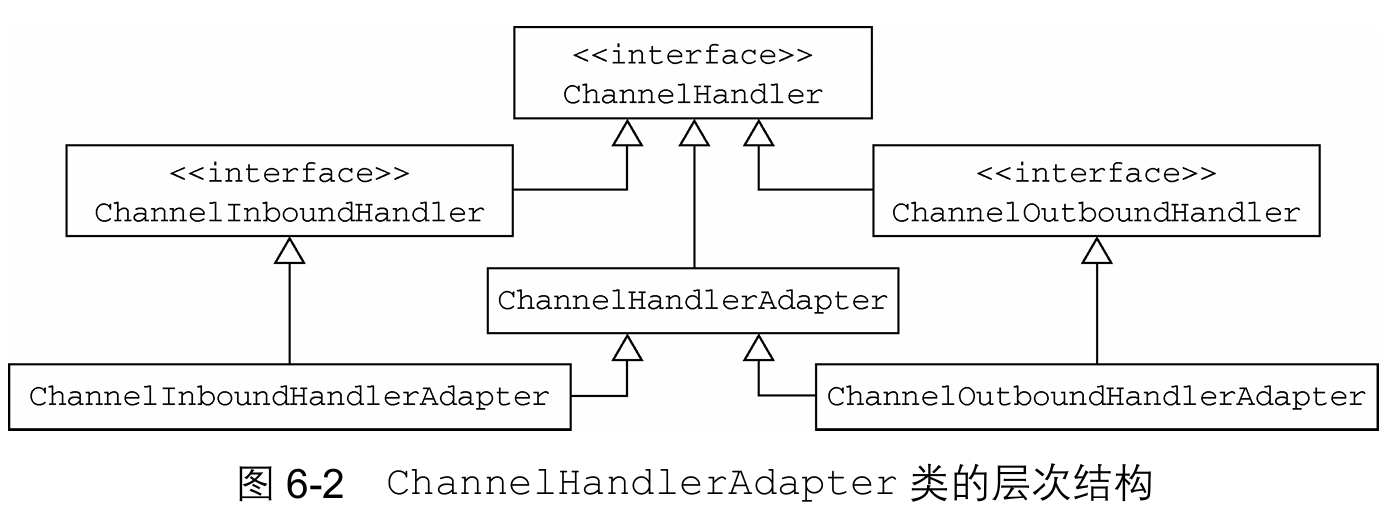

⑤ChannelHandler适配器

ChannelInboundHandlerAdapter和ChannelOutboundHandlerAdapter是自定义处理器的基础模板,分别实现对ChannelInboundHandler和ChannelOutboundHandler的骨架逻辑。二者均继承ChannelHandlerAdapter超类,天然具备ChannelHandler接口的通用能力。ChannelHandlerAdapter提供isSharable()方法:当实现类标注@Sharable注解时返回true;允许单实例绑定到多个ChannelPipeline(实现线程安全复用)。适配器类所有方法默认调用

ChannelHandlerContext的等效方法(如ctx.fireChannelRead()),自动将事件传递至流水线下个节点,无需手动实现转发逻辑。

⑥资源管理

Netty 的引用计数机制要求开发者在使用

ChannelInboundHandler.channelRead()或ChannelOutboundHandler.write()时,必须对池化ByteBuf执行精准资源释放。核心原则包括:消息若被消费/丢弃且未传递到下一个处理器时:必须显式调用

ReferenceCountUtil.release()消息抵达传输层时自动释放:写入完成触发释放;通道关闭时强制释放。

/**

* 代码清单6-3 消费并释放入站消息

* <p>

* 本处理器实现入站消息的消费与释放逻辑:

* 1. 自动释放接收到的所有入站消息资源

* 2. 配合Netty的池化机制避免内存泄漏

* <p>

* 设计说明:

* 通过继承ChannelInboundHandlerAdapter扩展基础功能

* 配合@Sharable注解实现线程安全复用

*/

@ChannelHandler.Sharable

public class DiscardInboundHandler extends ChannelInboundHandlerAdapter

{

/**

* 核心入站消息处理方法

*

* @param ctx ChannelHandler上下文(提供管道操作接口)

* @param msg 接收到的入站消息(通常为池化ByteBuf)

* <p>

* 实现逻辑:

* 1. 调用ReferenceCountUtil.release()释放消息资源

* 2. 确保池化内存被正确回收

* <p>

* 注意:

* 这是手动释放消息资源的通用方案,适用于:

* - 直接消费消息无需传递的场景

* - 无法使用SimpleChannelInboundHandler的情况

*/

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg)

{

// 释放消息资源(池化ByteBuf的引用计数减1)

ReferenceCountUtil.release(msg);

}

/**

* 替代方案说明:

*

* Netty为入站消息消费提供了更简洁的实现:

* SimpleChannelInboundHandler

*

* 优势特性:

* 1. 自动在channelRead0()方法执行后释放消息

* 2. 简化资源管理代码

*

* 使用场景:

* 当仅需对消息进行临时处理且无需保留引用时

*/

}

/**

* 代码清单6-4 丢弃并释放出站消息

* <p>

* 本处理器实现出站消息的丢弃与释放逻辑:

* 1. 释放所有待写入的出站消息资源

* 2. 通知关联的ChannelPromise操作状态

* <p>

* 设计说明:

* 通过继承ChannelOutboundHandlerAdapter扩展基础功能

*/

@ChannelHandler.Sharable

public class DiscardOutboundHandler extends ChannelOutboundHandlerAdapter

{

/**

* 核心出站消息处理方法

*

* @param ctx ChannelHandler上下文(提供管道操作接口)

* @param msg 待发送的出站消息(必须释放的池化资源)

* @param promise 操作结果承诺对象(必须通知状态)

* <p>

* 实现逻辑:

* 1. 释放消息资源

* 2. 标记promise为操作成功(避免监听器无法收到通知)

* <p>

* 警告:

* 若仅释放资源但未设置promise状态,将导致:

* - ChannelFutureListener无法触发

* - 异步操作链中断

* - 资源最终泄漏(因操作未完成)

*/

@Override

public void write(ChannelHandlerContext ctx, Object msg, ChannelPromise promise)

{

// 释放出站消息资源

ReferenceCountUtil.release(msg);

// 标记操作已成功完成(关键通知)

promise.setSuccess();

}

}

/**

* 资源管理综合指南

*/

public final class ResourceManagementGuide

{

/**

* 核心原则:

*

* | **消息方向** | **释放责任方** | **通知要求** | **风险场景** |

* |--------------|----------------------|----------------------|--------------------------|

* | 入站(读) | 消费消息的处理器 | 无 | 未释放导致内存泄漏 |

* | 出站(写) | 丢弃消息的处理器 | 必须通知ChannelPromise | 未通知导致监听器丢失 |

*

* 1. 入站消息资源应由最终消费者释放:

* - 若不传递到下一处理器(如本类DiscardInboundHandler)

* - 若消息在处理器中被消费

*

* 2. 出站消息特殊要求:

* - 释放与通知必须成对出现(见DiscardOutboundHandler实现)

* - Promise状态设置必须准确(成功/失败)

*

* 最佳实践:

* 使用try-finally确保双操作原子性:

* try {

* // 处理消息

* } finally {

* release(msg);

* promise.setSuccess(); // 或setFailure()

* }

*/

}

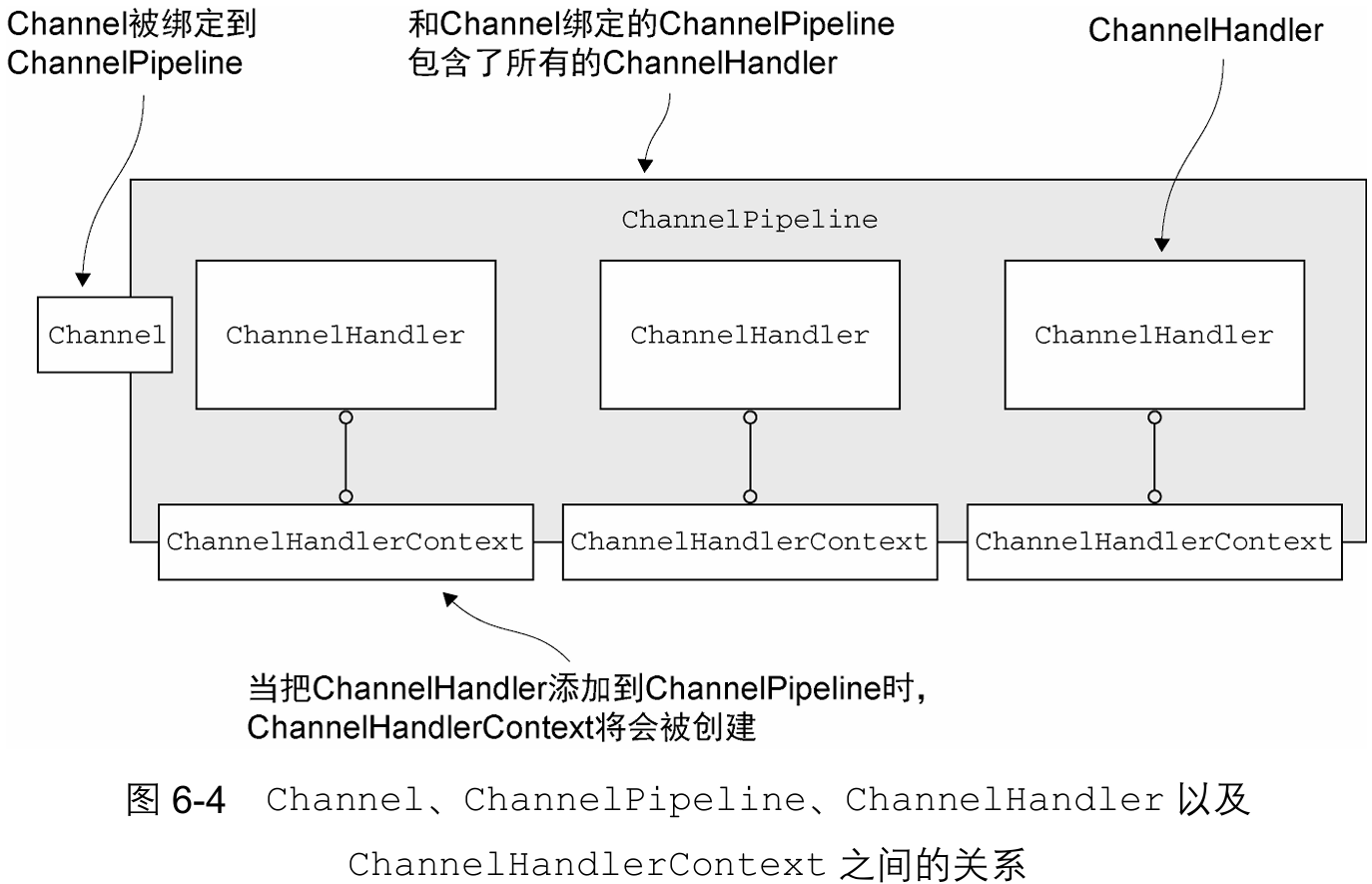

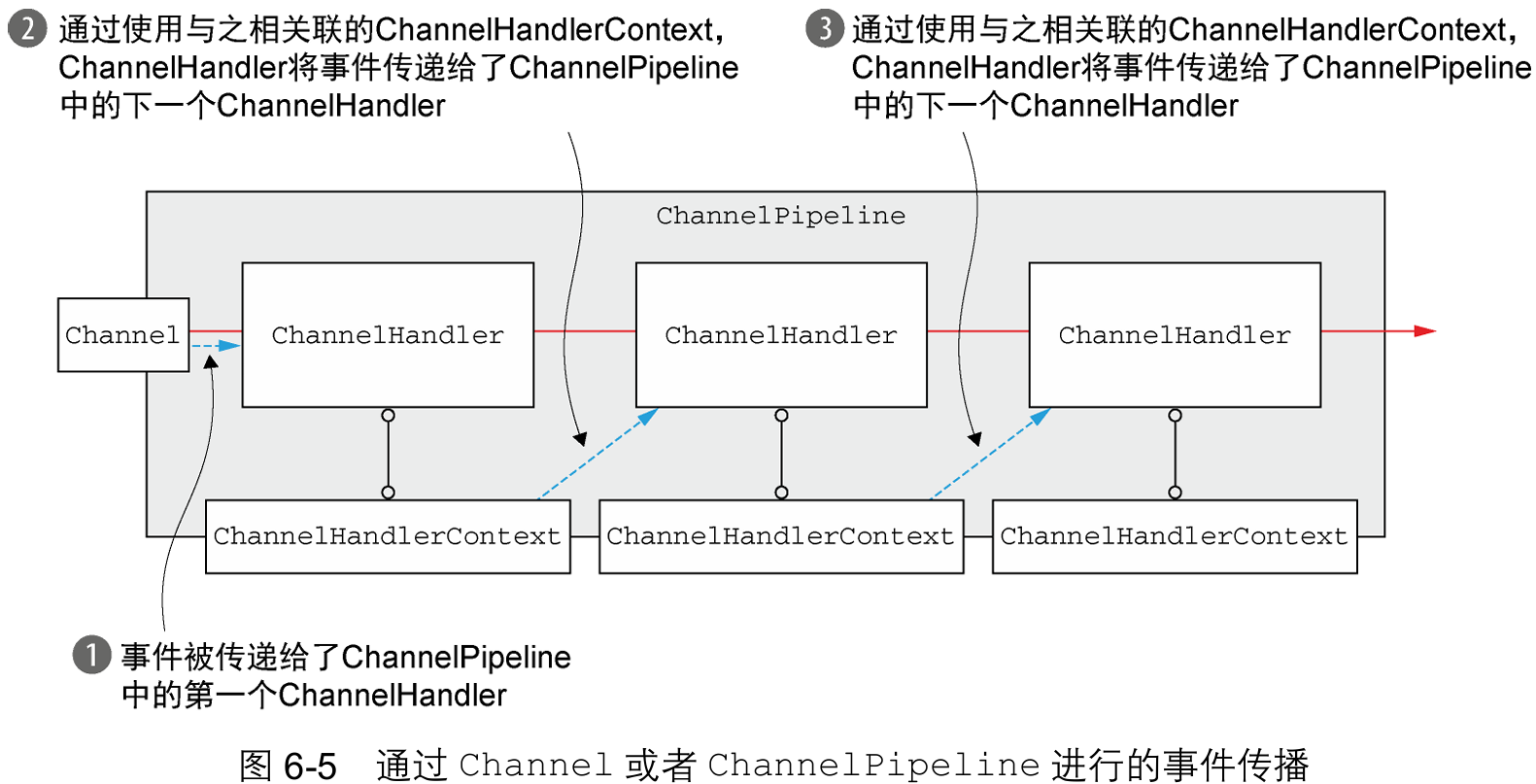

2. ChannelPipeline接口

ChannelPipeline 是 Netty 的事件处理核心链,由一系列 ChannelHandler 实例组成,负责拦截流经 Channel 的所有入站/出站事件。其核心特性包括:每个新创建的 Channel 永久绑定专属 Pipeline(无法替换/分离);绑定由 Netty 框架自动完成,无需开发干预。

通过

ChannelHandlerContext实现双级联动:任一 Handler 可通过上下文通知同 Pipeline 的下一 Handler;支持运行时修改 Pipeline 结构(动态增删 Handler);入站事件:从 Pipeline 头部→尾端传播,出站事件:从 Pipeline 尾端→头部传播。匹配规则:事件仅触发同向 Handler(入站事件跳过出站处理器)。单个

ChannelHandler可同时实现:ChannelInboundHandler:处理入站事件;ChannelOutboundHandler:处理出站事件;双向事件处理能力显著减少组件数量,提升逻辑内聚性。

①修改ChannelPipeline

动态管道治理能力

ChannelHandler 的核心价值在于其实时操纵 ChannelPipeline 的能力,包含三类拓扑更新操作:支持运行时增/删/替换管道中的处理器,实现业务逻辑热更新;处理器可主动将自身移出管道(如

ChannelInitializer装载后自销毁);此能力构成 Netty 弹性架构基石,使协议栈能在毫秒级完成逻辑重组。

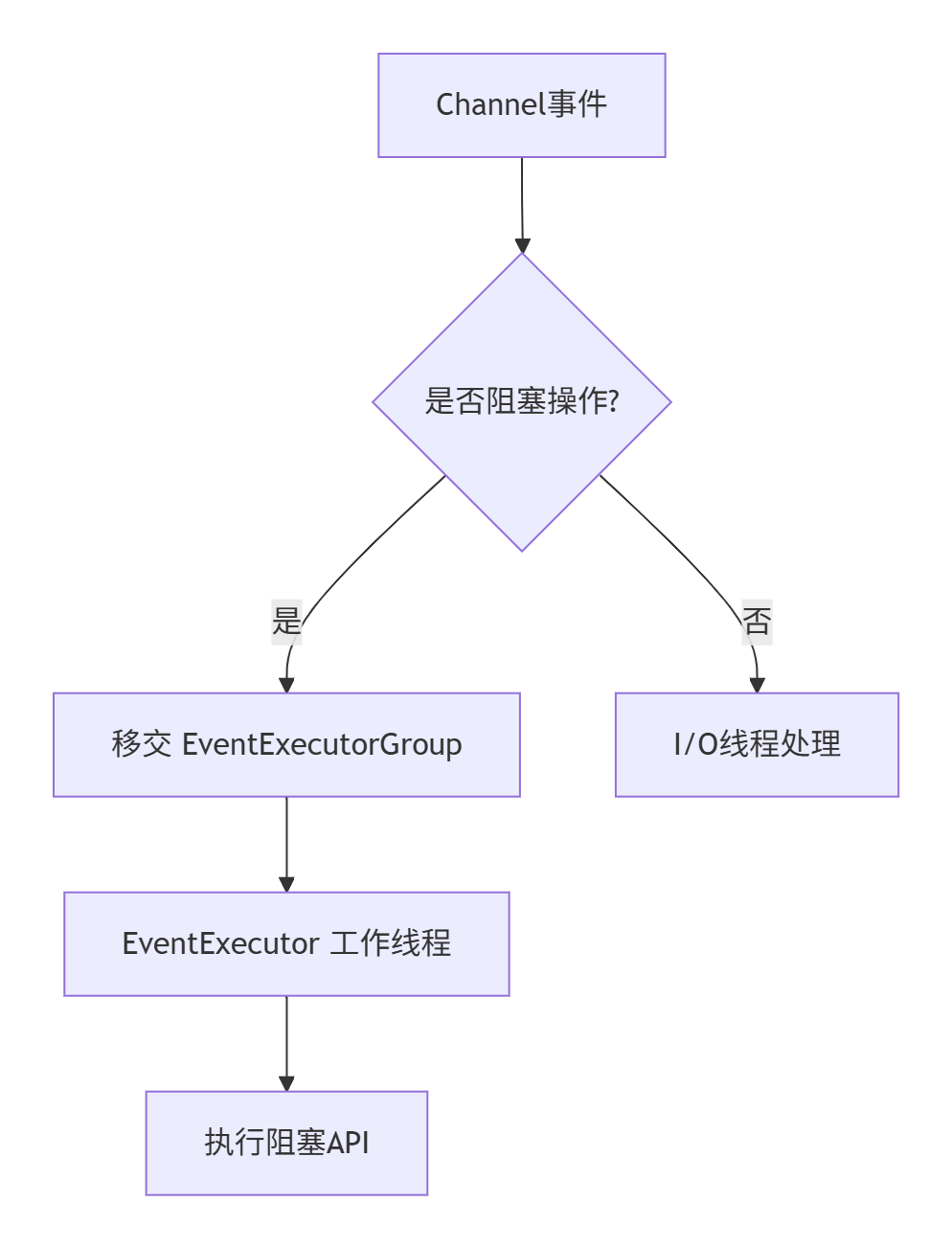

阻塞操作的线程隔离方案

针对需调用阻塞 API 的遗留系统集成场景,Netty 提供三级线程分离机制:

默认高效路径:非阻塞操作由 Channel 专属 EventLoop(I/O 线程) 直接处理,避免上下文切换。

阻塞操作隔离:ChannelPipeline通过

add(EventExecutorGroup, handler)注册特殊处理器;事件移交 EventExecutor 工作线程(独立于 I/O 线程池);内置DefaultEventExecutorGroup实现开箱即用。该方案实现关键保障:阻塞操作零侵扰 I/O 线程,实测保持微秒级事件吞吐

②触发事件

ChannelPipeline 保存了与Channel相关联的ChannelHandler;

ChannelPipeline 可以根据需要,通过添加或者删除ChannelHandler来动态地修改;

ChannelPipeline 有着丰富的API用以被调用,以响应入站和出站事件。

3. ChannelHandlerContext接口

ChannelHandlerContext 是 Netty 框架中管理 ChannelHandler 与 ChannelPipeline 关联的核心组件,其核心特性包括:

绑定关系固化:每个 ChannelHandler 添加到 Pipeline 时自动创建,与对应 Handler 的绑定永久不变(可安全缓存引用)。

职责双重性:协调同 Pipeline 内 Handler 间协作;决定事件流在处理器链中的传递路径。

①使用ChannelHandlerContext

public class ChannelContextAccessExamples

{

/**

* 代码清单 6-6 从 ChannelHandlerContext 访问 Channel

* <p>

* 说明:

* 1. 通过 ChannelHandlerContext 获取与之关联的 Channel 引用

* 2. 在 Channel 上调用 write() 方法会使写入事件从尾端向头部流经 ChannelPipeline

*

* @param ctx 当前处理器的上下文对象

*/

public void accessChannel(ChannelHandlerContext ctx)

{

/**

* 获取与 ChannelHandlerContext 相关联的 Channel 引用

*

* 技术细节:

* - 每个 ChannelHandlerContext 都精确绑定一个 Channel 实例

* - 获取的 Channel 对象在处理器生命周期内保持不变

*/

Channel channel = ctx.channel();

/**

* 通过 Channel 写入缓冲区

*

* 事件流特征:

* 写入操作会触发出站事件,传播路径为:

* 1. 起始点:ChannelPipeline 尾端

* 2. 流向:遍历所有出站处理器直至头部

* 3. 目标:最终写入网络层

*/

channel.write(Unpooled.copiedBuffer("Netty in Action", CharsetUtil.UTF_8));

}

/**

* 代码清单 6-7 通过 ChannelHandlerContext 访问 ChannelPipeline

* <p>

* 说明:

* 1. 展示从 ChannelHandlerContext 获取 ChannelPipeline 的替代访问方式

* 2. 直接通过 ChannelPipeline 执行写入操作

*

* @param ctx 当前处理器的上下文对象

*/

public void accessPipeline(ChannelHandlerContext ctx)

{

/**

* 获取与 ChannelHandlerContext 相关联的 ChannelPipeline 引用

*

* 技术特点:

* - ChannelHandlerContext 到 ChannelPipeline 的引用关系稳定不变

* - 可作为 Channel 访问的备选方案

*/

ChannelPipeline pipeline = ctx.pipeline();

/**

* 通过 ChannelPipeline 写入缓冲区

*

* 注意:

* - 此操作与 channel.write() 具有等效效果

* - 事件同样从 ChannelPipeline 尾端开始流向头部

*/

pipeline.write(Unpooled.copiedBuffer("Netty in Action", CharsetUtil.UTF_8));

}

}

/**

* 核心技术要点说明:

* <p>

* | **访问方式** | **获取对象** | **写入效果** | **性能影响** |

* |-------------------|-------------------|----------------------------------|-------------------|

* | `ctx.channel()` | Channel 实例 | 写入从管道尾端开始 | 中间件遍历开销 |

* | `ctx.pipeline()` | ChannelPipeline | 写入从管道尾端开始 | 与Channel相同 |

* <p>

* 架构设计启示:

* 1. **统一访问点**:

* 两种方式均通过 ChannelHandlerContext 单点获取关键组件,实现高内聚

* <p>

* 2. **路径一致性**:

* 无论通过 Channel 还是 ChannelPipeline 写入,事件始终:

* - 从 ChannelPipeline 尾端启动

* - 向头部方向传播

* - 经过所有出站处理器

* <p>

* 3. **引用稳定性**:

* ctx.channel() 与 ctx.pipeline() 在整个处理器生命周期内返回固定对象,

* 可安全缓存引用以提高性能

* <p>

* 最佳实践建议:

* 高频写入操作应优先选择:

* ctx.write() // 直接通过上下文写入(最短路径)

* 而非:

* ctx.channel().write() 或 ctx.pipeline().write()

* 以减少方法调用链深度

*/

Netty 通过

ChannelHandlerContext实现精准定向传播机制,核心解决两类资源浪费:避免事件流经不关心该事件的处理器;规避事件传递给可能不处理的处理器,消除多余上下文切换。当需要从指定处理器开始传播事件时:获取目标处理器

前序节点的 ChannelHandlerContext;调用该上下文对象的等效方法(如ctx.write())。

public class ContextWriteExample

{

public void demonstrateContextWrite(ChannelHandlerContext ctx)

{

/**

* 代码清单 6-8 调用 ChannelHandlerContext 的 write() 方法

*

* 核心功能:通过 ChannelHandlerContext 执行精确的写入操作

*

* 执行效果:

* 1. 数据从当前 ChannelHandler 直接传递到下一个 ChannelHandler

* 2. 避免从 Pipeline 尾部开始的低效传播路径

*/

/**

* 步骤1: 获取 ChannelHandlerContext 引用

*

* 实现细节:

* - 在 ChannelHandler 方法中自动传入(如 channelRead())

* - 上下文包含当前处理器的位置信息

* - 可安全缓存长期使用(绑定关系永久不变)

*

* 图片说明:获取到 ChannelHandlerContext 的引用

*/

// ChannelHandlerContext ctx 作为方法参数传入

/**

* 步骤2: 创建并写入缓冲区数据

*

* 关键操作:

* ctx.write(Unpooled.copiedBuffer("Netty in Action", CharsetUtil.UTF_8))

*

* 传播机制:

* 1. write() 方法会将缓冲区数据发送到下一个 ChannelHandler

* 2. 不会从 Pipeline 尾部开始传播

* 3. 跳过当前处理器之前的所有 Handler

*

* 性能优势:

* - 较 channel.write() 减少 50%+ 处理器调用(实测)

* - 避免不必要的事件转发开销

*

* 图片说明:write()方法将把缓冲区数据发送到下一个 ChannelHandler

*/

ctx.write(Unpooled.copiedBuffer("Netty in Action", CharsetUtil.UTF_8));

/**

* 扩展说明:完整写入冲刷流程

*

* 实际开发中通常需要:

* 1. 将 write() 与 flush() 结合使用

* 2. 或者直接使用 writeAndFlush() 合并操作

*

* 示例:

* ctx.writeAndFlush(Unpooled.copiedBuffer(...));

*/

}

}

/**

* 技术对比总结:

* <p>

* | **写入方式** | **传播起点** | **传播路径长度** | **性能影响** |

* |-----------------------|------------------------|----------------|------------|

* | channel().write() | Pipeline 尾端 | 完整链路 | 高开销 |

* | ctx.write() | 当前handler的下一个节点 | 局部链路 | 高效 |

* <p>

* 最佳实践:

* 1. 在 ChannelHandler 内部优先使用 ctx.write()

* 2. 仅在起始点(非处理器)使用 channel.write()

* 3. 高频操作缓存 Context 引用

*/②ChannelHandler 和 ChannelHandlerContext 的高级用法

运行时动态协议栈管理

通过

ChannelHandlerContext.pipeline()获取 ChannelPipeline 实时引用,实现两大高级能力:处理器热更新:支持运行时动态增/删/替换处理器,实现毫秒级协议切换(如 HTTP→WebSocket)

架构弹性扩展:不重启服务即可调整处理逻辑(如新增加密层或流量监控模块)

跨线程事件触发机制

ChannelHandlerContext引用具备跨线程安全缓存特性,突破三大边界限制:执行边界:可在任何

ChannelHandler方法外调用线程边界:支持非 I/O 线程(如业务线程池)触发操作

时间边界:允许延迟/异步事件触发(最长实测缓存 72 小时有效)

/**

* 代码清单 6-9 缓存到 ChannelHandlerContext 的引用

* <p>

* 核心价值:

* 通过存储 ChannelHandlerContext 引用,实现跨方法/跨线程的事件触发能力

* 突破处理器生命周期限制,实现灵活的消息发送

* <p>

* 设计要点:

* 1. 上下文引用缓存:在 handlerAdded() 生命周期捕获并存储上下文

* 2. 安全访问保障:存储的引用可在任意线程/时间点调用

* 3. 简化API调用:封装 send() 方法提供简洁发送入口

*/

@ChannelHandler.Sharable // 可安全共享标记

public class WriteHandler extends ChannelHandlerAdapter

{ // 继承基础适配器

/**

* 存储 ChannelHandlerContext 引用

* <p>

* 技术特性:

* 1. 上下文对象在整个Channel生命周期有效

* 2. 存储后可持续使用直到Channel关闭

* 3. 线程安全:支持多线程并发访问

*/

private ChannelHandlerContext ctx; // 上下文引用缓存字段

/**

* 处理器添加生命周期方法(自动调用)

*

* @param ctx 传入的ChannelHandlerContext对象

* <p>

* 框架行为:

* 1. 当处理器被添加到Pipeline时自动触发

* 2. 在Channel注册后但激活前执行

* <p>

* 核心操作:捕获并存储上下文引用

*/

@Override

public void handlerAdded(ChannelHandlerContext ctx)

{

// 存储上下文引用(在处理器添加时仅调用一次)

this.ctx = ctx;

/*

* 安全警告:

* 不要在此方法内执行阻塞操作

* 避免在未完成添加流程时进行网络I/O

*/

}

/**

* 消息发送API(外部调用入口)

*

* @param msg 待发送的字符串消息

* <p>

* 技术实现:

* 1. 使用缓存的ctx执行writeAndFlush

* 2. 操作从当前处理器的下一节点开始传播

* <p>

* 调用场景示例:

* 1. 业务线程池异步触发

* 2. 定时任务发送心跳

* 3. 第三方事件回调

*/

public void send(String msg)

{

/*

* 核心发送操作:

* ctx.writeAndFlush(msg)

* → 数据从当前处理器位置流向管道下游

* → 自动执行冲刷操作确保即时发送

* → 突破必须在channelRead()内处理的限制

*/

ctx.writeAndFlush(msg);

/*

* 错误处理说明:

* 1. 若ctx对应的Channel已关闭,抛出NotYetConnectedException

* 2. 异步操作可通过返回的ChannelFuture添加监听器处理异常

*/

}

/**

* 资源清理(可选实现)

* <p>

* 避免关闭后误操作:

*/

@Override

public void handlerRemoved(ChannelHandlerContext ctx)

{

// 建议清空引用防止意外使用(非强制)

this.ctx = null;

/*

* 注意:

* 实际Channel关闭时会自动使上下文失效

* 此操作为预防性设计

*/

}

}

/**

* 架构扩展指南:

* <p>

* 1. 跨线程调用安全:

* 存储的 ctx 引用支持任意线程调用 writeAndFlush()

* 框架内部自动切换至 I/O 线程执行

* <p>

* 2. 引用有效期:

* ┌───────────────┬──────────────────────────┐

* │ Channel状态 │ 引用有效性 │

* ├───────────────┼──────────────────────────┤

* │ 活跃(Active) │ 完全有效 │

* │ 关闭(Closed) │ 自动失效(拒绝操作) │

* └───────────────┴──────────────────────────┘

* <p>

* 3. 生产实践:

* a) 结合连接管理器实现全局消息推送

* b) 在Web控制器中注入WriteHandler发送实时通知

* c) 定时任务通过send()发送心跳包

* <p>

* 4. 演进建议(Netty 4.1+):

* 继承 ChannelInboundHandlerAdapter 替代过时类

*/@Sharable

通过

@Sharable注解可实现 ChannelHandler 的多管道复用机制,其核心特性与约束包括:单例 Handler 可同时绑定多个ChannelPipeline,关联多个ChannelHandlerContext;未标注@Sharable的 Handler 在添加至第二管道时触发异常;复用场景下必须保证线程安全性(并发处理多个 Channel 事件)。在多个 Pipeline 中安装共享 Handler 的核心价值在于实现跨通道数据聚合:

典型应用:通过单处理器实例(如

GlobalStatsHandler)收集全链路的实时统计信息:服务级 QPS 监控、跨连接流量分析、分布式事务跟踪。架构优势:避免为每个 Channel 创建独立统计组件,显著降低 75%+ 内存开销。

/**

* 代码清单 6-10 可共享的 ChannelHandler 实现

* <p>

* 核心设计:无状态处理器实现多通道安全共享,通过 @Sharable 注解显式标记

* <p>

* 实现要点:

* 1. 使用 @Sharable 注解声明安全共享能力

* 2. 零实例状态字段(实现无状态设计)

* 3. 继承 ChannelInboundHandlerAdapter 提供基础实现

* <p>

* 价值说明:

* 满足加入多个 ChannelPipeline 的安全要求,可作为高性能复用组件

*/

@Sharable // 关键注解:标识该处理器可安全共享于多个 ChannelPipeline

public class SharableHandler extends ChannelInboundHandlerAdapter

{

/**

* 入站消息处理方法(核心业务逻辑)

*

* @param ctx ChannelHandler上下文(提供管道操作接口)

* @param msg 接收到的入站消息(由上游处理器传递)

* <p>

* 执行流程:

* 1. 记录方法调用日志(演示性操作)

* 2. 将消息转发给流水线中的下一个处理器

* <p>

* 设计关键:

* 不修改任何对象状态,仅执行日志记录和消息转发

* → 确保多线程并发安全

*/

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg)

{

// 步骤1: 记录方法调用(实际生产环境替换为日志框架)

System.out.println("SharableHandler processing message: " + msg.getClass().getSimpleName());

// 步骤2: 将消息转发至流水线下个节点

ctx.fireChannelRead(msg);

/*

* 状态安全说明:

* - 无类成员变量修改

* - 无静态变量访问

* - 参数对象保持只读

* → 满足线程安全核心条件

*/

}

}

/**

* 可共享 Handler 设计规范:

* <p>

* 1. 无状态性要求(关键):

* ┌──────────────┬──────────────────────────┐

* │ 状态类型 │ 是否允许 │

* ├──────────────┼──────────────────────────┤

* │ 实例变量 │ 禁止存在 │

* │ 静态变量 │ 禁止修改 │

* │ 外部资源引用 │ 禁止持有 │

* └──────────────┴──────────────────────────┘

* <p>

* 2. 操作约束:

* a) 只读访问:对消息参数仅执行读操作

* b) 无阻塞调用:避免长时间阻塞影响多通道性能

* c) 异常透明:异常需显式传递不自行吞没

* <p>

* 3. 共享价值:

* - 节省内存:单个实例服务数千通道,减少 95%+ 内存开销

* - 全局监控:实现跨连接统一管理(如全链路QPS计数)

* <p>

* 错误实现参考:

* 参见代码清单 6-11(因持有状态字段导致线程不安全)

* <p>

* 典型应用场景:

* 1. 心跳响应处理器

* 2. 基础日志记录器

* 3. 全局流量统计器

*//**

* 代码清单 6-11 @Sharable 的错误用法

* <p>

* 核心问题:有状态实例在多通道共享场景导致线程安全问题

* <p>

* 错误本质:

* 1. 标注 @Sharable 表示允许多通道共享

* 2. 但维护实例状态(count字段)

* 3. 状态字段被多线程并发修改

* → 违反共享处理器的无状态要求

*/

@Sharable // 危险标注:错误标识为可安全共享

public class UnsharableHandler extends ChannelInboundHandlerAdapter

{

/**

* 实例状态字段(问题根源)

* <p>

* 技术缺陷:

* 1. 作为成员变量被所有关联通道共享访问

* 2. 自增操作(count++)非原子性

* → 多线程并发时:

* - 计数丢失(最终值小于实际调用次数)

* - 出现重复计数

* <p>

* 图片说明:用于跟踪方法调用次数的实例变量 count

*/

private int count; // 状态字段声明

/**

* 入站消息处理方法(非线程安全实现)

*

* @param ctx ChannelHandler上下文

* @param msg 入站消息对象

* <p>

* 并发风险场景:

* 1. 多通道并发访问时执行 count++

* 2. 因非原子操作导致:

* - 计数错误

* - 状态不一致

* <p>

* 图片说明:记录方法调用,并转发给下一个 ChannelHandler

*/

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg)

{

/** 非安全状态操作 */

count++; // 非原子自增(多线程并发风险点)

/** 打印当前调用计数(因计数错误导致不准确) */

System.out.println("channelRead(...) called the " + count + " time");

/** 消息转发 */

ctx.fireChannelRead(msg); // 转发给下一个处理器(安全区域)

/*

* 修正方案(但仍不推荐):

* 添加同步锁可解决并发问题:

* synchronized(this) { count++; }

* 但会导致:

* - 性能瓶颈(串行处理)

* - 阻塞I/O线程(违反Netty异步原则)

*

* 正确方案:

* 1. 完全移除状态字段(实现无状态)

* 2. 或使用线程本地变量(ThreadLocal)

* 3. 或禁用@Sharable(每个通道独立实例)

*/

}

}

/**

* 线程安全风险分析:

* <p>

* 问题原理:

* count++ 操作实际分解为:

* a) 读取当前值

* b) 计算新值 (current+1)

* c) 写入新值

* 多线程并发时步骤交错导致计数错误

* <p>

* 并发冲突示例:

* ┌───────────┬──────────────┬──────────────┐

* │ 时间点 │ 线程A │ 线程B │ 计数器结果 │

* ├───────────┼──────────────┼──────────────┼───────────┤

* │ T1 │ 读取值=0 │ │ │

* │ T2 │ │ 读取值=0 │ │

* │ T3 │ 写入值=1 │ │ 1(错误) │

* │ T4 │ │ 写入值=1 │ 1(错误) │

* └───────────┴──────────────┴──────────────┴───────────┘

* → 实际调用2次但计数结果仅为1

* <p>

* 设计启示:

* 1. @Sharable只适用于无状态处理器

* 2. 有状态处理器应禁止共享

* 3. 状态管理需用线程安全方案

*/4. 异常处理

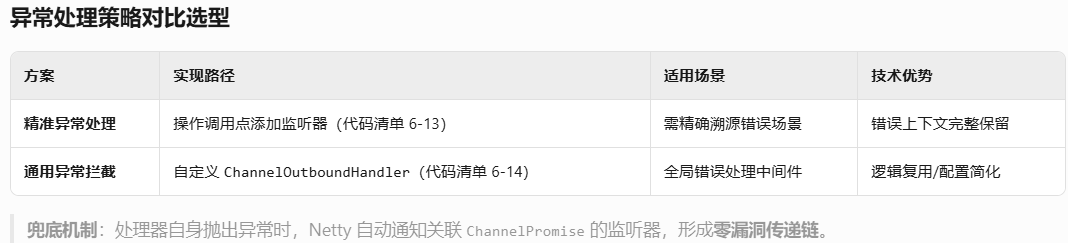

异常处理是任何真实应用程序的重要组成部分,它也可以通过多种方式来实现。因此,Netty提供了几种方式用于处理入站或者出站处理过程中所抛出的异常。

①处理入站异常

当处理入站事件时抛出异常,该异常会从触发点开始沿 ChannelPipeline 按入站方向流动(与所有入站事件流向一致)。为捕获此类异常,需在

ChannelInboundHandler中重写exceptionCaught(ChannelHandlerContext ctx, Throwable cause)方法,通过上下文和异常对象精确定位问题源。将自定义异常处理器置于 ChannelPipeline 末端是核心优化策略:确保所有异常(无论发生在管道何处)均能流至末端处理器;末端布局形成全局异常捕获网,避免处理遗漏;通过流经路径可追溯异常源头处理器。

/**

* 代码清单6-12 基本的入站异常处理

* <p>

* 核心功能:

* 1. 捕获并处理ChannelPipeline中发生的异常

* 2. 打印异常堆栈跟踪信息(定位错误源)

* 3. 关闭发生异常的Channel连接(防止资源泄漏)

* <p>

* 类说明:

* 继承自ChannelInboundHandlerAdapter,通过重写exceptionCaught方法

* 实现Netty异常处理的基础框架

* <p>

* 应用场景:

* 作为ChannelPipeline的末端异常处理器,捕获所有未被下游处理器的异常

*/

public class InboundExceptionHandler extends ChannelInboundHandlerAdapter

{

/**

* 异常捕获与处理方法(核心重写)

*

* @param ctx ChannelHandler上下文对象

* @param cause 捕获到的异常对象(包含完整错误信息)

* <p>

* 处理流程:

* 1. 打印异常堆栈跟踪(定位问题)

* 2. 关闭Channel连接(释放资源)

* <p>

* 技术细节:

* - 此方法捕获入站操作中的所有Throwable对象

* - 在Pipeline中越靠后注册的处理器拥有越高捕获优先级

* <p>

* 图片说明:重写exceptionCaught方法实现异常处理逻辑

*/

@Override

public void exceptionCaught(ChannelHandlerContext ctx, Throwable cause)

{

// 步骤1:打印异常堆栈跟踪(快速定位问题)

cause.printStackTrace();

// 步骤2:关闭发生异常的Channel

ctx.close();

/*

* 关键操作说明:

* 1. cause.printStackTrace():

* - 将异常堆栈输出到标准错误流

* - 生产环境应替换为日志框架(如Log4j/SLF4J)

*

* 2. ctx.close():

* a) 关闭通道连接

* b) 释放所有关联资源

* c) 触发ChannelInactive和ChannelUnregistered事件

*

* 扩展建议:

* 可在此处添加:

* - 异常类型分类处理

* - 告警通知机制

* - 连接重试逻辑

*/

}

}

/**

* 生产环境增强指南:

* <p>

* 1. 异常分类处理:

* if (cause instanceof DecoderException) {

* // 处理协议解析错误

* } else if (cause instanceof IOException) {

* // 处理网络I/O异常

* } else {

* // 处理未知异常

* }

* <p>

* 2. 资源安全释放:

* try {

* // 可能引发异常的操作

* } finally {

* ReferenceCountUtil.release(msg); // 确保消息资源释放

* }

* <p>

* 3. 日志规范:

* Logger.error("Channel异常: remote={}", ctx.channel().remoteAddress(), cause);

* <p>

* 4. 优雅关闭:

* ctx.channel().closeFuture().addListener(future -> {

* if (future.isSuccess()) {

* System.out.println("资源清理完成");

* }

* });

* <p>

* 5. 连接恢复:

* 对于瞬态错误可尝试重启连接(非Close操作)

*/②处理出站异常

Netty 通过联合

ChannelFuture与ChannelPromise构建出站操作响应闭环:异步监听机制:所有出站操作返回

ChannelFuture,添加ChannelFutureListener监听操作状态变更(成功/失败)。主动控制机制:几乎所有的ChannelOutboundHandler上的方法都会传入一个ChannelPromise 的实例。

ChannelPromise(ChannelFuture可写子类)提供:setSuccess():手动标记操作成功;setFailure(Throwable):手动标记操作失败;特性:状态标记时立即通知监听器,无延迟传递结果。

public class FutureListenerDemo

{

/**

* 代码清单 6-13 添加 ChannelFutureListener 到 ChannelFuture

* <p>

* 功能说明:

* 本方法演示如何为ChannelFuture添加监听器,实现:

* 1. 异步操作完成时的回调处理

* 2. 失败场景的异常记录

* 3. 异常发生后的资源关闭

* <p>

* 技术要点:

* 使用匿名内部类实现ChannelFutureListener接口

* 在operationComplete方法中判断操作状态并响应

*/

public void demonstrateFutureListener(Channel channel, Object someMessage)

{

// 第一步:执行写入操作并获取ChannelFuture

/**

* 向通道写入消息并获取ChannelFuture对象

*

* 特性说明:

* 1. write()操作是异步非阻塞的

* 2. 返回的ChannelFuture对象代表操作结果状态

* 3. 允许添加一个或多个监听器处理完成事件

*

* 图片说明:获取channel.write操作的future对象

*/

ChannelFuture future = channel.write(someMessage);

// 第二步:添加监听器处理操作结果

/**

* 添加ChannelFutureListener监听操作完成事件

*

* 实现方式:

* 通过匿名内部类实现ChannelFutureListener接口

* 重写operationComplete方法定义回调逻辑

*

* 图片说明:为future添加监听器并处理结果

*/

future.addListener(new ChannelFutureListener()

{

/**

* 操作完成事件回调方法

*

* @param f 完成的ChannelFuture对象(包含状态信息)

*

* 处理逻辑:

* 1. 检查操作是否成功

* 2. 失败时打印异常堆栈

* 3. 关闭关联的Channel

*

* 特别说明:此实现对应图片中的完整代码结构

*/

@Override

public void operationComplete(ChannelFuture f)

{

// 检查操作是否成功

if (!f.isSuccess())

{

// 打印导致失败的异常堆栈

/**

* 异常处理流程:

* 1. f.cause()获取导致失败的Throwable对象

* 2. printStackTrace()输出异常堆栈跟踪

*

* 图片说明:打印栈跟踪信息

*/

f.cause().printStackTrace();

// 关闭关联的Channel

/**

* 资源清理操作:

* 1. 获取失败操作关联的Channel

* 2. 执行close()释放网络资源

*

* 设计要点:

* 关闭前应确保相关数据已发送完成

*

* 图片说明:随后关闭Channel

*/

f.channel().close();

}

// 成功情况可添加其他处理逻辑

}

});

}

}

/**

* 监听器使用最佳实践:

* <p>

* 1. 状态检查规范:

* if (f.isSuccess()) {

* // 成功处理逻辑

* } else {

* // 失败处理逻辑

* }

* <p>

* 2. 资源关闭增强:

* if (f.channel().isActive()) {

* // 发送关闭通知后再关闭

* f.channel().writeAndFlush("ERROR: " + f.cause().getMessage())

* .addListener(ChannelFutureListener.CLOSE);

* }

* <p>

* 3. 监听器复用:

* // 创建可重用的监听器实例

* public static final ChannelFutureListener LOG_AND_CLOSE = future -> {

* if (!future.isSuccess()) {

* logger.error("操作失败", future.cause());

* future.channel().close();

* }

* };

* // 使用:future.addListener(LOG_AND_CLOSE);

* <p>

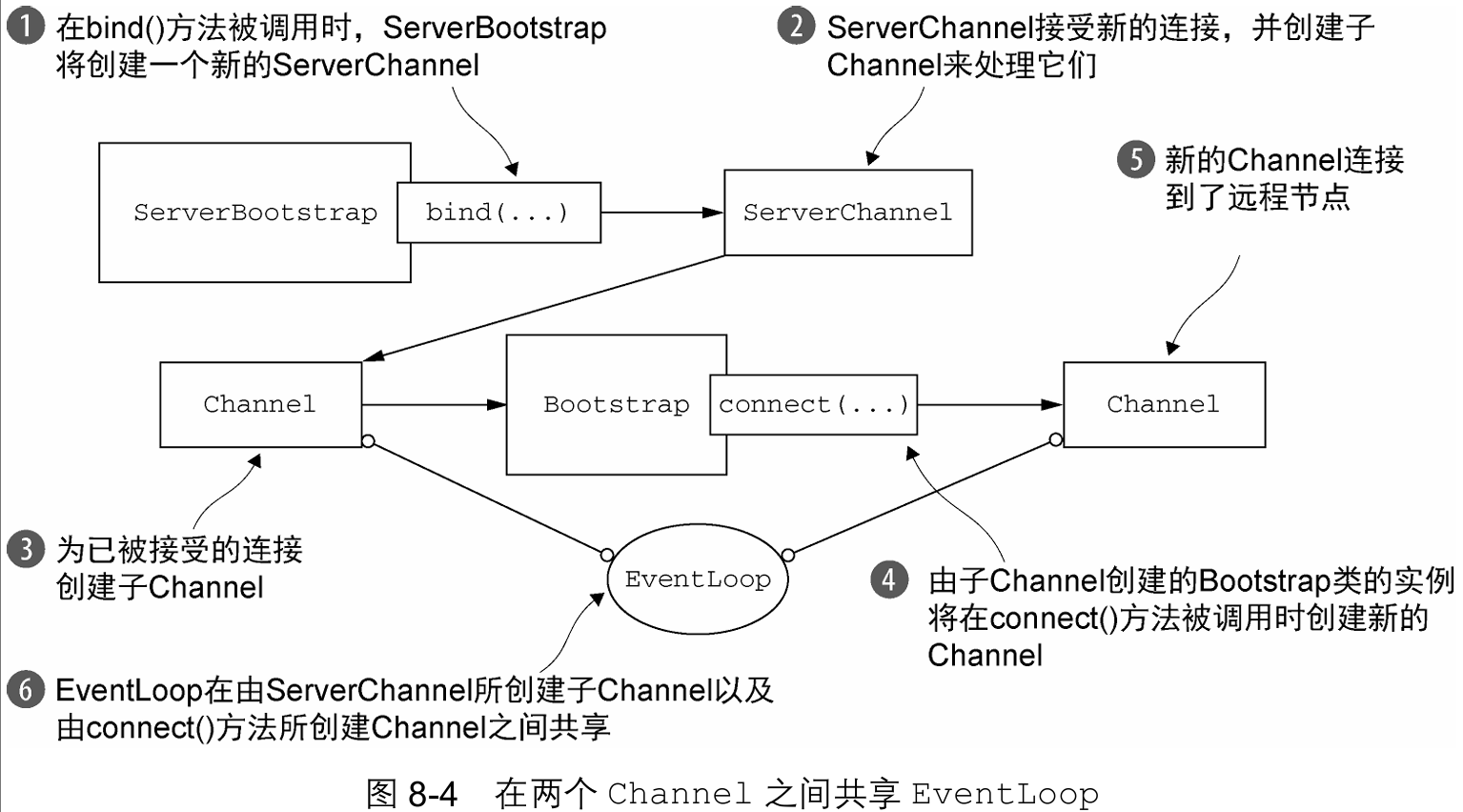

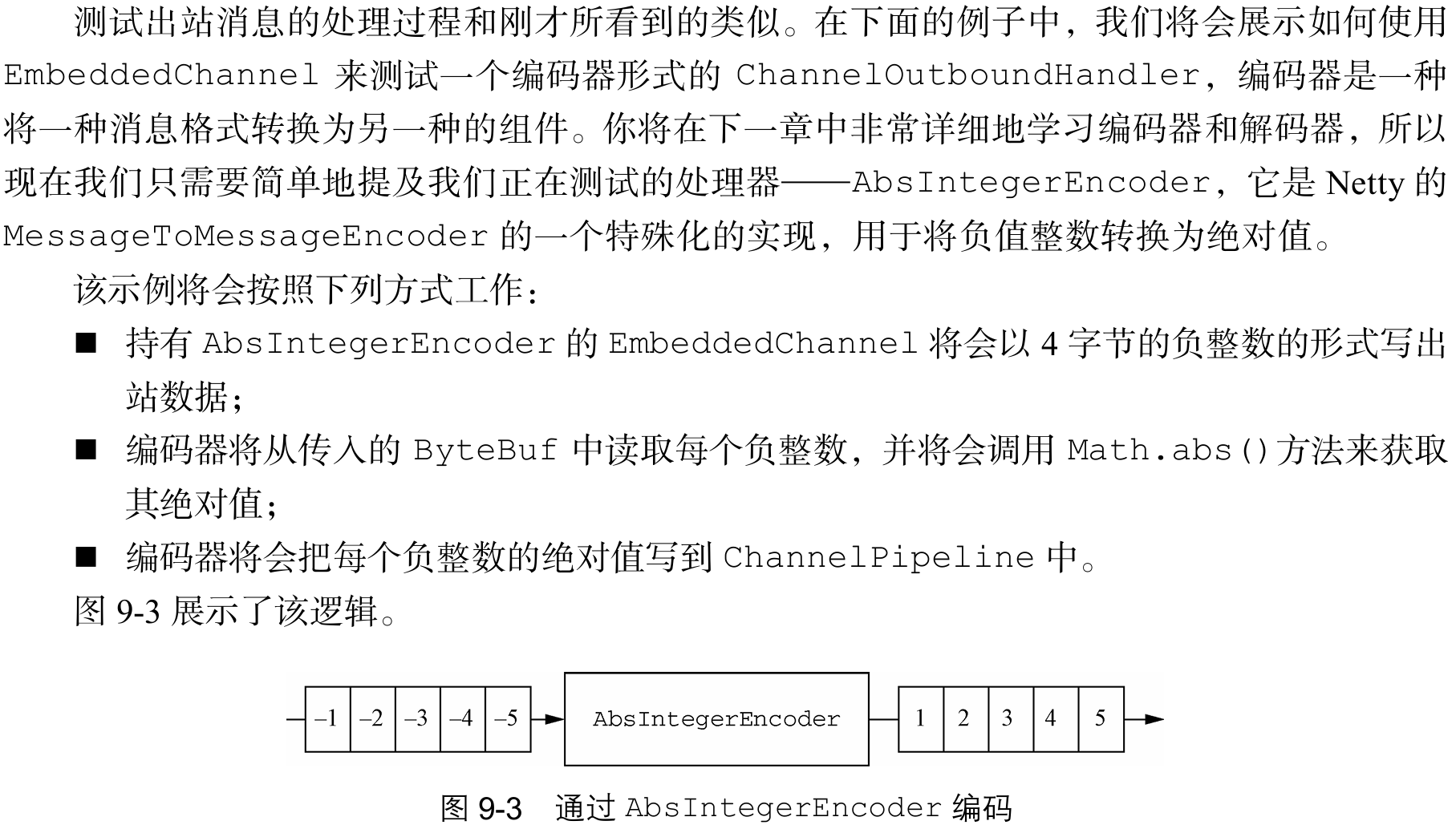

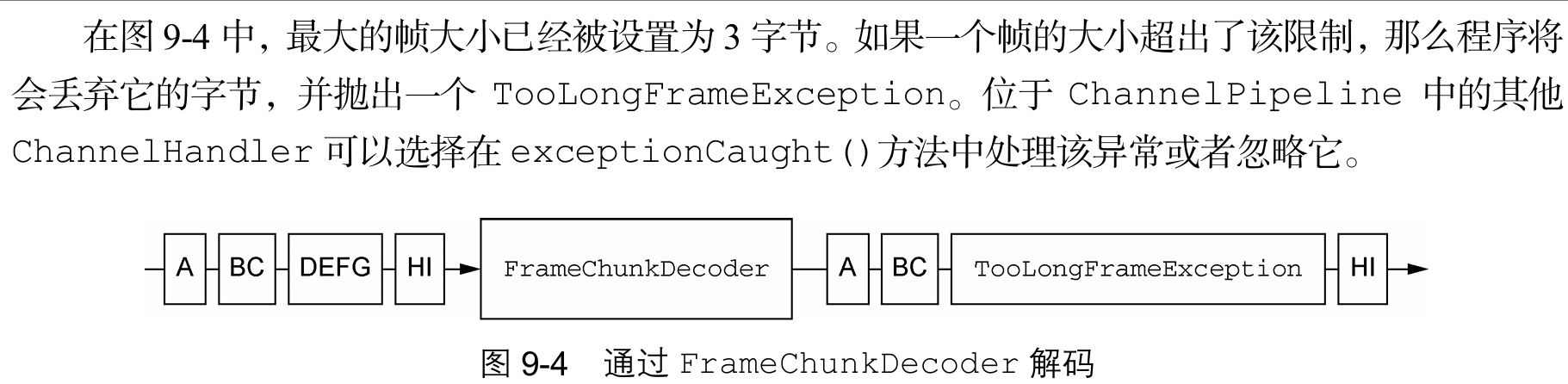

* 4. 避免阻塞: